> wordCountResult = tupleWords.groupBy(0).sum(1);

wordCountResult.print();

}

}

```

3)流处理版本的Word Count:基于DataStream API,只需要指定模式就可以了。

```java

/**

* 基于无界流处理实现的word count.

*

* 使用netcat来实时的发送数据流.

* command: nc -kl 7777

*

* @author code1997

*/

public class StreamUnboundWordCount {

public static final String HOST_NAME = "host";

public static final String PORT = "port";

public static void main(String[] args) throws Exception {

//1.创建执行环境

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

//2.读取数据源文件

ParameterTool parameterTool = ParameterTool.fromArgs(args);

String hostname = parameterTool.get(HOST_NAME);

int port = parameterTool.getInt(PORT);

DataStreamSource socketTextStream = executionEnvironment.socketTextStream(hostname, port);

StreamUtils.printWordCount(socketTextStream);

//5.启动执行

executionEnvironment.execute();

}

}

/**

* 流处理API打印word count的结果

* @param streamSource

*/

public static void printWordCount(DataStreamSource streamSource) {

SingleOutputStreamOperator> tuple2Words = streamSource.flatMap((FlatMapFunction>) (s, collector) -> {

String[] words = s.split(" ");

for (String word : words) {

collector.collect(Tuple2.of(word, 1L));

}

}).returns(Types.TUPLE(Types.STRING, Types.LONG));

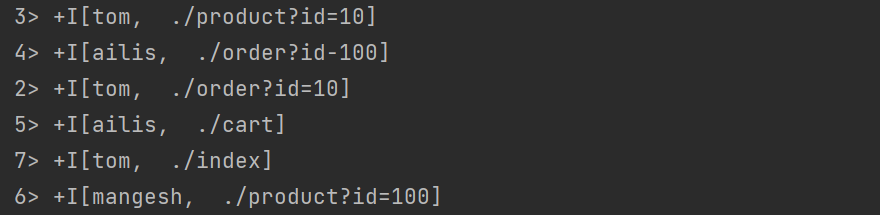

SingleOutputStreamOperator> streamBoundWordCountResult = tuple2Words.keyBy((KeySelector, Object>) stringLongTuple2 -> stringLongTuple2.f0).sum(1);

/**

* 输出操作:更新状态,前面的编号指的是执行的线程. 在flink中资源的单位是slot槽.分组之后会将同组的放到同一个分区子任务上.

* 4> (java,1)

* 16> (flink,1)

* 11> (world,1)

* 6> (hello,1)

* 6> (hello,2)

* 6> (hello,3)

*/

streamBoundWordCountResult.print();

}

```

### 2 Flink部署

> 本章主要是flink的部署

#### 2.1 Flink的部署模式

- 会话模式(session mode):集群先启动起来,在启动之后资源已经被确定,如果提交job的时候发现资源不够用就会提交任务失败,存在集群中多个job发生竞争的现象。适合于单个规模小,执行时间短的大量作业。

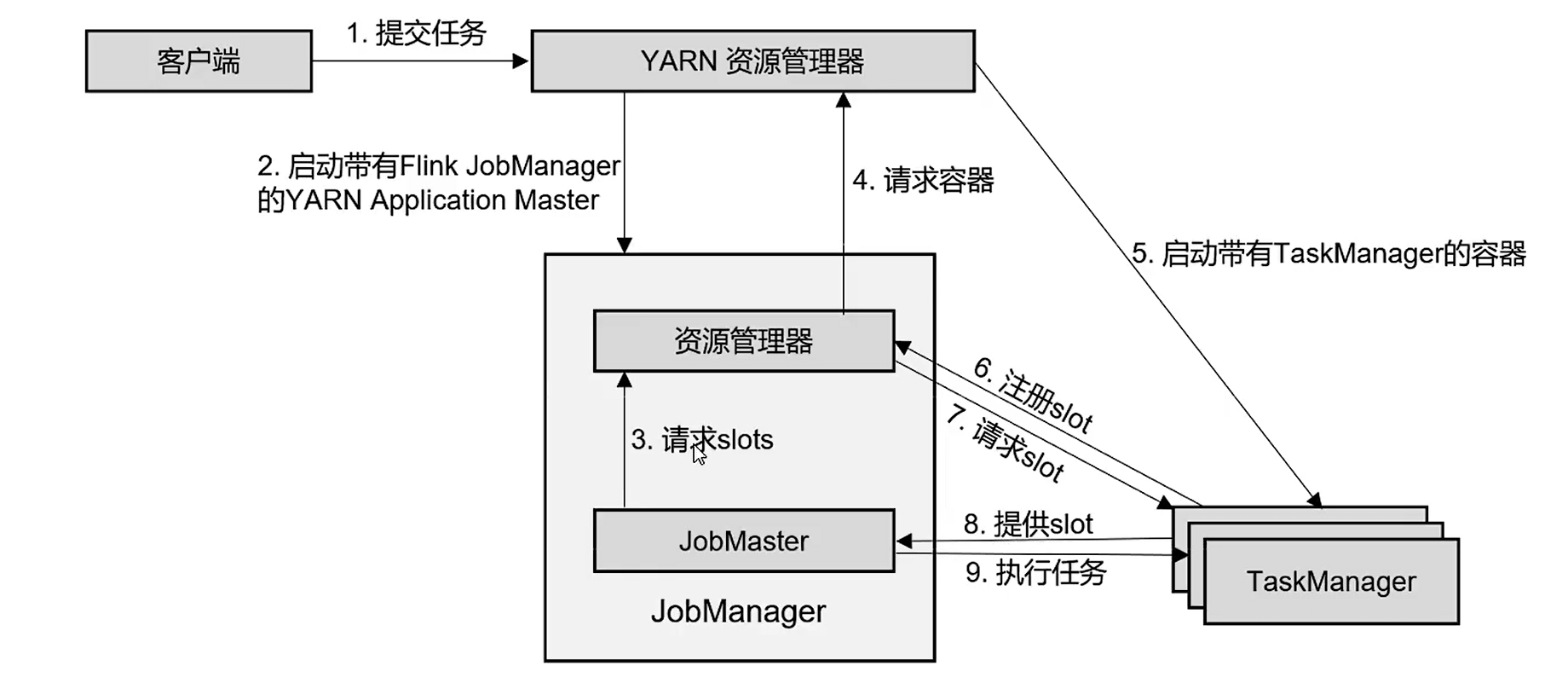

- 单作业模式(Per-Job mode):严格的一对一,集群为这个作业而生,可以实现资源的隔离,可以使得作业在生产环境中更加稳定。每一个作业提交之后,就启动一个集群,适合于单个规模大,执行时间长的作业,需要和其他的资源管理框架结合使用。

- 应用模式(Application mode):前两种模式下,应用代码执行在客户端上,然后客户端提交给Job Manager,这种方式客户端需要占用大量网络带宽(下载依赖和二进制数据传输)。因为提交作业使用的是同一个客户端,会加重客户端所在的节点的资源消耗。应用模式不需要客户端,直接将应用提交到Job Manager上运行,Job Manager为job而生,每提交一个job,就启动一个Job Manager;job执行结束,Job Manager就关闭了,这就是所谓的应用模式。

1. 将jar包放到`lib`目录下

2. 启动JobManager

```shell

./bin/standalone-job.sh --job-classname 全类名

```

3. 启动taskManager

```shell

./bin/taskmanager.sh start

```

4. 停止集群

```shell

./bin/standalone-job.sh stop

./bin/taskmanager.sh stop

```

#### 2.2 standlone模式

> 前提:三台虚拟机,配置好静态ip,关闭防火墙,jdk,免密登录

>

> flink版本选择:1.13.6

集群规划:

| hostname | role |

| -------- | --------------------------- |

| hadoop02 | Job Manager: job管理和规划 |

| hadoop03 | Task Manager:干活的 |

| hadoop04 | Task Manager:干活的 |

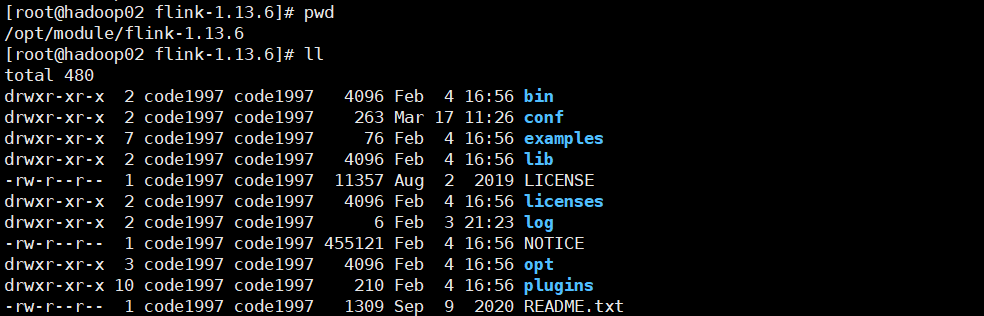

1 上传tar包并解压

2 修改`con/flink-conf.yaml`

```yaml

jobmanager.rpc.address: hadoop02

```

3 修改`conf/workers`文件

```txt

hadoop03

hadoop04

```

4 分发`flink`到其他节点

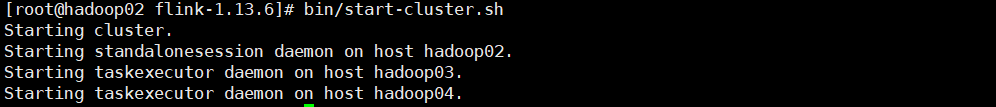

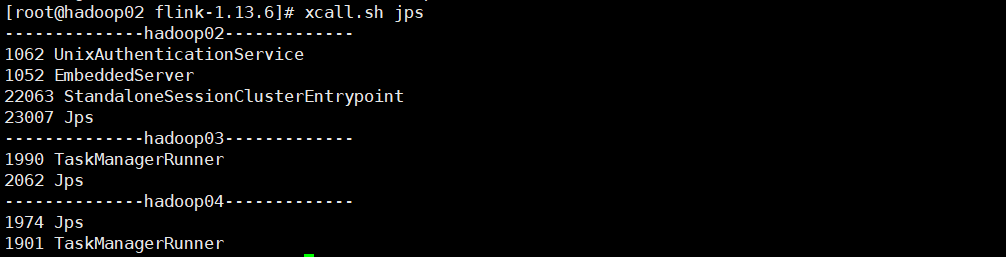

5 启动flink集群

6 查看进程信息:xcall是一个自己写的脚本,实际上是调用jps查看java进程。

- StandaloneSessionClusterEntrypoint:master接入点

- TaskManagerRunner:work进程

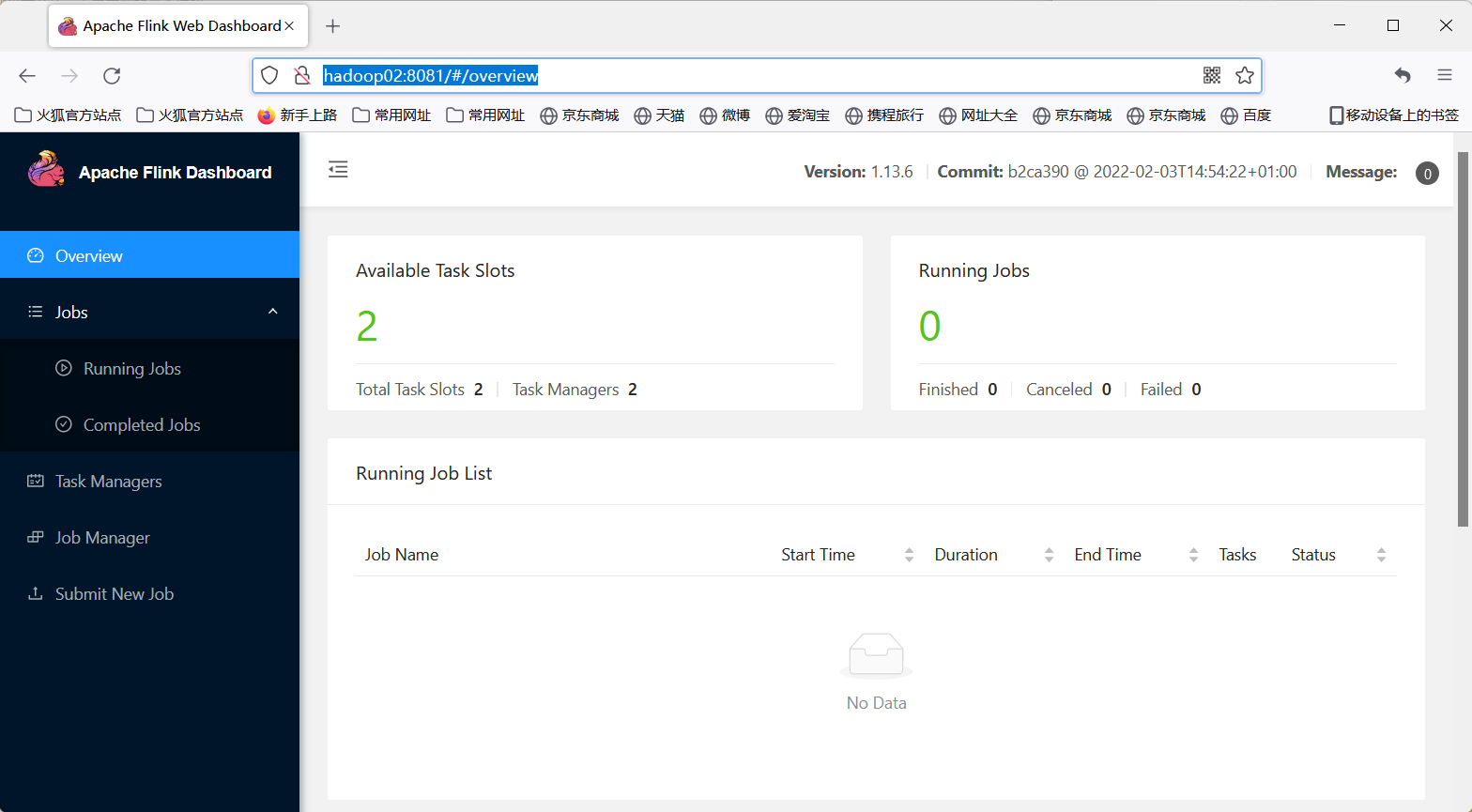

7 访问flink dashboard

url:http://hadoop02:8081/#/overview

#### 2.3 yarn模式

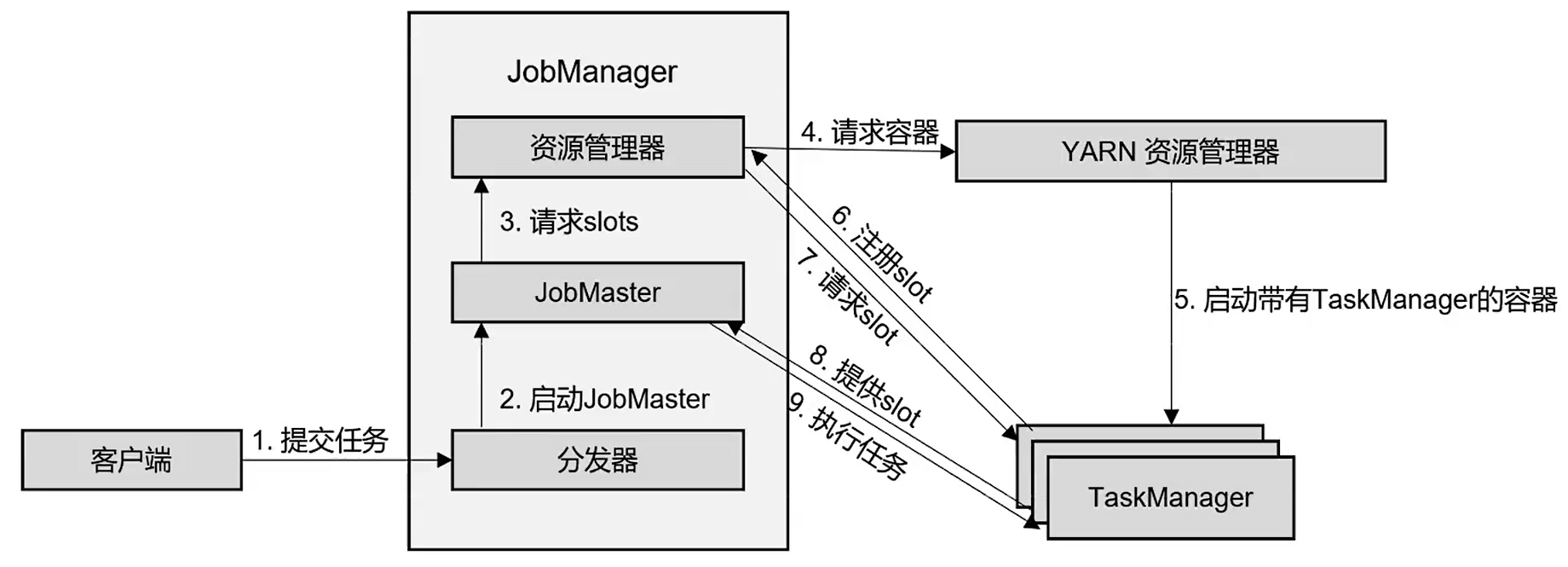

> standlone模式最常见的是会话模式,无法动态的分配资源,一旦集群启动,那么资源就已经确定了。yarn模式下flink会向yarn的NodeManager申请容器,在这些容器上,Flink会部署JobManager和TaskManager的实力,从而启动集群。Flink会根据运行在JobManager上的作业所需要的Slot数量动态分配TaskManager资源。

前置条件:配置好hadoop已经相关的环境变量。

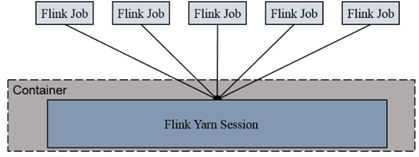

##### 2.3.1 yarn-session模式

在 yarn 中初始化一个 flink 集群,开辟指定的资源,以后提交任务都向这里提交。这个 flink 集群会常驻在 yarn 集群中, 除非手工停止。所有作业共享 Dispatcher 和 ResourceManager;共享资源;适合规模小执行时间短的作业。

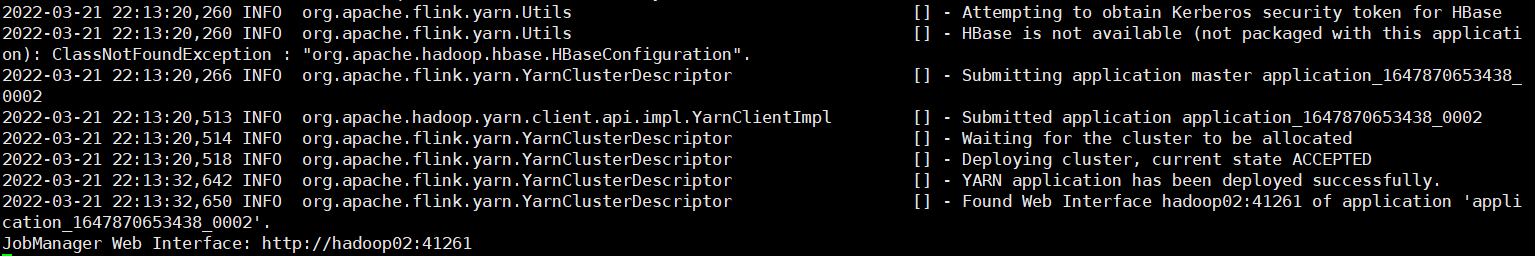

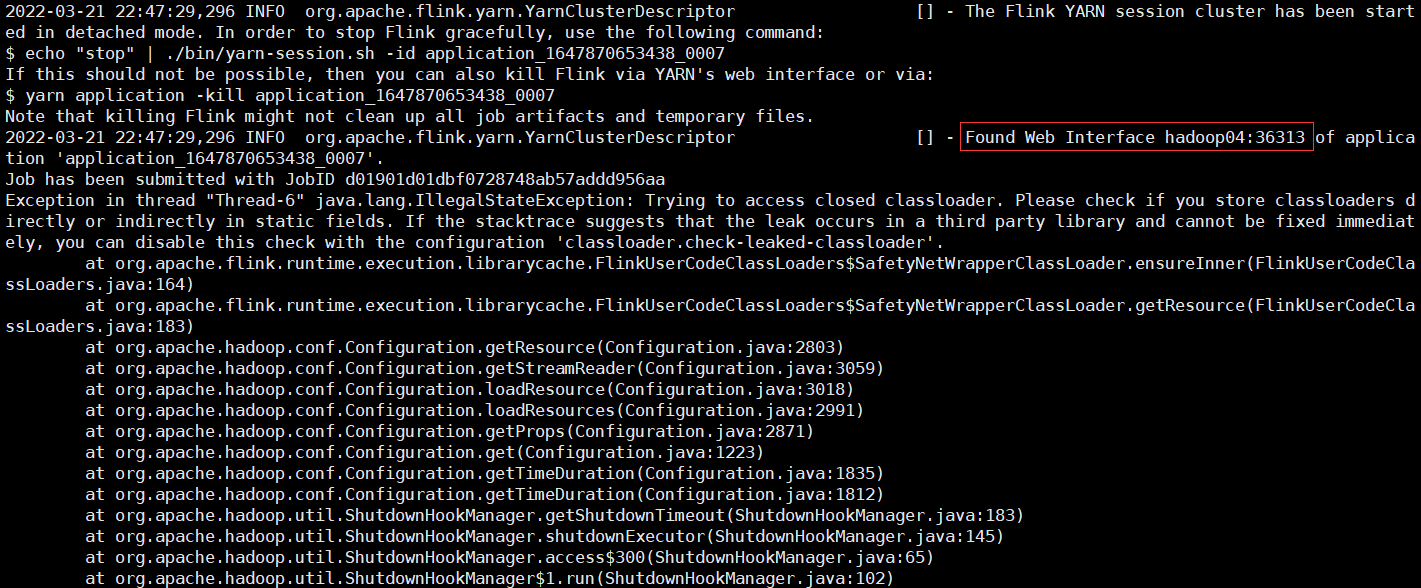

1 启动yarn-session模式:如果有hdfs配置了kerberos认证,那么就需要进行kinit

```shell

./bin/yarn-session.sh -nm test

```

可配参数:

- -d:分离模式,守护进程的方式执行。

- -jm(--jobManagerMemory):配置JobManager所需要的内存,默认单位MB。

- -nm(--name):配置在yarn ui上显示的任务名字。

- -qu(--queue):指定yarn队列名字。

- -tm(--taskManager):配置每个TaskManager所需要的内存。

- 注:1.11版本不再使用-n和-s参数分别指定TaskManager和Slot的数量,yarn会按照需求动态分配TaskManager和Slot的数量,这方面来说,yarn的会话模式也不会把集群资源固定,同样也是动态分配。

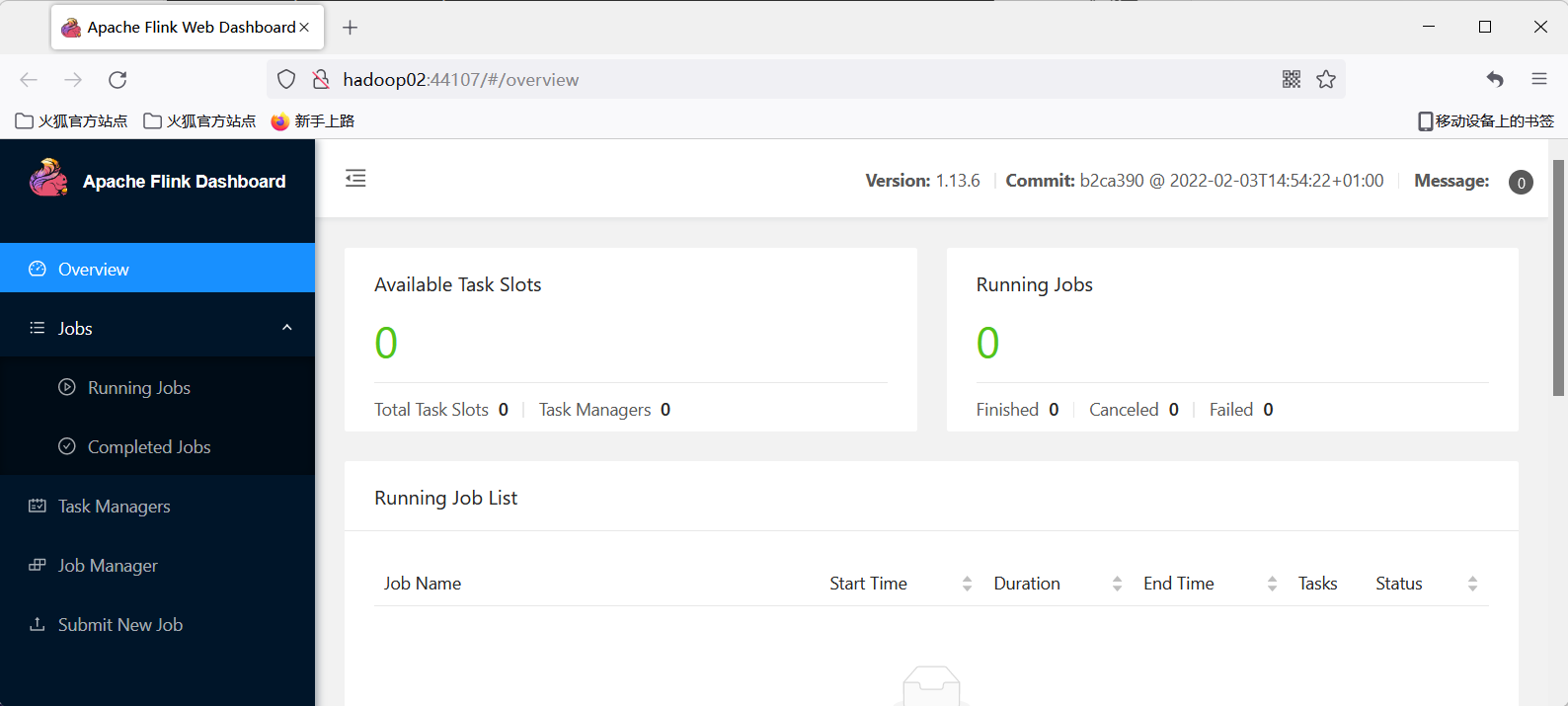

web ui:

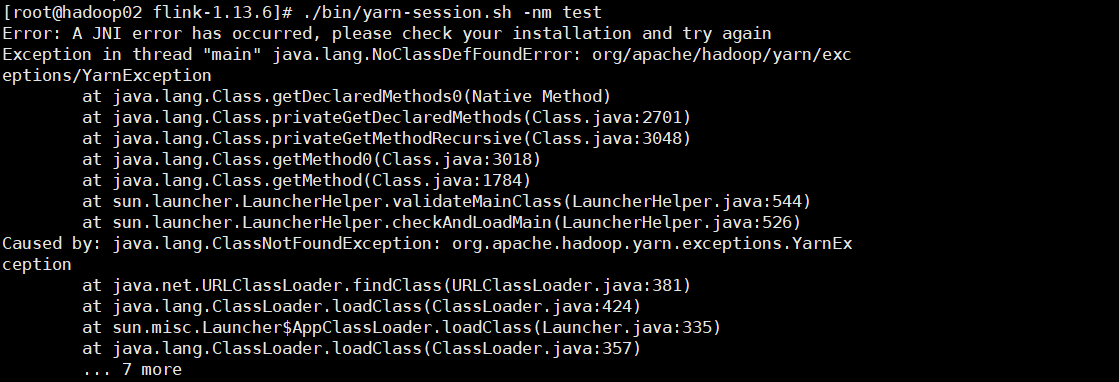

error:如果报如下错误

解决方式:/${flink_home}/lib/下面放置`flink-shaded-hadoop-3-uber-3.1.1.7.1.1.0-565-9.0.jar`

##### 2.3.2 yarn-per-job模式

```shell

bin/flink run -d -t yarn-per-job -c com.it.word_count.StreamUnboundWordCount -p 2 ./project_jars/flink-code1997-1.0-SNAPSHOT.jar --host hadoop02 --port 7777

# 早期写法

./flink run –m yarn-cluster -c com.atguigu.wc.StreamWordCount

FlinkTutorial-1.0-SNAPSHOT-jar-with-dependencies.jar --host lcoalhost –port 7777

```

web-ui:

error:Trying to access closed classloader. Please check if you store classloaders directly or indirectly in static fields

解决:修改`flink-conf.yaml`文件,添加如下参数

```yaml

classloader.check-leaked-classloader: false

```

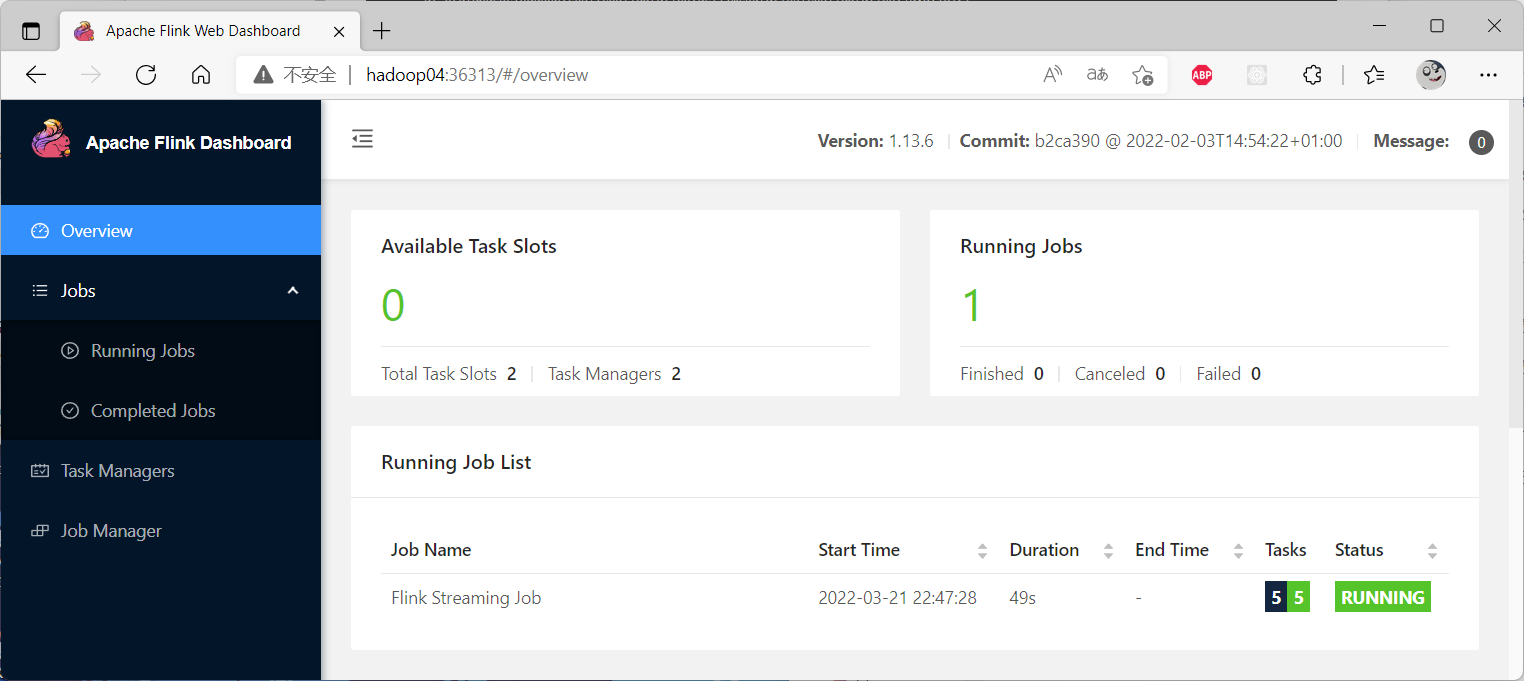

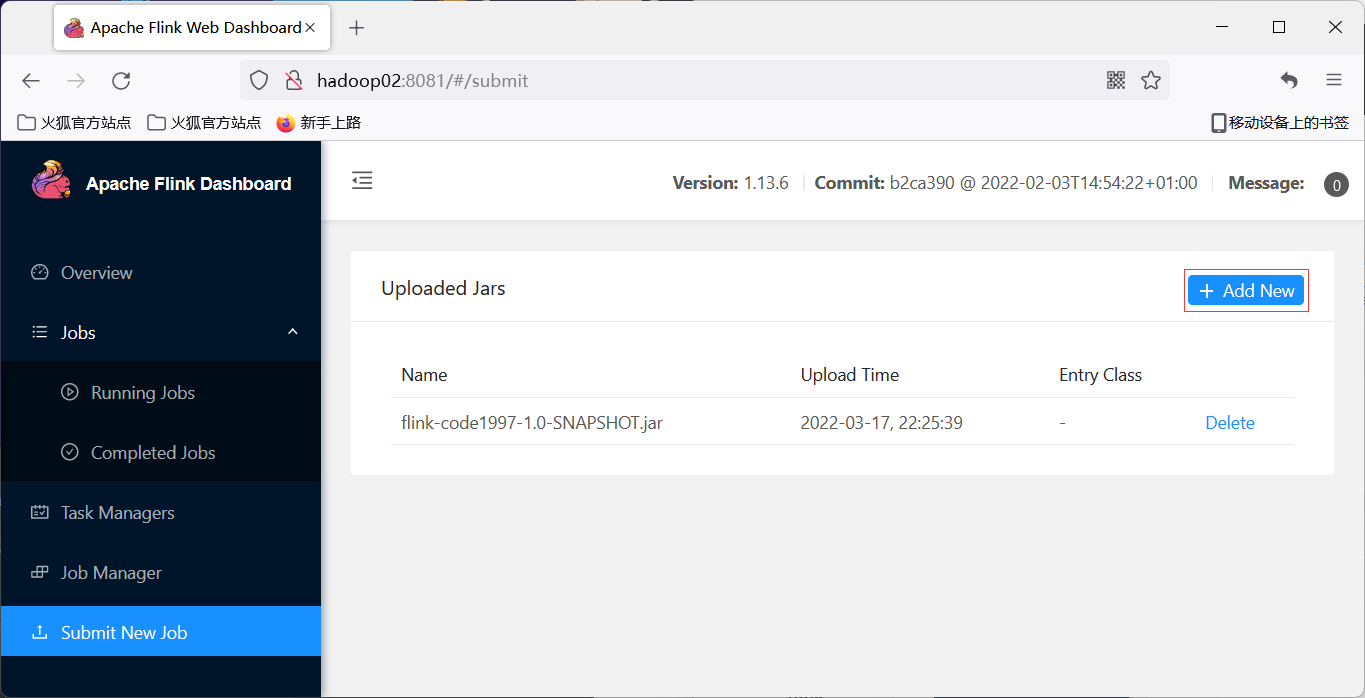

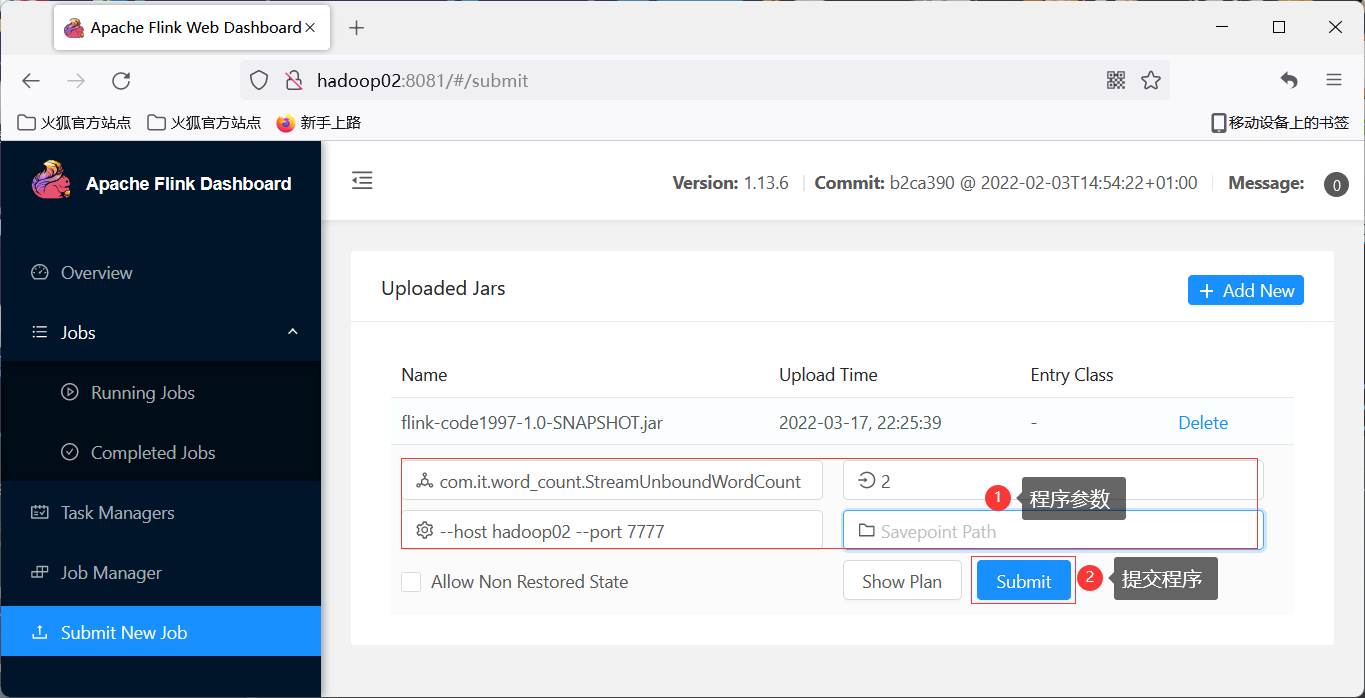

#### 2.4提交项目

##### 2.1 使用flink dashboard

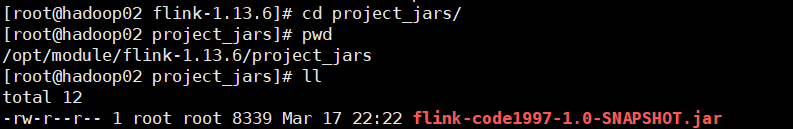

1 上传jar包

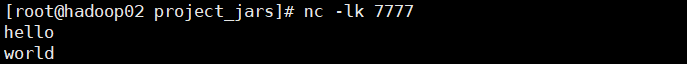

2 启动nc `nc -lk 7777`

3 提交job

4 使用nc向7777端口发送数据

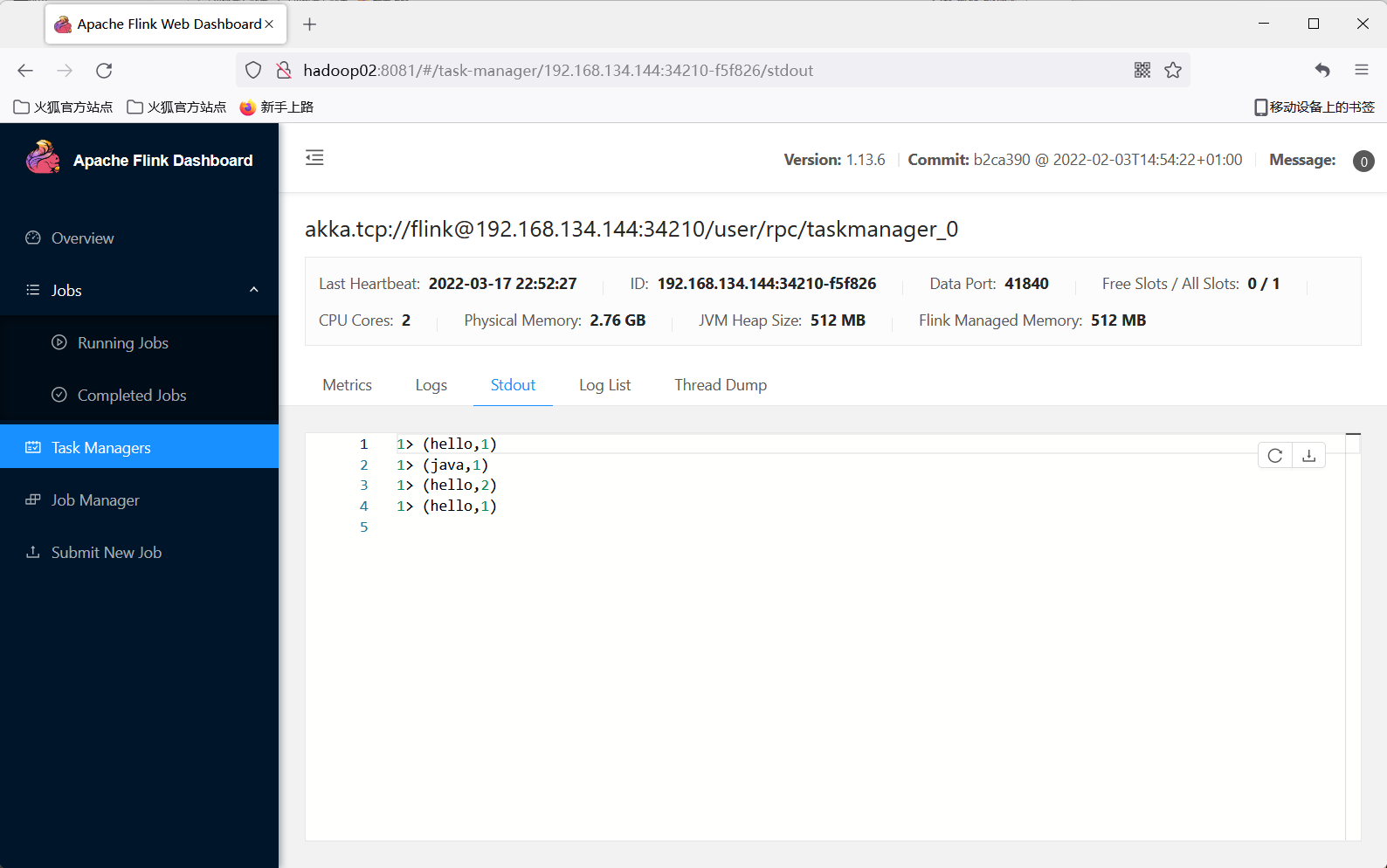

5 查看程序运行输出:因为之前有输出过,所以可能不太一致

##### 2.2 使用命令行

1 上传jar包到集群

2 启动nc监听7777端口

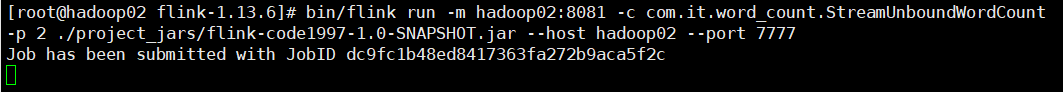

3 提交job

```shell

bin/flink run -m hadoop02:8081 -c com.it.word_count.StreamUnboundWordCount -p 2 ./project_jars/flink-code1997-1.0-SNAPSHOT.jar --host hadoop02 --port 7777

```

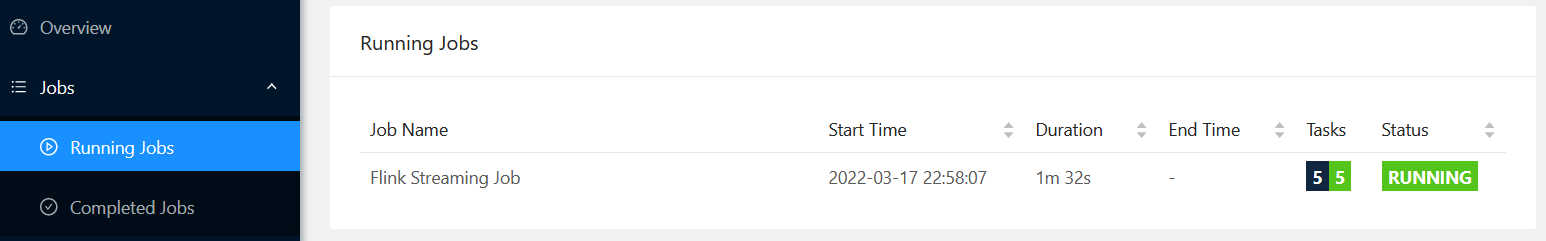

4 web dashboard查看

5 命令行cancel job

```shell

[root@hadoop02 flink-1.13.6]# bin/flink cancel dc9fc1b48ed8417363fa272b9aca5f2c

```

注:如果没有资源了,那么job提交就会失败。

### 3 运行时架构

#### 3.1 flink运行时架构

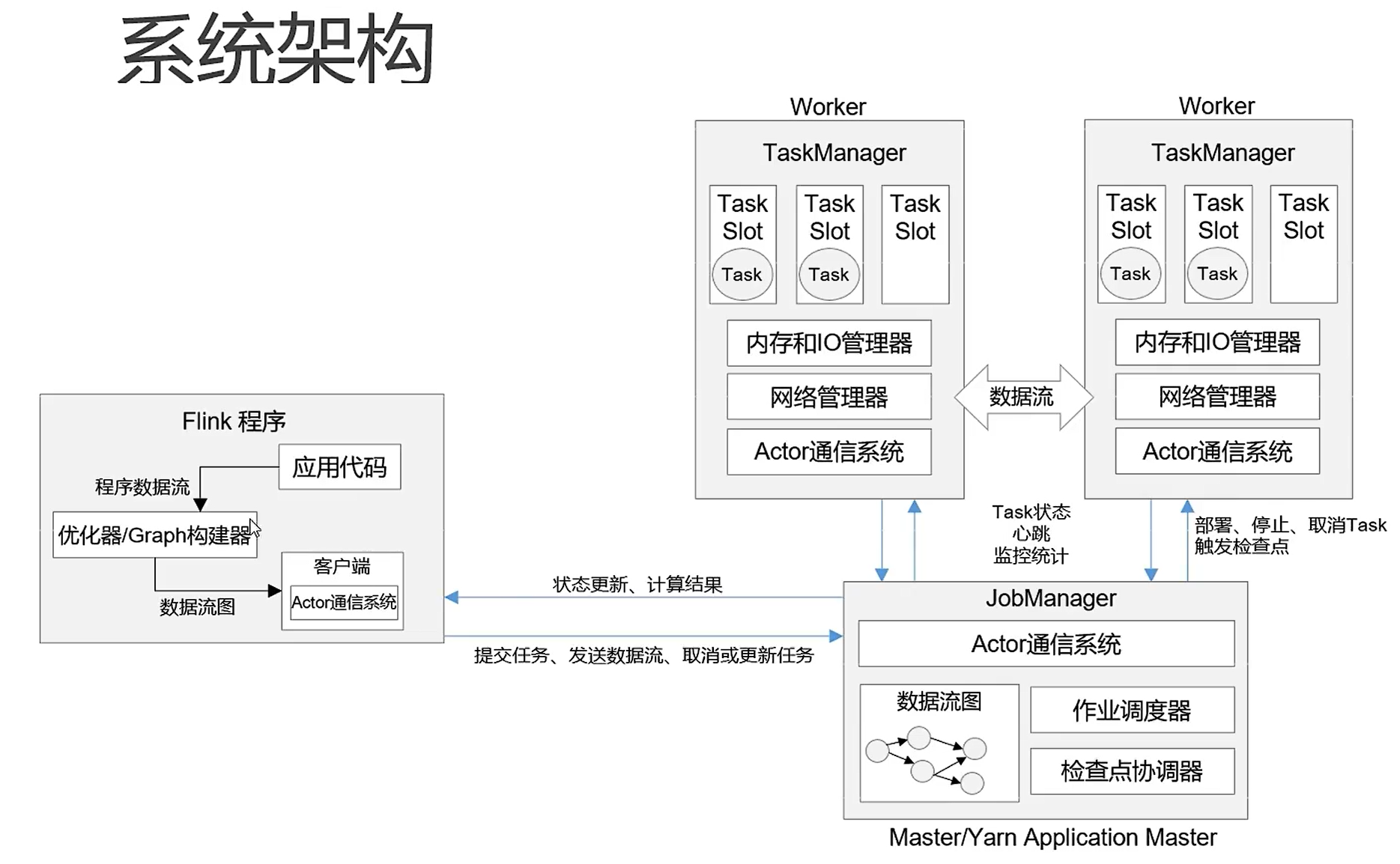

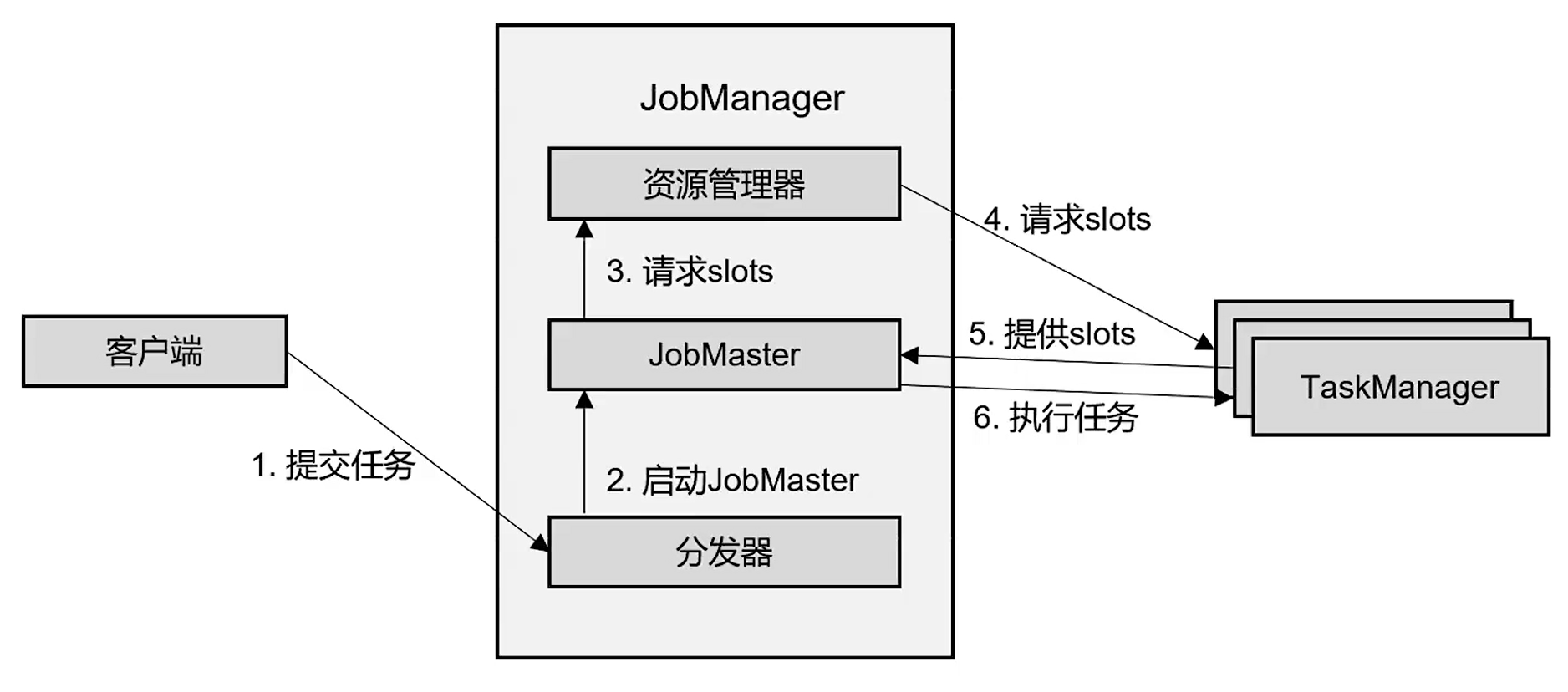

- Job Manager:控制一个应用程序执行的主进程,是Flink集群中任务管理和调度的核心。

- Job Master:是Job Manager中最核心的组件,负责处理单独的作业(Job)。

- 作业提交时,Job Master会先接收到要执行的应用程序,一般是由客户端提交来的,包含:jar包,数据流图,作业图。

- Job Master会将Job Graph转换成物理层面的数据流图,这个图被叫做“执行图”(ExecutionGraph),包含了所有可以并发执行的任务。JobManager 会向资源管理器(ResourceManager)请求执行任务必要的资源,也就是任务管理器(TaskManager)上的插槽( slot)。一旦它获取到了足够的资源,就会将执行图分发到真正运行它们的TaskManager 上。而在运行过程中,JobManager 会负责所有需要中央协调的操作,比如说检查点(checkpoints)的协调。

- 资源管理器(ResourceManager):主要负责管理任务管理器(TaskManager)的插槽(slot),在Flink集群中只有一个。所谓的资源,主要指的是task slots。任务槽就是Flink集群中的资源调配单元,包含了机器用来执行计算的一组CPU和内存资源。每一个任务都需要分配一个slot来执行。

- 分发器(Dispatcher):可以跨作业运行,它为应用提交提供了 REST 接口。当一个应用被提交执行时,分发器就会启动并将应用移交给一个 JobManager。由于是 REST 接口,所以 Dispatcher 可以作为集群的一个 HTTP 接入点,这样就能够不受防火墙阻挡。Dispatcher 也会启动一个Web UI,用来方便地展示和监控作业执行的信息。Dispatcher 在架构中可能并不是必需的,这取决于应用提交运行的方式。

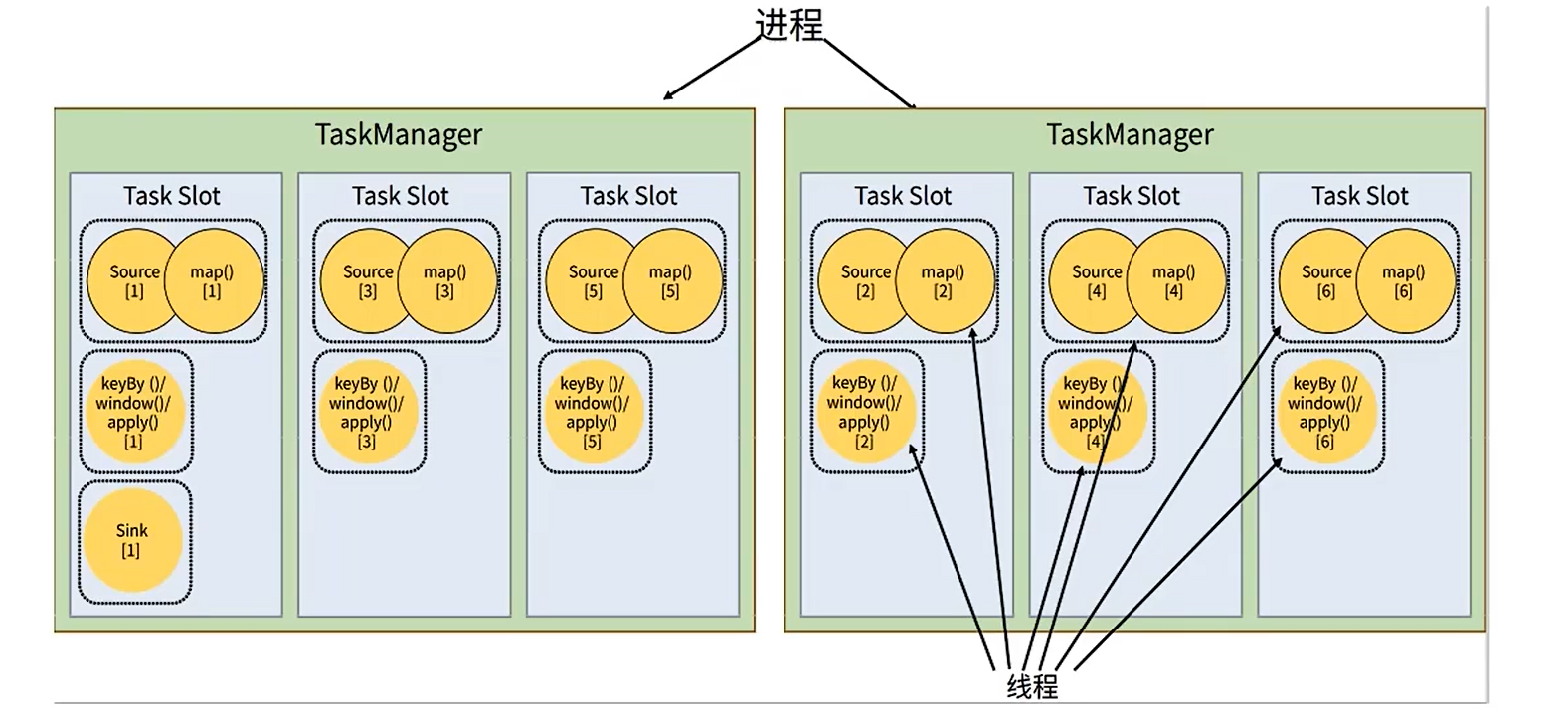

- 任务管理器(TaskManager):Flink 中的工作进程。通常在 Flink 中会有多个 TaskManager 运行,每一个 TaskManager都包含了一定数量的插槽(slots)。插槽的数量限制了 TaskManager 能够执行的任务数量。启动之后, TaskManager 会向`资源管理器`注册它的插槽;收到资源管理器的指令后, TaskManager 就会将一个或者多个插槽提供给 JobManager 调用。JobManager 就可以向插槽分配任务(tasks)来执行了。在执行过程中,一个 TaskManager 可以跟其它运行`同一应用程序`的 TaskManager 交换数据。

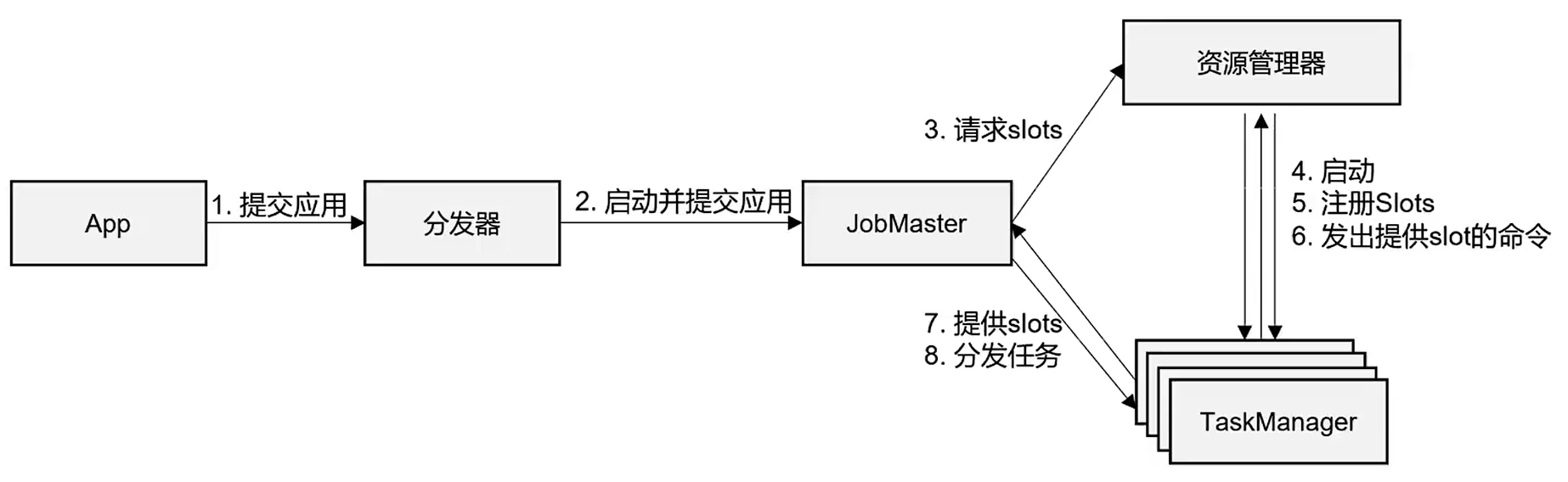

#### 3.2 任务提交流程

1)高层次的图:

2)standlone模式:常用于`会话模式`

3)yarn会话模式:Task Manager是`动态启动`的。

4)yarn-per-job模式:每启动一个job都会启动一个Job Manager

#### 3.3 一些概念

1)数据流

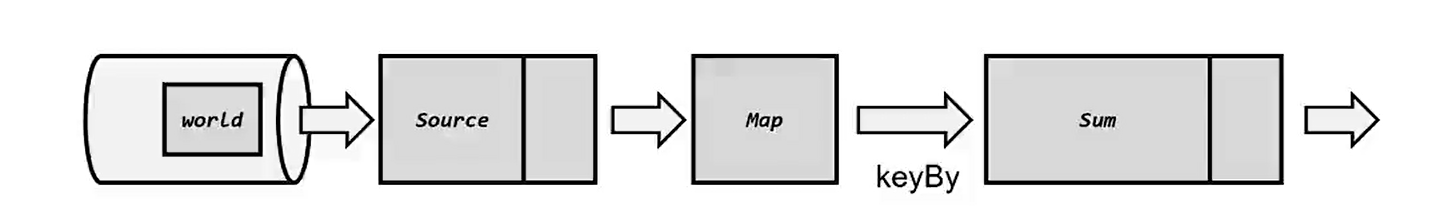

所有的flink程序都可以拆分为三部分:source,Transformation和Sink。

- source:负责读取数据源。

- Transformation:利用各种算子进行处理加工。

- Sink:负责输出。

在运行时,Flink上运行的程序都会被映射成“逻辑数据流”,他包含了三部分:

- 每个dataflow都以一个或者多个source开始;以一个或多个sinks结束。类似于任意的有向无环图。

- 在大部分情况下,程序中的转换运算(Transformation)跟dataflow中的算子(operator)是一一对应的关系。

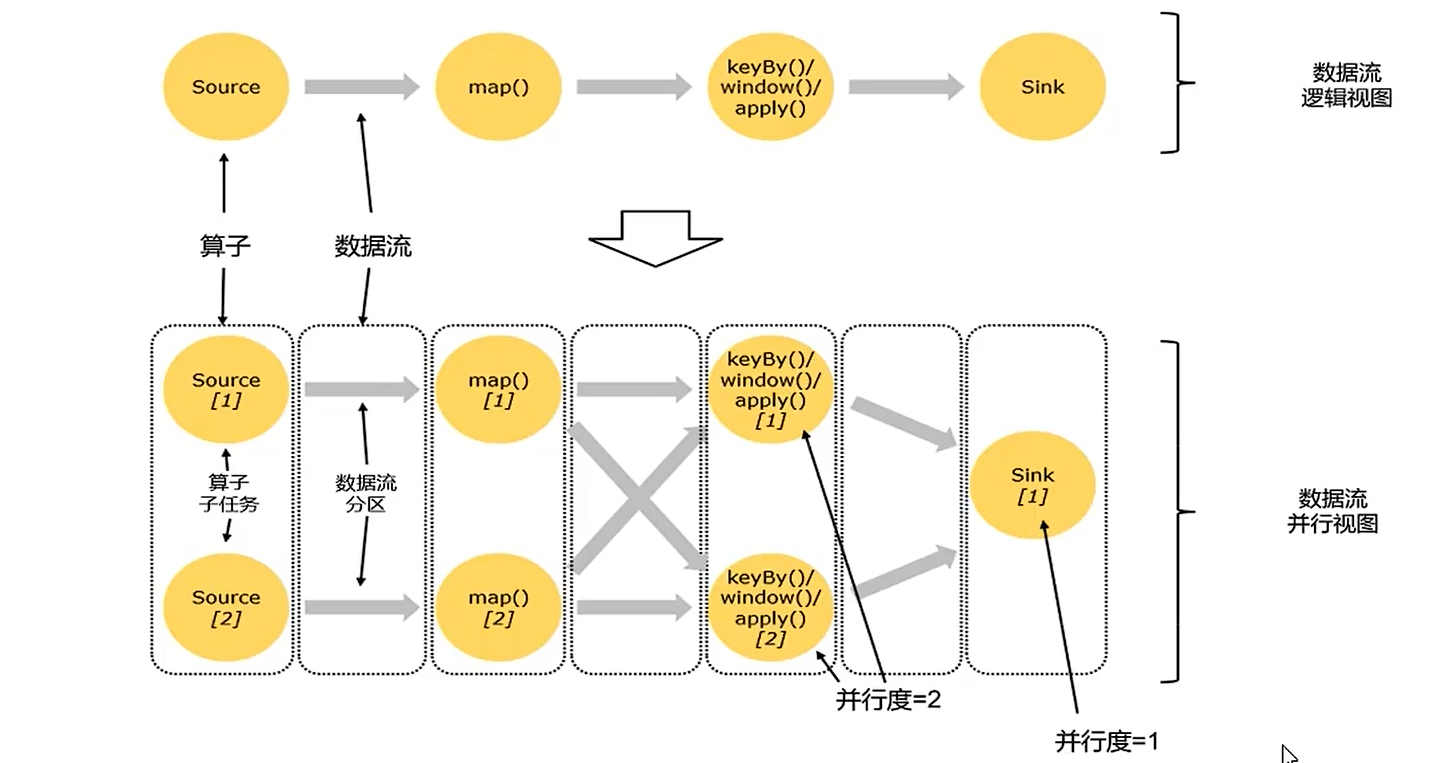

2)并行度:数据并行+任务并行

每一个算子(operator)可以包含一个或多个子任务(operator subtask),这些子任务在不同的线程,不同的物理机或者不同的容器中完全独立的执行。一个特定的算子的子任务的个数称之为其并行度(parallelism)。可以方法来设置某个算子的并行度。

设置并行度:算子>env>命令行的方式>集群环境的设置(flink-conf.yaml)

```java

operator.setParallelism()

executionEnvironment.setParallelism(2);

命令行:-p来设定并行度。

parallelism.default: 1

```

3)数据传输形式

一个程序中,不同的个算子之间可能具有不同的并行度。算子之间传输数据的形式可以是one-to-one(forwarding)的模式,也可以是redistributing的模式,具体是哪一种形式,取决于算子的种类。

- one-to-one:stream维护着分区以及元素的顺序(比如source和map之间),这意味着map算子的子任务看到的元素的个数以及顺序跟source算子的子任务生产的元素的个数,顺序相同。例如:map,filter,flatMap都算One-to-One的对应关系,类似于spark中的`窄依赖`。

- redistributing:分区会发生改变,类似于spark中的shuffle,类似于spark中的`宽依赖`,但是不一定分区会发生变化,例如keyBy。

如果多one-to-one类型的算子链接到一起,我们可以称之为`算子链`。一旦出现充分去或者并行度发生变化就需要断开。

如何手动断开算子链?

- 我们也可以使用`.disableChaining()`来禁用算子链来断开算子前后。

- `.startNewChain()`来断开之前。

- `executionEnvironment.disableOperatorChaining()`全局设置不进行算子链接。

4)执行图

flink中的执行图可以分为四层:StreamGraph->JobGraph->ExecutionGraph->物理执行图

- StreamGraph:根据用户通过StreamApi编写的代码生成的最初的图,表示程序的拓扑结构。

- JobGraph:StreamGraph经过优化之后生成JobGraph,提交给JobManager的数据结构,将多个符合条件的算子链接在一起,形成一个`算子链`。

- ExecutionGraph:JobManager根据JobGraph生成的`并行化版本`,是调度层核心的数据结构。

- 物理执行图:JobManager根据ExecutionGraph对Job进行调度之后,在TaskManager上部署Task后形成的图,并不是一个具体的数据结构。

5)task和task slot:slot槽任务共享

flnik中每一个task manager都是一个JVM进程,他可能会在独立的线程上执行一个或多个子任务。为了控制一个task Manager能接收多少个task,task manager通过task slot来进行控制(一个task manager至少有一个slot)。

默认情况下,flink允许子任务共享slot,结果就是一个slot可以保存作业的整个管道。当我们将资源密集型和非密集型的任务同时放到一个slot中,他们就可以自行分配对资源占用的比例,从而保证最重的活平均的分配给所有的Task Manager,而且可以防止某个Task Manager挂掉之后,导致整个job无法运行,提高了稳定性。

**我们可以使用算子中最大的并行度作为占用slot槽的数量。**

如何禁止slot槽任务共享?默认情况下都属于共享组`default`。

- slotSharingGroup("1"),算子之后的共享都会被改为1。

### 4 DataStream ApI

> Flink程序实际上由四大部分组成:执行环境,source,transformation,sink。

#### 4.1 执行环境

1)getExecutionEnvironment()

会自动进行判断,如果不是jar包中执行,则返回local模式的执行环境;如果是在jar包中,则会返回集群环境的执行环境。

```java

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

```

2)createLocalEnvironment(3)

创建本地执行环境,可以指定并行度。

```java

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.createLocalEnvironment(3);

```

3)创建远程执行环境:可以指定主机名以及JobManager的端口号,jarPath等信息

```java

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.createRemoteEnvironment("hadoop02",8081,3,"jarPath");

```

#### 4.2 source

##### 4.2.1 对接数据源

1)对接socketTextStream

```java

DataStreamSource socketTextStream = executionEnvironment.socketTextStream(hostname, port);

```

2)对接Kafka

添加pom依赖:

```xml

org.apache.flink

flink-connector-kafka_2.12

1.13.6

```

```java

Properties props = new Properties();

props.setProperty(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop02:9092");

props.setProperty(ConsumerConfig.GROUP_ID_CONFIG, "flink-kafka-source");

props.setProperty(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

props.setProperty(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, "org.apache.kafka.common.serialization.StringDeserializer");

props.setProperty(ConsumerConfig.AUTO_OFFSET_RESET_CONFIG, "latest");

DataStreamSource kafkaSource = executionEnvironment.addSource(new FlinkKafkaConsumer<>("flink-clicks", new SimpleStringSchema(), props));

```

3)自定义source:

非并行的:实现SourceFunction

并行的:实现ParallelSourceFunction接口

```java

DataStreamSource sourceStream = executionEnvironment.addSource(new SourceFunction() {

private volatile boolean running = true;

@Override

public void run(SourceContext ctx) throws InterruptedException {

//随机生成数据

Random random = new Random();

//定义字段的选取的数据集

String[] users = {"tom", "ailis", "kangkang"};

String[] urls = {"./index", "./home", "./fav", "./order?id=10"};

//执行数据的范围

while (running) {

String user = users[random.nextInt(users.length)];

String url = urls[random.nextInt(urls.length)];

ctx.collect(new Event(user, url, System.currentTimeMillis()));

Thread.sleep(100);

}

}

@Override

public void cancel() {

//update flag to control job

running = false;

}

});

```

##### 4.2.2 支持的数据类型

> Flink作为分布式数据处理框架,要分布式的处理这些数据,那么就不可避免的要面对数据的网络传输,状态落盘,故障恢复等问题,这就需要对数据进行序列化和反序列化。Flink使用TypeInfomation作为类型的基石。

1)基本数据类型

可以在BasicTypeInfo中找到基本数据类型以及其包装类,加上Void,String,Date,BigDecimal,BigInteger

2)数组类型

包含基本数据类型数组(primitive Array)和对象数组(object Array)

3)复杂数据类型

- Java元组类型:这是Flink内置的元组类型,是Java API的一部分,从Tuple0-25

- scala的样例类以及元组类型:不支持空字段。

- 行类型:可以认为是具有任意个字段的元组,并支持空字段。

- POJO:Flink自定义的类似于Java bean模式的类。

- 类是public和没有非静态的内部类。

- 类存在公共的无参构造器。

- 类中的所有字段是public且非final;或者有一个public的getter和setter方法。

- 辅助类型:option,Either,list,map等

- 泛型类型(Generic):Flink支持所有的java类和scala类,如果没有按照POJO类型的要求来定义,会被当作Flink的泛型类处理,无法获取其内部属性,且使用kryo来进行序列化。

4)Type Hints

Flink还具有一个类型提取系统,可以分析函数的输入和返回类型,自动获取类型信息,从而获取对应的序列化和反序列化器。但是Java中存在泛型擦除,在某些特殊的情况下(例如lambda表达式),自动提取的信息不够精细,这样就需要我们显示的提供类型信息。为了解决这类问题,Java API提供了专门的`Type Hints`。例如我们之前的word count。

使用之前:

```java

SingleOutputStreamOperator> tuple2Words = streamSource.flatMap((FlatMapFunction>) (s, collector) -> {

String[] words = s.split(" ");

for (String word : words) {

collector.collect(Tuple2.of(word, 1L));

}

}).returns(Types.TUPLE(Types.STRING, Types.LONG));

```

使用之后:

```java

.returns(new TypeHint>(){});

```

#### 4.3 转换算子

> 数据源读入数据之后,我们可以使用各种转换算子,将一个或多个DataStream转换为新的DataStream,Flink程序的核心就是所有的转换操作,他们决定了处理的业务逻辑。

##### 4.3.1 基本转换算子

> 本小节涉及到的转换算子

1. map

```java

SingleOutputStreamOperator users = eventSource.map(event -> event.user);

```

2. filter

```java

SingleOutputStreamOperator vips = eventSource.filter(event -> "jerry".equals(event.user));

```

3. FlatMap

```java

SingleOutputStreamOperator flatMapedSource = eventSource.flatMap((FlatMapFunction) (value, out) -> {

String[] data = value.split(" ");

for (String d : data) {

out.collect(d);

}

}).returns(new TypeHint() {

});

```

##### 4.3.2 聚合算子

> 计算的结果不仅仅依赖当前数据,还和之前的数据有关,相当于将所有的数据聚合到一起进行汇总合并,这就是所谓的"聚合"操作。

前置操作:keyBy(按键分区)

对于flink而言,DataStream没有直接进行聚合的API,因为我们对海量数据进行聚合肯定要进行分区并行处理,才可以提高效率,因此在FLink中,要做聚合,需要先进行分区,这个操作就是通过keyBy来完成的。

实现:通过计算key的hash值,然后对分区数进行取模运算来是实现的,所以key如果是POJO的话,必须重写hashCode方法。

1. max以及maxBy

```java

//max:只更改我们传入的列为最大值,其他列是该key是第一次出现的值:Event{user='tom', url='./index', timestamp=1970-01-01 08:00:40.0}

eventSource.keyBy((KeySelector) value -> value.user).max("timestamp").print("max:");

//maxBy:按照传入列,找到了列最大的那条记录:Event{user='tom', url='./order?id=10', timestamp=1970-01-01 08:00:40.0}

eventSource.keyBy((KeySelector) value -> value.user).maxBy("timestamp").print("maxBy:");

```

2.使用reduce来实现聚合操作

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

//统计每个用户的访问频次

SingleOutputStreamOperator> userF = eventSource.map(event -> Tuple2.of(event.user, 1L)).returns(Types.TUPLE(Types.STRING,Types.LONG))

.keyBy(data -> data.f0)

.reduce((ReduceFunction>) (value1, value2) -> Tuple2.of(value1.f0, value1.f1 + value2.f1));

//选取当前最活跃的用户:我们想使用reduce进行操作,那么就必须使用keyBy,就必须要指定一个key,我们可以写死一个key来将所有的数据分到同一个分区中去,

// 这种方式要谨慎使用。

SingleOutputStreamOperator> maxClickUser = userF.keyBy(data -> "key").maxBy(1);

maxClickUser.print();

//reduce:可以实现一些自定义的聚合逻辑.

SingleOutputStreamOperator> maxClickUser2 = userF.keyBy(data -> "key")

.reduce((ReduceFunction>) (value1, value2) -> value1.f1>value2.f1?value1:value2);

maxClickUser2.print();

executionEnvironment.execute();

}

```

##### 4.3.3 自定义函数(UDF)

“富函数类”是DataStream API提供的一个函数类的接口,所有的Flink函数都有其Rich版本,一般以抽象类的形式出现。例如:RichMapFunction, RichFilterFunction等。相对于常规的函数类提供更多,更丰富的功能,可以获取运行时环境的上下文,并且拥有一些生命周期的方法。

- 生命周期方法

- Open:会开启一个算子的生命周期,适合做一些文件IO/数据库链接的创建,配置文件读取等一次性工作。

- Close:是生命周期中最后一个调用的方法,类似于解构方法,一般用来做清理的工作。

```java

public class Operator_RichMapFunction {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

eventSource.map(new MyRichFunction()).setParallelism(2).print();

executionEnvironment.execute();

}

public static class MyRichFunction extends RichMapFunction{

/**

* 当前任务实例被创建的时候调用一次

*/

@Override

public void open(Configuration parameters) throws Exception {

super.open(parameters);

System.out.println("open 生命周期方法被调用 " + getRuntimeContext().getIndexOfThisSubtask());

}

/**

* 当前任务实例被销毁的时候调用一次

*/

@Override

public void close() throws Exception {

super.close();

System.out.println("close 生命周期方法被调用 " + getRuntimeContext().getIndexOfThisSubtask());

}

@Override

public Integer map(Event value) throws Exception {

return value.user.length();

}

}

}

```

##### 4.3.4 物理分区--数据倾斜情况下

> 分区操作就是要将数据进行重新分布,传递到不同的流分区中进行下一步。keyBy是按照hash进行分区,是否分的均匀或者分到了哪里都是无法控制的,因此我们也称之为逻辑上的分区。Flink上下游任务之间的分区数不同的时候会自动的进行负载均衡。默认情况下使用rebalance的方式。

- shuffle:随机分区,尽量将数据分配的均匀

- rebalance:轮询分区

- rescale:重新缩放分区,将数据分成几个小组,然后小组内进行rebalance。如果存在Job执行存在多个TaskManager,多个Slot。使用Rescale可能会减少数据的网络传输,提高性能。

- broadcast:广播,主要用于将小数据集缓存到各个分区中,以分区为单位缓存一份数据据。

- global:全局分区,将全部的分区收集到一个分区,即便是后面的算子设置了并行度也没有用。

- partitionCustom:自定义重分区,传入一个分区器以及keySelector。

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

//1.shuffle:随机分区,尽量将数据分配的均匀

//eventSource.shuffle().print().setParallelism(3);

//2.rebalance:轮询分区

//eventSource.rebalance().print().setParallelism(3);

//3.rescale:重新缩放分区,将数据分成几个小组,然后小组内进行rebalance。

DataStreamSource parallelSource = executionEnvironment.addSource(new RichParallelSourceFunction() {

@Override

public void run(SourceContext ctx) throws Exception {

for (int i = 1; i <= 8; i++) {

//将奇/偶分别发我往不同的task子任务

if (i % 2 == getRuntimeContext().getIndexOfThisSubtask()) {

ctx.collect(i);

}

}

}

@Override

public void cancel() {

}

});

parallelSource.setParallelism(2).rescale().print().setParallelism(4);

//parallelSource.setParallelism(2).global().print();

//最后打印出的并行度也是2

executionEnvironment.fromElements(1,2,3,4,5,6,7,8).partitionCustom(new Partitioner() {

@Override

public int partition(Integer key, int numPartitions) {

return key%2;

}

}, new KeySelector() {

@Override

public Integer getKey(Integer value) throws Exception {

return value;

}

}).print().setParallelism(4);

executionEnvironment.execute();

}

```

#### 4.4 Sink--输出算子

> Flink作为数据处理框架,最终还是要把计算处理的结果写入外部存储,为外部应用提供支持,Sink算子主要就是为了输出数据到外部系统。

##### 4.4.1 目前支持的连接器

- [Apache Kafka](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/kafka/) (source/sink)

- [Apache Cassandra](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/cassandra/) (sink)

- [Amazon Kinesis Streams](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/kinesis/) (source/sink)

- [Elasticsearch](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/elasticsearch/) (sink)

- [FileSystem](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/filesystem/) (sink)

- [RabbitMQ](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/rabbitmq/) (source/sink)

- [Google PubSub](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/pubsub/) (source/sink)

- [Hybrid Source](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/hybridsource/) (source)

- [Apache NiFi](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/nifi/) (source/sink)

- [Apache Pulsar](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/pulsar/) (source)

- [Twitter Streaming API](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/twitter/) (source)

- [JDBC](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/datastream/jdbc/) (sink)

- Apache Bahir项目附加的连接器:

- [Apache ActiveMQ](https://bahir.apache.org/docs/flink/current/flink-streaming-activemq/) (source/sink)

- [Apache Flume](https://bahir.apache.org/docs/flink/current/flink-streaming-flume/) (sink)

- [Redis](https://bahir.apache.org/docs/flink/current/flink-streaming-redis/) (sink)

- [Akka](https://bahir.apache.org/docs/flink/current/flink-streaming-akka/) (sink)

- [Netty](https://bahir.apache.org/docs/flink/current/flink-streaming-netty/) (source)

##### 4.4.2 常见的sink方式

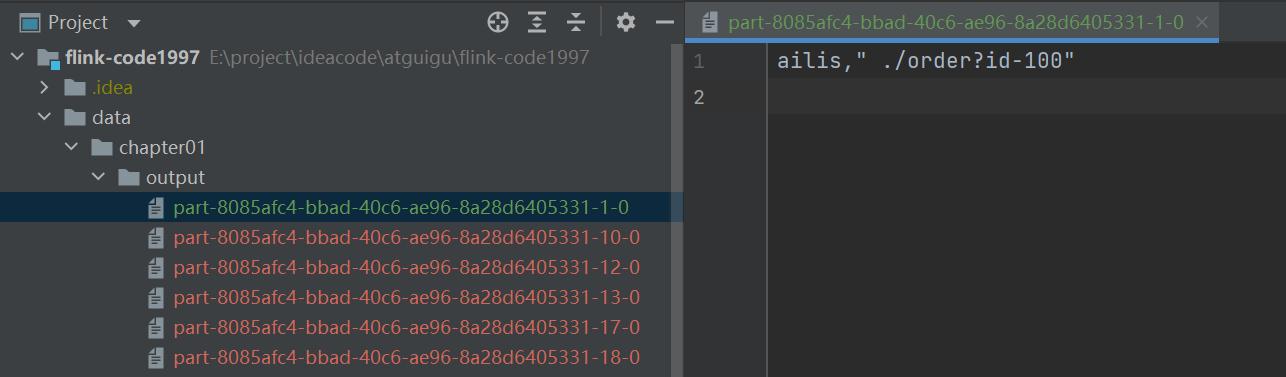

1.FileSink

- writeAsText or writeAsCSV: 不支持同时写一份文件,因此最后写出的时候需要将并行设置为1.而且对于数据一致性无法保证。

- StreamingFileSink: implements CheckpointedFunction, CheckpointListener,因此可以保证数据一致性 。将数据先写入到不同的bucket,将bucket中的数据分割成一个个大小有限的分区文件。

- BulkFormatBuilder:对接hadoop的parquet格式的列数存储。

- RowFormatBuilder:对接行编码的方式

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

//eventSource.writeAsText("data/chapter01/sink/file_sink");

StreamingFileSink fileSink = StreamingFileSink.forRowFormat(new Path("data/chapter01/sink/file_sink"), new SimpleStringEncoder<>("UTF-8"))

.withRollingPolicy(DefaultRollingPolicy.builder()

//设置文件的最大大小

.withMaxPartSize(1024 * 1024 * 1024)

//设置一个文件的最长写入的最长时间

.withRolloverInterval(TimeUnit.MINUTES.toMillis(15))

//设置如果多长时间不活跃就重新开一个文件

.withInactivityInterval(TimeUnit.MINUTES.toMillis(5)).build())

.build();

eventSource.map(Event::toString).addSink(fileSink);

executionEnvironment.execute();

}

```

2.kafkaSink

```java

/**

* 从kafka中读取数据-->进行数据转换-->写回到kafka中。

*

* @author code1997

*/

public class KafkaSink {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

Properties properties = new Properties();

properties.setProperty(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop02:9092");

DataStreamSource kafkaSource = executionEnvironment.addSource(new FlinkKafkaConsumer("flink-clicks", new SimpleStringSchema(), properties));

//flink进行转换处理

SingleOutputStreamOperator events = kafkaSource.map(new MapFunction() {

@Override

public String map(String value) throws Exception {

String[] fields = value.split(",");

return new Event(fields[0].trim(), fields[1].trim(), Long.valueOf(fields[2].trim())).toString();

}

});

//写回到kafka中去

Properties produceConfig = new Properties();

produceConfig.setProperty(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "hadoop02:9092");

events.addSink(new FlinkKafkaProducer<>("flink-events", new SimpleStringSchema(), produceConfig));

executionEnvironment.execute();

}

}

```

3.RedisSink--Bahir

pom

```xml

org.apache.bahir

flink-connector-redis_2.11

1.0

```

code:

```java

/**

* 将数据写入到redis中

*

* @author code1997

*/

public class RedisSinkDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

FlinkJedisPoolConfig redisConfig = new FlinkJedisPoolConfig.Builder().setHost("docker_server").build();

eventSource.addSink(new RedisSink<>(redisConfig, new RedisMapper() {

/**

* 通过什么方式来操作redis

*/

@Override

public RedisCommandDescription getCommandDescription() {

//用户的点击事件表

return new RedisCommandDescription(RedisCommand.HSET, "users");

}

@Override

public String getKeyFromData(Event event) {

return event.user;

}

@Override

public String getValueFromData(Event event) {

return event.toString();

}

}));

executionEnvironment.execute();

}

}

```

4. ES

pom:

```xml

org.apache.flink

flink-connector-elasticsearch7_${scala.binary.version}

${flink.version}

```

code:

```java

/**

* 存储数据到es然后使用kibana进行查询.

* GET _search

* {

* "query": {

* "match": {

* "_index": "clicks"

* }

* }

*

* @author code1997

*/

public class EsSinkDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

ArrayList hosts = new ArrayList<>();

hosts.add(new HttpHost("docker_server", 9200));

eventSource.addSink(new ElasticsearchSink.Builder<>(hosts, new ElasticsearchSinkFunction() {

@Override

public void process(Event event, RuntimeContext runtimeContext, RequestIndexer requestIndexer) {

HashMap map = new HashMap<>();

map.put(event.user, event.toString());

IndexRequest indexRequest = Requests.indexRequest().index("clicks").source(map);

requestIndexer.add(indexRequest);

}

}).build());

executionEnvironment.execute();

}

}

```

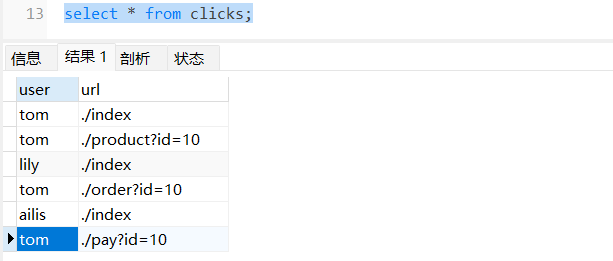

5. mysql

pom:

```xml

org.apache.flink

flink-connector-jdbc_${scala.binary.version}

${flink.version}

mysql

mysql-connector-java

8.0.20

```

code:

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

String sql = "insert into flink_demo.clicks values(?,?)";

eventSource.addSink(JdbcSink.sink(sql, new JdbcStatementBuilder() {

@Override

public void accept(PreparedStatement preparedStatement, Event event) throws SQLException {

preparedStatement.setString(1, event.user);

preparedStatement.setString(2, event.url);

}

}, new JdbcConnectionOptions.JdbcConnectionOptionsBuilder()

.withUrl("jdbc:mysql://docker_server:3306/flink_demo?useSSL=true&useUnicode=true&characterEncoding=utf-8&serverTimezone=Asia/Shanghai")

.withDriverName("com.mysql.cj.jdbc.Driver")

.withUsername("root")

.withPassword("19971001")

.build()));

executionEnvironment.execute();

}

```

result:

6. 自定义Sink输出

> 实际就是自定义类实现SinkFunction或者RichSinkFunction接口,重写invoke方法。但是我们可能无法实现数据一致性的保障,因此在不需要保证数据一致性的情况下,我们可以自定义实现sourceFunction。

### 5 window

#### 5.1 时间

时间:一般分为事件时间和处理时间两种。事件流在分布式系统中因为各种原因可能会出现乱序,因此我们就需要考量我们需要哪一种时间。对于事件事件,Flink使用另外的标志来表示事件时间进展,在Flink中把它叫做事件时间的水位线(water marks)。

Flink:早期的版本默认的时间语义是处理时间,在1.12版本开始,Flink将事件事件作为默认的时间语义。

##### 5.1.1 水位线

在窗口的处理过程中,我们可以基于数据的时间戳来进行时间的推进。在Flink中,用来衡量事件时间(Event Time)进展的标记,就被称作水位线(WaterMark)。

1.什么时候产生水位线

1)有序流

1. 如果数据比较稀疏:那么我们对每条数据提取时间戳是没有问题的。

2. 如果数据比较多:我们对每一条数据都提取数据,那么就会加大处理的压力,那么我们可以周期性的提取一些数据,使用他们的时间戳来推动水位线的前进。

2)无序流

1. 如果数据比较稀疏:那么我们对每条数据提取时间戳+时间比对。

2. 如果数据比较多:周期性处理+时间比对。

如果使用以上两种方式来统计数据,结果可能存在偏差,我们无法处理迟到的数据,为了让窗口可以正确的收集到迟到的数据,我们可以等上一段时间(经验上考虑等多久)。水位线代表当前的事件时间时钟,而且可以在数据的时间戳基础上加一点延迟来保证不丢数据。

2.水位线的特点

- 水位线是插入到数据流中的一个标记,可以认为是一个特殊的数据。

- 水位线的主要内容是一个时间戳,用来表示当前事件时间的进展。

- Watermark 是用于处理乱序事件的, 而正确的处理乱序事件, 通常用

Watermark 机制结合 window 来实现。

Watermark 可以理解成一个延迟触发机制,我们可以设置 Watermark 的延时时长 t,每次系统会校验已经到达的数据中最大的 maxEventTime,然后认定 eventTime小于 maxEventTime - t 的所有数据都已经到达,如果有窗口的停止时间等于maxEventTime – t,那么这个窗口被触发执行。

3.水位线的生成原则

水位线是用来保证窗口处理结果的正确性,如果不能正确处理所有乱序数据,可以尝试调大延迟时间。

- 如果我们想要数据更加准确,那么我们可以将水位线的延迟设置的更高一点,等待的时间越长,越不容易漏掉数据,不过延迟就会增大。

- 如果我们希望处理的快,实时性强,那么我们可以将水位线延迟设置的更低一点,这样的情况下,可能会导致窗口漏数据,导致窗口计算结果不精确。

4.代码实现

WatermarkGenerator(指定watermark生成策略:事件触发或者断点式)+ TimestampAssigner(如何提取时间戳)。

- 有序数据:forMonotonousTimestamps

```java

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment)

//调用flink内置的针对于有序流的watermark策略

.assignTimestampsAndWatermarks(WatermarkStrategy.forMonotonousTimestamps().withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

```

- 无序数据:forBoundedOutOfOrderness

```java

SingleOutputStreamOperator eventSource2 = SourceUtils.getEventSource(executionEnvironment)

//调用flink内置的针对于有序流的watermark策略

.assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ofSeconds(2)).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

```

水位线是前闭合后开放的,源码中实现:最大事件-延迟时间-1ms。

```java

/**

* A WatermarkGenerator for situations where records are out of order, but you can place an upper

* bound on how far the events are out of order. An out-of-order bound B means that once an event

* with timestamp T was encountered, no events older than {@code T - B} will follow any more.

*

* The watermarks are generated periodically. The delay introduced by this watermark strategy is

* the periodic interval length, plus the out-of-orderness bound.

*/

@Public

public class BoundedOutOfOrdernessWatermarks implements WatermarkGenerator {

/** The maximum timestamp encountered so far. */

private long maxTimestamp;

/** The maximum out-of-orderness that this watermark generator assumes. */

private final long outOfOrdernessMillis;

/**

* Creates a new watermark generator with the given out-of-orderness bound.

*

* @param maxOutOfOrderness The bound for the out-of-orderness of the event timestamps.

*/

public BoundedOutOfOrdernessWatermarks(Duration maxOutOfOrderness) {

checkNotNull(maxOutOfOrderness, "maxOutOfOrderness");

checkArgument(!maxOutOfOrderness.isNegative(), "maxOutOfOrderness cannot be negative");

this.outOfOrdernessMillis = maxOutOfOrderness.toMillis();

// start so that our lowest watermark would be Long.MIN_VALUE.

this.maxTimestamp = Long.MIN_VALUE + outOfOrdernessMillis + 1;

}

// ------------------------------------------------------------------------

@Override

public void onEvent(T event, long eventTimestamp, WatermarkOutput output) {

maxTimestamp = Math.max(maxTimestamp, eventTimestamp);

}

@Override

public void onPeriodicEmit(WatermarkOutput output) {

output.emitWatermark(new Watermark(maxTimestamp - outOfOrdernessMillis - 1));

}

}

```

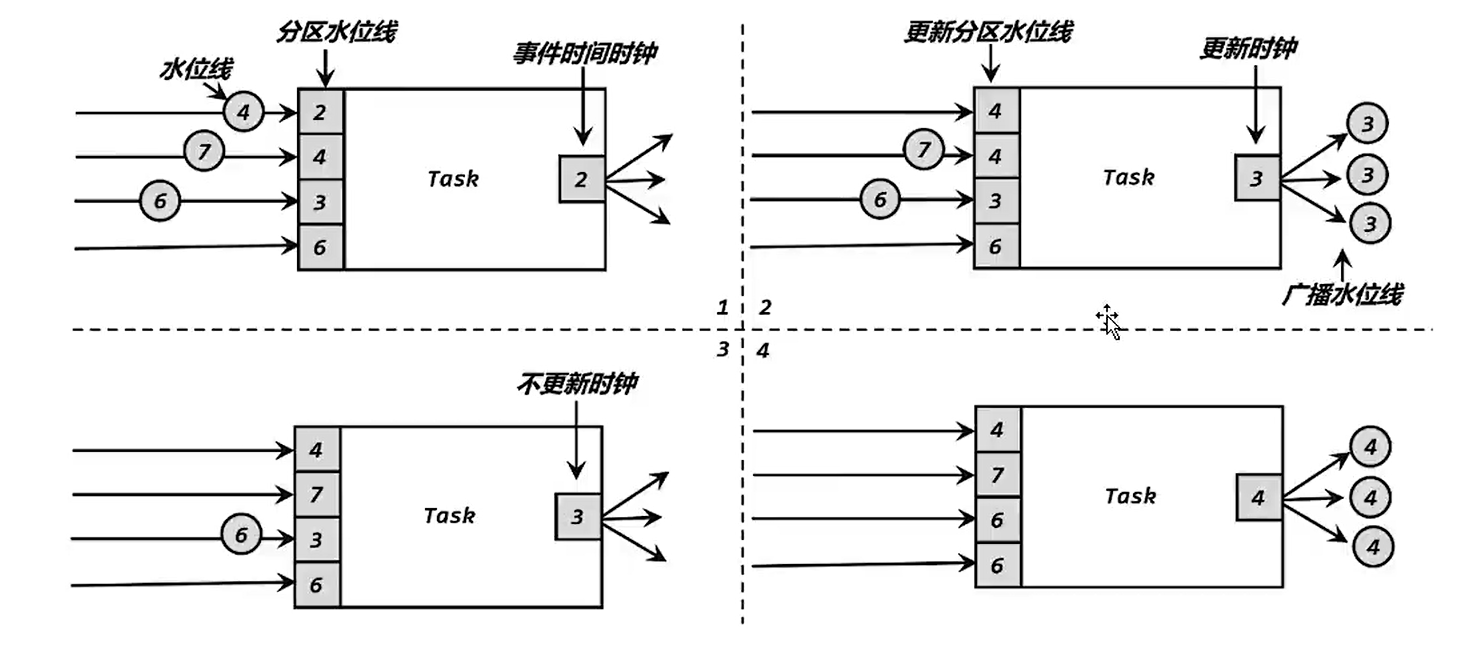

5.水位线的传递

水位线是由上游任务广播到下游任务的,如果上游有多个分区的数据传递过来的水位线是不一样的,下游会将所有分区的watermark保存起来,然后比较,以最小的为准。

#### 5.2 window的类型

1. window的理解

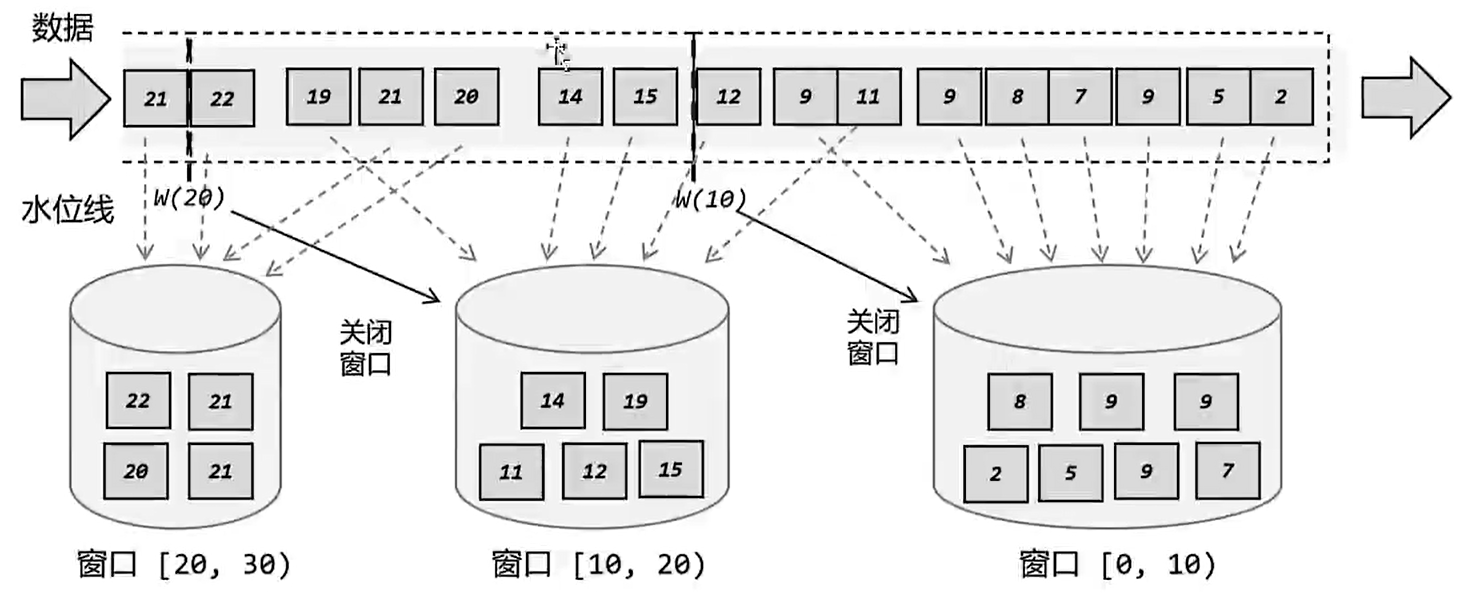

streaming 流式计算是一种被设计用于处理无限数据集的数据处理引擎,而无限数据集是指一种不断增长的本质上无限的数据集,而 window 是一种切割无限数据为有限块进行处理的手段。

Window 是Flink无限数据流处理的核心,Window 将一个无限的 stream 拆分成有限大小的” buckets” 桶, 我们可以在这些桶上做计算操作。

2. bucket

> 桶不是静态准备好的,而是当该时间段的数据到了之后,自动创建的。

3.窗口的分类

1. 按照驱动类型分类

1. 时间窗口:按照时间段去截取数据窗口。

2. 计数窗口:按照固定的数据的个数来划分窗口,每一个窗口中的数据是一样的。

2. 按照窗口分配数据的规则分类

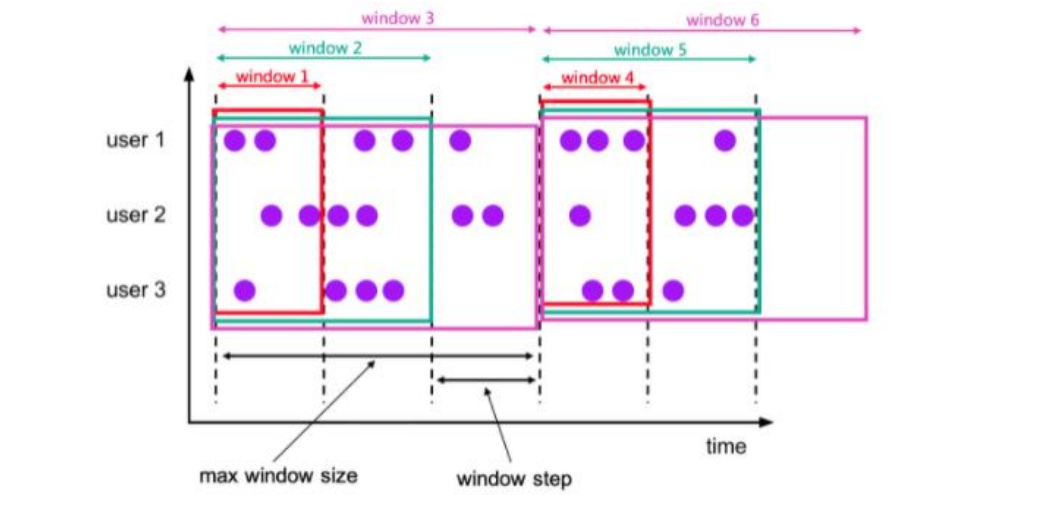

1. 滚动窗口(Tumbling windows):有固定的大小,是一种对数据进行均匀切片的划分方式,窗口之间不能重叠,所以数据只能被分到唯一的一个窗口中。可以基于时间定义,也可以基于数量来定义,只需要指定窗口大小。

2. 滑动窗口(Sliding windows):和滚动窗口类似,大小也是固定的,但是窗口之间不是首位相接的,而是可以错开一定的位置的。需要传入两个参数:窗口大小,滑动步长(可以理解为统计的频次)。如果我们将滑动步长和窗口大小设置为一样,那么实际上就是滚动窗口了。

3. 会话窗口:基于会话来对数据进行分组,只能基于时间来定义。最重要的参数是会话的超时时间(gap),如果两个数据的时间间隔小于指定的大小,那说明还在保持会话,他们就属于同一个窗口;如果大于size,那么新来的数据就应该属于新的会话窗口,前一个窗口就应该关闭了。

4. 全局窗口:全局有效,会将相同的key的所有数据都分配到同一个窗口中,这种窗口没有结束的时候,默认是不会触发计算的,如果希望他能对数据进行计算处理,还需要自定义“触发器(trigger)”。Flink 的计数窗口(Count window)底层就是使用全局窗口实现的。

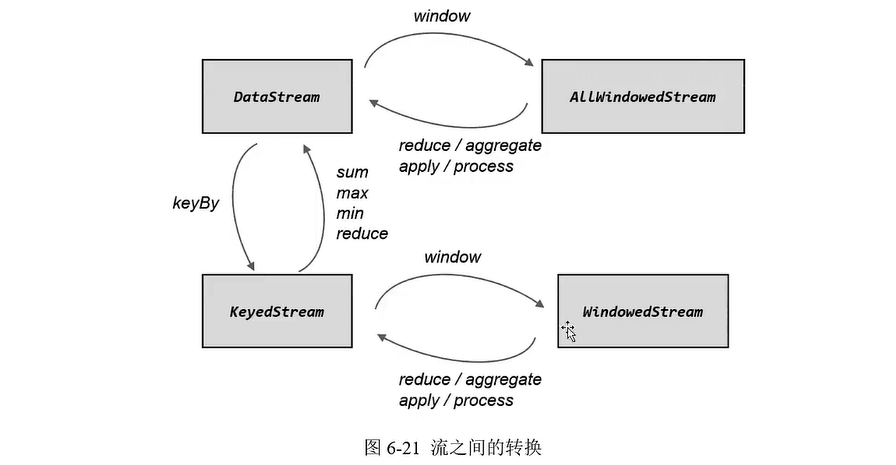

3.是否按键分区

1. 按键分区窗口:使用keyBy操作之后,数据流会按照key被分为多条逻辑流,这个就是KeyedStream,基于这种流做窗口操作的时候,窗口计算会在多个并行子任务上同时执行,相同的key的数据会被发送到同一个并行子任务,窗口操作会基于每个key进行单独处理,可以认为每个key上都定义了一组窗口,各自独立的进行统计计算。

```java

stream.keyBy().window()

```

2. 非按键分区:这种方式窗口逻辑只会在一个task上执行任务,相当于并行度变成了1,实际应用中`不推荐`。

```java

stream.windowAll()

```

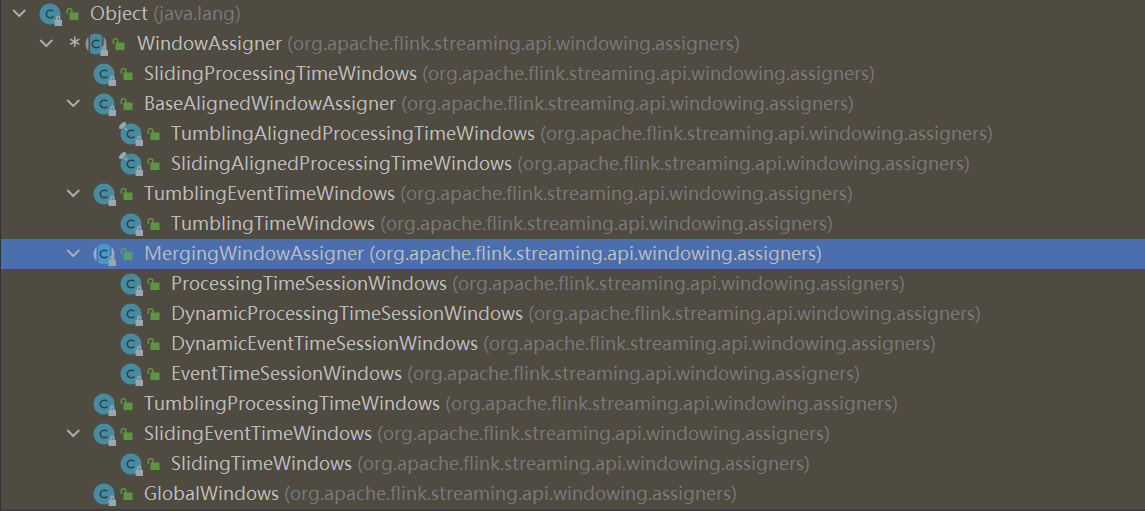

4.窗口分配器(window Assigners)

作用:主要用于定义数据应该被分配到哪一个窗口中。

5 窗口函数

作用:单独的window Assigners是不构成operator的,需要和一个窗口函数配合使用,根据处理的方式,我们分为两类:增量聚合函数和全窗口函数。

- 增量聚合函数:使用流处理的思路,每来一个数据我们就在之前的结果上聚合一次,这就是“增量聚合”。例如:ReduceFunction和AggregateFunction。

- ReduceFunction:规约函数要求输入输出的数据类型是一致的。

- AggregateFunction:输出/输出类型可以不一致

- 存在三个类型:

- 输入类型IN:输入流中元素的数据类型。

- 累加器类型ACC:我们进行聚合的中间状态类型。

- 输出类型OUT:最终计算结果的类型。

- 四个接口:

- createAccumulator:创建一个累加器,这就是为聚合创建了一个初始状态,每个聚合任务只会调用一次。

- add:将输入的元素添加到累加器中。

- getResult:从累加器中提取聚合的输出结果。

- merge:合并两个累加器,并将合并后的在状态作为一个累加器返回。

- 全窗口函数:批处理的方式,计算先收集窗口中的数据,并在内部缓存起来,等到窗口要输出结果的时候再取出数据进行计算。

- 窗口函数(WindowFunction):通过WindowedStream.apply()的方式使用,早期版本,会被ProcessWindowFunction所取代。

- ProcessWindowFunction:继承AbstractRichFunction可以获取应用上下文信息。

实际的项目中:增量聚合函数(agg)+全窗口函数(processWindow)

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment)

//调用flink内置的针对于有序流的watermark策略

.assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ofSeconds(2)).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

eventSource.keyBy(event -> event.url)

//滑动事件时间窗口

//.window(SlidingEventTimeWindows.of(Time.hours(1)))

//滚动事件时间窗口:默认是整点,可以通过offset来进行调整

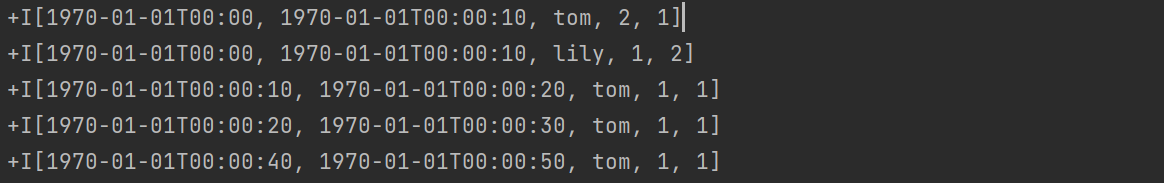

.window(TumblingEventTimeWindows.of(Time.seconds(2L)))

//聚合函数:

.aggregate(new WindowAggAndProcessTest.MyAggFunction(),

new WindowAggAndProcessTest.MyProcessFunction()

).print();

executionEnvironment.execute();

}

static class MyAggFunction implements AggregateFunction {

@Override

public Long createAccumulator() {

return 0L;

}

@Override

public Long add(Event value, Long accumulator) {

return accumulator + 1;

}

@Override

public Long getResult(Long accumulator) {

return accumulator;

}

@Override

public Long merge(Long a, Long b) {

return null;

}

}

static class MyProcessFunction extends ProcessWindowFunction {

@Override

public void process(String s, ProcessWindowFunction.Context context, Iterable elements, Collector out) throws Exception {

long start = context.window().getStart();

long end = context.window().getEnd();

long count = elements.iterator().next();

out.collect(new UrlVisitBean(s, count, start, end));

}

}

```

6 其他API

1. 触发器(Trigger):用于定义什么时候触发计算,Trigger是窗口算子内部属性,每个窗口分配器(windowAssigner)都会对应一个默认的触发器;对于Flink内置的窗口类型,他们的触发器已经做了实现。

2. 允许延迟(Allowed Lateness):真正的延迟窗口的关闭时间。

3. 将迟到的数据放到侧输出流中sideOutputLateData:如果数据在窗口关闭之后依旧有漏网之鱼,我们可以使用侧输出流的方式,最终将两个流的数据merge到一起,实现最终一致性。

#### 5.3 处理迟到数据

- watermark:来处理迟到数据,它实际是将所有的操作都延迟,这个操作过重。一般情况下我们设置watermark的延迟时间在1,2ms。

- allowedLateness:延迟窗口关闭时间,还是允许一段时间内还可以将数据放过来。

- 侧输出流:类似于lambda架构,使用双流的方式实现对延迟数据的处理

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

executionEnvironment.getConfig().setAutoWatermarkInterval(100);

SingleOutputStreamOperator socketStream = executionEnvironment.socketTextStream("hadoop02", 7777).map(new MapFunction() {

@Override

public Event map(String value) throws Exception {

String[] data = value.split(",");

return new Event(data[0].trim(), data[1].trim(), Long.valueOf(data[2].trim()));

}

}).assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ofSeconds(2L)).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

socketStream.print("input");

//定义输出标签:注意泛型擦除

OutputTag lateTag = new OutputTag("lateStream") {

};

SingleOutputStreamOperator result = socketStream.keyBy(data -> data.url).window(TumblingEventTimeWindows.of(Time.seconds(10L)))

//延迟1秒+2秒watermark=3s延迟,如果小于这个延迟时间,那么数据就会放到result里面,但是如果延迟超过这个时间那么就会输出到late的流中.

.allowedLateness(Time.seconds(1))

.sideOutputLateData(lateTag)

.aggregate(new WindowAggAndProcessTest.MyAggFunction(), new WindowAggAndProcessTest.MyProcessFunction());

result.print("result");

//获取侧输出流的结果:只要前一个窗口没有关闭,一旦来属于其中的数据,那么就会触发一次计算.

result.getSideOutput(lateTag).print("late");

executionEnvironment.execute();

}

```

### 6 处理函数--ProcessFunction

#### 6.1 基本介绍

1. 为什么使用?

如果我们需要对时间有更精细的控制,获取水位线,设置要把控时间,这就不是基本的时间窗口可以实现的了,就需要使用更底层ProcessFunction。提供一个定时服务(TimerService),我们可以通过它访问流中的事件(event),事件戳(timestamp),水位线(watermark),甚至可以注册“定时事件”。继承了AbstractRichFunction类,所以可以获取各种状态和上下文信息,是DataStream Api的底层基础。

2. 分类

- ProcessFunction:无法注册定时器

- KeyedProcessFunction:可以使用定时器

- ProcessWindowFunction:无法直接使用定时器,但是可以使用trigger来实现。

- CoProcessFunction

- ProcessJoinFunction

- BroadcastProcessFunction

- KeyedBroadcastProcessFunction

- ProcessAllWindowFunction

#### 6.2 TopN

> 方案1:使用ProcessAllwindowFunction的方式,处理分区数目为1,数据量大的时候会出现问题。

```java

public class TopNTest2 {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator sourceStream = SourceUtils.getEventSource(executionEnvironment).assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

sourceStream.map(data -> data.url)

.windowAll(SlidingEventTimeWindows.of(Time.seconds(10), Time.seconds(5)))

.aggregate(new UrlHashMapCountAgg(), new UrlAllWindowResult()).print();

executionEnvironment.execute();

}

public static class UrlHashMapCountAgg implements AggregateFunction, ArrayList>> {

@Override

public HashMap createAccumulator() {

return new HashMap<>();

}

@Override

public HashMap add(String value, HashMap accumulator) {

Long oldCount = accumulator.getOrDefault(value, 0L);

accumulator.put(value, oldCount + 1);

return accumulator;

}

@Override

public ArrayList> getResult(HashMap accumulator) {

ArrayList> list = new ArrayList<>();

for (Map.Entry entry : accumulator.entrySet()) {

list.add(Tuple2.of(entry.getKey(), entry.getValue()));

}

list.sort(new Comparator>() {

@Override

public int compare(Tuple2 o1, Tuple2 o2) {

return (int) (o2.f1 - o1.f1);

}

});

return list;

}

@Override

public HashMap merge(HashMap a, HashMap b) {

return null;

}

}

public static class UrlAllWindowResult extends ProcessAllWindowFunction>, String, TimeWindow> {

@Override

public void process(ProcessAllWindowFunction>, String, TimeWindow>.Context context, Iterable>> elements, Collector out) throws Exception {

ArrayList> list = elements.iterator().next();

StringBuilder result = new StringBuilder();

Timestamp start = new Timestamp(context.window().getStart());

Timestamp end = new Timestamp(context.window().getEnd());

result.append("------------ window [" + start + "~" + end + "]Top 2--------------------\n");

for (int i = 0; i < list.size() && i < 2; i++) {

Tuple2 urlInfo = list.get(i);

result.append("No" + i + ". " + urlInfo.f0 + " = " + urlInfo.f1 + "\n");

}

result.append("----------------------------------------\n");

out.collect(result.toString());

}

}

}

```

> 方案2:聚合+windowEndTimeKeyby+KeyedProcessFunction+状态列表

```java

public class TopNTest1 {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator sourceStream = SourceUtils.getEventSource(executionEnvironment)

.assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

SingleOutputStreamOperator urlCountStream = sourceStream.keyBy(event -> event.url)

.window(SlidingEventTimeWindows.of(Time.seconds(10), Time.seconds(5)))

.aggregate(new WindowAggAndProcessTest.MyAggFunction(), new WindowAggAndProcessTest.MyProcessFunction());

urlCountStream.print("url count");

urlCountStream.keyBy(data -> data.windowEnd)

.process(new TopNProcessResult(2))

.print("top n");

executionEnvironment.execute();

}

public static class TopNProcessResult extends KeyedProcessFunction {

private Integer n;

//定义状态列表,而且这个对象需要交给flink进行管理,所以不能直接初始化,应该在生命周期函数中进行初始化。

private ListState urlViewCountListState;

public TopNProcessResult(Integer n) {

this.n = n;

}

@Override

public void open(Configuration parameters) throws Exception {

urlViewCountListState = getRuntimeContext().getListState(

new ListStateDescriptor("url_count_list", Types.POJO(UrlVisitBean.class))

);

}

@Override

public void processElement(UrlVisitBean value, KeyedProcessFunction.Context ctx, Collector out) throws Exception {

urlViewCountListState.add(value);

//注册一个windowEnd+1ms的定时器

ctx.timerService().registerEventTimeTimer(ctx.getCurrentKey() + 1);

}

@Override

public void onTimer(long timestamp, KeyedProcessFunction.OnTimerContext ctx, Collector out) throws Exception {

//定时器处理

ArrayList list = new ArrayList<>();

for (UrlVisitBean urlVisitBean : urlViewCountListState.get()) {

list.add(urlVisitBean);

}

list.sort(new Comparator() {

@Override

public int compare(UrlVisitBean o1, UrlVisitBean o2) {

return (int) (o2.count - o1.count);

}

});

StringBuilder result = new StringBuilder();

Timestamp end = new Timestamp(ctx.getCurrentKey());

result.append("------------ window [ 窗口结束时间:" + end + "]Top 2--------------------\n");

for (int i = 0; i < list.size() && i < 2; i++) {

UrlVisitBean urlInfo = list.get(i);

result.append("No" + i + ". " + urlInfo.url + " = " + urlInfo.count + "\n");

}

result.append("----------------------------------------\n");

out.collect(result.toString());

}

}

}

```

### 7 多流转换

> 多流转换可以分为`分流`和`合流`两大类。目前分流主要通过侧输出流来实现。合流的算子比较丰富,根据不同的需求可以掉哟个union,connect,join以及coGroup等接口进行连接合并操作。

#### 7.1 分流

> 使用侧输出流的方式实现。

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment).assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

//如果用户是tom,那么将数据输出到

OutputTag> tomTag = new OutputTag<>("tom", Types.TUPLE(Types.STRING, Types.STRING, Types.LONG));

SingleOutputStreamOperator processedStream = eventSource.process(new ProcessFunction() {

@Override

public void processElement(Event value, ProcessFunction.Context ctx, Collector out) throws Exception {

if ("tom".equals(value.user)) {

ctx.output(tomTag, Tuple3.of(value.user, value.url, value.timestamp));

} else {

out.collect(value);

}

}

});

processedStream.getSideOutput(tomTag).print("tom stream");

processedStream.print("other user stream");

executionEnvironment.execute();

}

```

#### 7.2 合流

> 将多条流合并起来。

##### 7.2.1 Union

要求流中的数据类型必须相同,合并之后的新流会包括所有流的元素,数据类型不变,使用。

问题:如果两个流的watermark延迟是不一样的,那么合并之后的水位线是什么?--注意水位线的滞后,先处理再更新水位线。

demo:

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

String hostname = "hadoop02";

int port1 = 7777;

int port2 = 8888;

SingleOutputStreamOperator source1 = executionEnvironment.socketTextStream(hostname, port1).map(data -> {

String[] split = data.split(",");

return new Event(split[0].trim(), split[1].trim(), Long.valueOf(split[2].trim()));

}).returns(Types.POJO(Event.class))

.assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ofSeconds(5)).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

source1.print("source1");

SingleOutputStreamOperator source2 = executionEnvironment.socketTextStream(hostname, port2).map(data -> {

String[] split = data.split(",");

return new Event(split[0].trim(), split[1].trim(), Long.valueOf(split[2].trim()));

}).returns(Types.POJO(Event.class))

.assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ofSeconds(10)).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

source2.print("source2");

source1.union(source2).process(new ProcessFunction() {

@Override

public void processElement(Event value, ProcessFunction.Context ctx, Collector out) throws Exception {

out.collect("水位线:" + ctx.timerService().currentWatermark());

}

}).print("watermark");

executionEnvironment.execute();

}

```

console:

```txt

source2> Event{user='tom', url='./index', timestamp=1970-01-01 08:00:01.0}

watermark> 水位线:-9223372036854775808

source1> Event{user='tom', url='./index', timestamp=1970-01-01 08:00:02.0}

watermark> 水位线:-9223372036854775808

source1> Event{user='tom', url='./index', timestamp=1970-01-01 08:00:02.0}

watermark> 水位线:-9001

source2> Event{user='tom', url='./index', timestamp=1970-01-01 08:00:10.0}

watermark> 水位线:-9001

source1> Event{user='tom', url='./index', timestamp=1970-01-01 08:00:09.0}

watermark> 水位线:-3001

source1> Event{user='tom', url='./index', timestamp=1970-01-01 08:00:09.0}

watermark> 水位线:-1

source2> Event{user='tom', url='./index', timestamp=1970-01-01 08:00:10.0}

watermark> 水位线:-1

```

结论:水位线会取多个流中比较小的那个,水位线的延迟会取多个流中延迟大的。

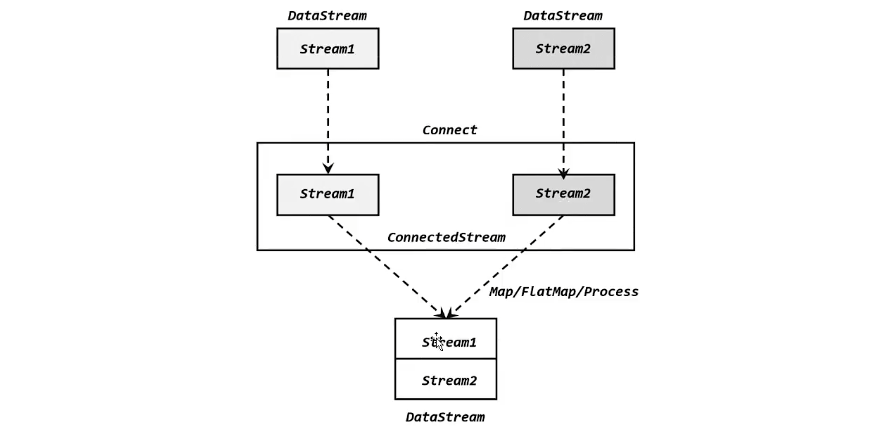

##### 7.2.2 Connect

> 多个流的类型不一致,可以使用connect进行连接,获取的是connectedStream

1. 如果想要再次获取DataStream,我们需要协同函数进行类型转换,map/flatmap中传入CoMapFunction/CoFlatMapFunction,将多个流的类型统一起来。

CoMapFunction Demo:

```java

DataStreamSource source1 = executionEnvironment.fromElements(1, 2, 3);

DataStreamSource source2 = executionEnvironment.fromElements(4L, 5L, 6L);

source1.connect(source2).map(new CoMapFunction() {

@Override

public String map1(Integer value) throws Exception {

return "Integer type: " + value;

}

@Override

public String map2(Long value) throws Exception {

return "Long type: " + value;

}

}).print("result");

```

2. 双流connect来对账功能:使用keyBy可以将两个流连接到一起进行处理

```java

/**

* connect实现对账功能.

*

* @author code1997

*/

public class BillCheckDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

SingleOutputStreamOperator> appStream = executionEnvironment.fromElements(

Tuple3.of("order-1", "app", 1000L),

Tuple3.of("order-2", "app", 2000L),

Tuple3.of("order-3", "app", 3500L)

).assignTimestampsAndWatermarks(WatermarkStrategy.>forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner>() {

@Override

public long extractTimestamp(Tuple3 element, long recordTimestamp) {

return element.f2;

}

}));

SingleOutputStreamOperator> thirdPartStream = executionEnvironment.fromElements(

Tuple4.of("order-1", "third-party", "success", 3000L),

Tuple4.of("order-3", "third-party", "success", 4000L)

).assignTimestampsAndWatermarks(WatermarkStrategy.>forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner>() {

@Override

public long extractTimestamp(Tuple4 element, long recordTimestamp) {

return element.f3;

}

}));

appStream.connect(thirdPartStream).keyBy(data -> data.f0, data -> data.f0)

.process(new OrderMatchResult())

.print();

executionEnvironment.execute();

}

public static class OrderMatchResult extends CoProcessFunction, Tuple4, String> {

//定义状态变量,用来保存已经到达的事件

private ValueState> appEventState;

private ValueState> thirdPartyEventState;

@Override

public void open(Configuration parameters) throws Exception {

appEventState = getRuntimeContext().getState(new ValueStateDescriptor<>("app-event", Types.TUPLE(Types.STRING, Types.STRING, Types.LONG)));

thirdPartyEventState = getRuntimeContext().getState(new ValueStateDescriptor<>("third-party-event", Types.TUPLE(Types.STRING, Types.STRING, Types.STRING, Types.LONG)));

}

@Override

public void processElement1(Tuple3 value, CoProcessFunction, Tuple4, String>.Context ctx, Collector out) throws Exception {

//查看thirdPartyEvent的值是否来过

if (thirdPartyEventState.value() != null) {

out.collect("对账成功:" + value + " " + thirdPartyEventState.value());

thirdPartyEventState.clear();

} else {

appEventState.update(value);

//注意一个五秒后的定时器。等待令一个流的事件.

ctx.timerService().registerEventTimeTimer(value.f2 + 5000L);

}

}

@Override

public void processElement2(Tuple4 value, CoProcessFunction, Tuple4, String>.Context ctx, Collector out) throws Exception {

//查看thirdPartyEvent的值是否来过

if (appEventState.value() != null) {

out.collect("对账成功:" + appEventState.value() + " " + value);

appEventState.clear();

} else {

thirdPartyEventState.update(value);

//这个流要晚于appEvent的流

ctx.timerService().registerEventTimeTimer(value.f3);

}

}

@Override

public void onTimer(long timestamp, CoProcessFunction, Tuple4, String>.OnTimerContext ctx, Collector out) throws Exception {

//判断状态,如果某个状态不为null,说明另一条流的事件没来.

if (appEventState.value() != null) {

out.collect("对账失败:" + appEventState.value() + " " + "第三方支付平台信息未到");

}

if (thirdPartyEventState.value() != null) {

out.collect("对账失败:" + thirdPartyEventState.value() + " " + "app的信息未到");

}

appEventState.clear();

thirdPartyEventState.clear();

}

}

}

```

##### 7.2.3 双流join

1)window join

使用:DataStream.join,实际上是内连接。

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

SingleOutputStreamOperator> appStream = executionEnvironment.fromElements(

Tuple3.of("order-1", "app", 1000L),

Tuple3.of("order-2", "app", 2000L),

Tuple3.of("order-3", "app", 3500L)

).assignTimestampsAndWatermarks(WatermarkStrategy.>forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner>() {

@Override

public long extractTimestamp(Tuple3 element, long recordTimestamp) {

return element.f2;

}

}));

SingleOutputStreamOperator> thirdPartStream = executionEnvironment.fromElements(

Tuple4.of("order-1", "third-party", "success", 3000L),

Tuple4.of("order-3", "third-party", "success", 4000L)

).assignTimestampsAndWatermarks(WatermarkStrategy.>forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner>() {

@Override

public long extractTimestamp(Tuple4 element, long recordTimestamp) {

return element.f3;

}

}));

appStream.join(thirdPartStream)

.where(data -> data.f0)

.equalTo(data -> data.f0)

.window(TumblingEventTimeWindows.of(Time.seconds(5)))

.apply(new JoinFunction, Tuple4, String>() {

@Override

public String join(Tuple3 first, Tuple4 second) throws Exception {

return "first join second: " + first + second;

}

}).print();

executionEnvironment.execute();

}

```

console:

```java

first join second: (order-1,app,1000)(order-1,third-party,success,3000)

first join second: (order-3,app,3500)(order-3,third-party,success,4000)

```

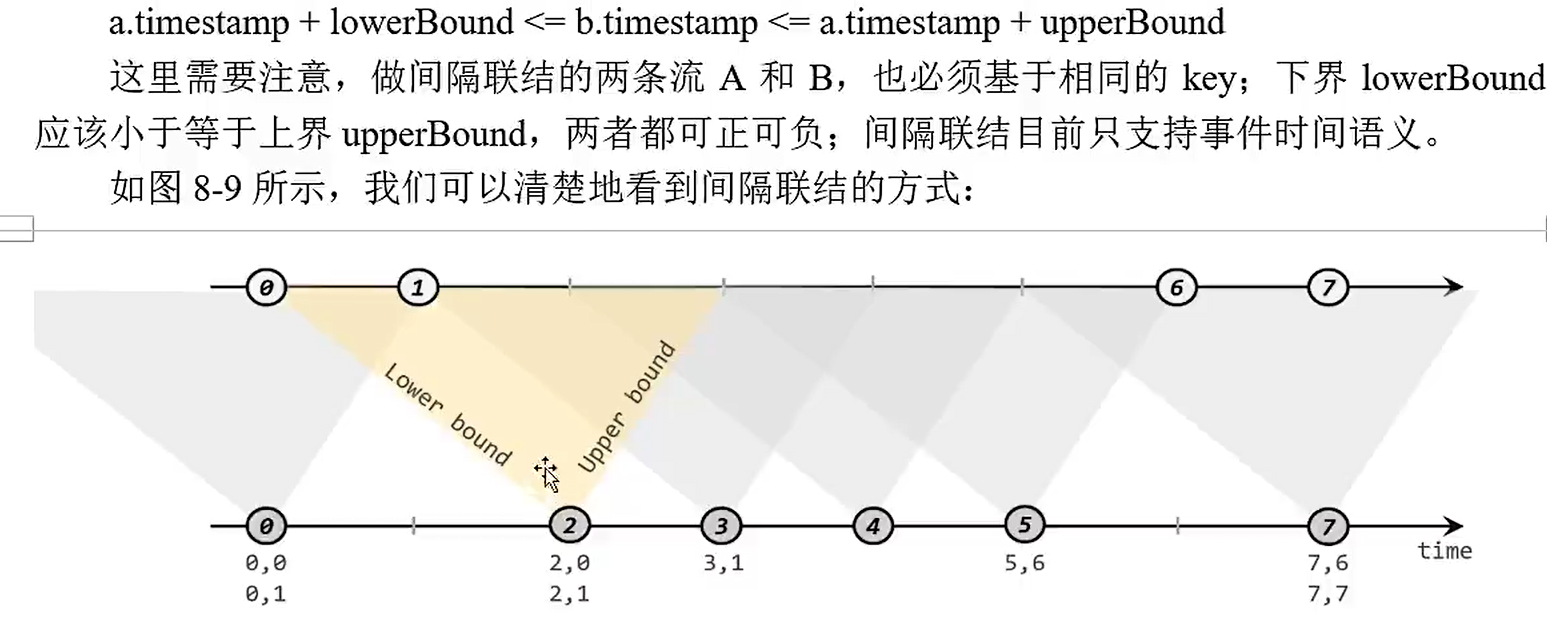

2)间隔联接

没有固定的窗口,以左边流中的每一个元素指定一个时间上下限为界和其他流进行匹配。

使用:keyStream.intervalJoin.between.process

案例:在电商网站中,某些用户行为往往存在短时间内的强关联。如果我们有两个流,一个是下订单的流,一个是浏览数据的流。我们可以针对同一童虎,做一个间隔联结,使用一个用户的下订单事件和这个用户最近十分钟的浏览数据进行一个联结查询。

code:

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = executionEnvironment.fromElements(new Event("tom", "./index", 1000L),

new Event("tom", "./product?id=10", 2000L),

new Event("lily", "./index", 1000L),

new Event("tom", "./product?id=20", 3000L),

new Event("tom", "./product?id=30", 4000L),

new Event("tom", "./product?id=20", 5000L),

new Event("tom", "./order?id=30", 6000L),

new Event("tom", "./product?id=50", 7000L),

new Event("tom", "./product?id=60", 8000L),

new Event("tom", "./product?id=70", 9000L),

new Event("lily", "./product?id=100", 7000L))

.assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

SingleOutputStreamOperator> orderSource = executionEnvironment.fromElements(Tuple2.of("tom", 7000L)).assignTimestampsAndWatermarks(WatermarkStrategy.>forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner>() {

@Override

public long extractTimestamp(Tuple2 element, long recordTimestamp) {

return element.f1;

}

}));

orderSource.keyBy(data -> data.f0).intervalJoin(eventSource.keyBy(data -> data.user))

.between(Time.seconds(-4L), Time.seconds(1L)).process(new ProcessJoinFunction, Event, String>() {

@Override

public void processElement(Tuple2 left, Event right, ProcessJoinFunction, Event, String>.Context ctx, Collector out) throws Exception {

out.collect(new StringBuilder().append("user:").append(left.f0).append("下了一个单,时间为:").append(left.f1).append(", 最近访问url为:").append(right.url).append(" , time is ").append(right.timestamp).toString());

}

}).print("near view urls ");

executionEnvironment.execute();

}

```

console:

```java

near view urls :4> user:tom下了一个单,时间为:7000, 最近访问url为:./product?id=20 , time is 3000

near view urls :4> user:tom下了一个单,时间为:7000, 最近访问url为:./product?id=30 , time is 4000

near view urls :4> user:tom下了一个单,时间为:7000, 最近访问url为:./product?id=20 , time is 5000

near view urls :4> user:tom下了一个单,时间为:7000, 最近访问url为:./order?id=30 , time is 6000

near view urls :4> user:tom下了一个单,时间为:7000, 最近访问url为:./product?id=50 , time is 7000

near view urls :4> user:tom下了一个单,时间为:7000, 最近访问url为:./product?id=60 , time is 8000

```

3)CoGroup

> 之前的window join实际上是sql的内连接,如果coGroup实际上是更一般化的方法。

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

SingleOutputStreamOperator> appStream = executionEnvironment.fromElements(

Tuple3.of("order-1", "app", 1000L),

Tuple3.of("order-2", "app", 2000L),

Tuple3.of("order-3", "app", 3500L)

).assignTimestampsAndWatermarks(WatermarkStrategy.>forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner>() {

@Override

public long extractTimestamp(Tuple3 element, long recordTimestamp) {

return element.f2;

}

}));

SingleOutputStreamOperator> thirdPartStream = executionEnvironment.fromElements(

Tuple4.of("order-1", "third-party", "success", 3000L),

Tuple4.of("order-3", "third-party", "success", 4000L)

).assignTimestampsAndWatermarks(WatermarkStrategy.>forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner>() {

@Override

public long extractTimestamp(Tuple4 element, long recordTimestamp) {

return element.f3;

}

}));

appStream.coGroup(thirdPartStream)

.where(data -> data.f0)

.equalTo(data -> data.f0)

.window(TumblingEventTimeWindows.of(Time.seconds(5)))

.apply(new CoGroupFunction, Tuple4, String>() {

@Override

public void coGroup(Iterable> first, Iterable> second, Collector out) throws Exception {

//first是第一个流的所有元素,second是第二个流的所有元素

out.collect(first + "=>" + second);

}

}).print();

executionEnvironment.execute();

}

```

console:

```txt

[(order-1,app,1000)]=>[(order-1,third-party,success,3000)]

[(order-3,app,3500)]=>[(order-3,third-party,success,4000)]

[(order-2,app,2000)]=>[]

```

### 8 状态编程

> Flink处理机制的核心就是有状态的流式计算。

#### 8.1 Flink中的状态

##### 8.1.1 状态的管理

在传统的事务性应用中,我们一般将数据存放到数据库中,如果为了更好的性能,也可以存储到redis等内存数据中,但是当数据量非常大的时候,网络传输也是一种比较大的影响。Flink则直接将状态存放到了内存中,而Flink作为一个分布式的计算框架,在低延迟,高吞吐的基础上还需要保证容错性,就带来了比较大的挑战。

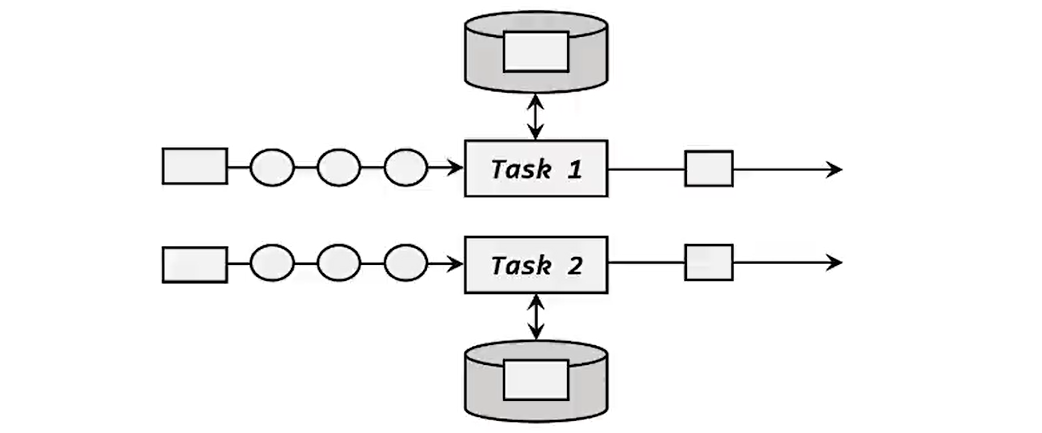

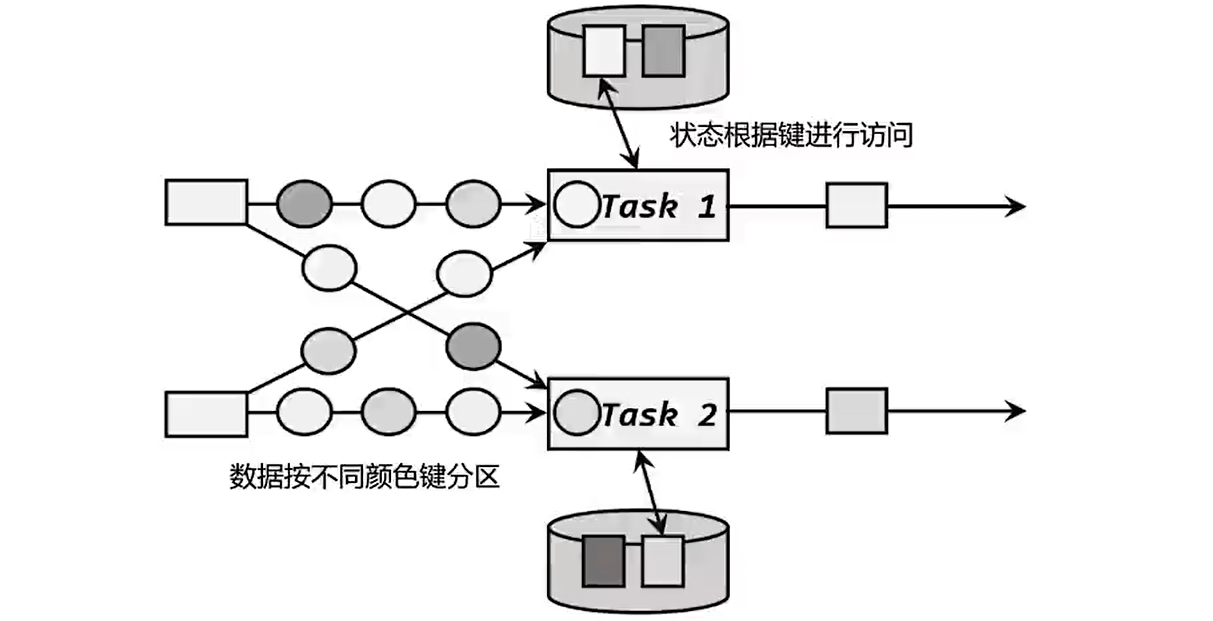

- 状态的访问权限:flink的聚合和窗口操作一般是基于KeyedStream的,会按照key的哈希值进行分区,聚合的结果只对当前key有效,然后而一个分区上执行的任务实例可能会包含多个key的数据,他们同时访问和更改本地变量可能会导致计算结果出错。

- 容错性:内存的不稳定性,我们需要考虑故障恢复,因此需要将状态持久化的保存,以便于发生故障之后可以从这个备份中恢复状态。

- 分布式应用的横向扩展:如果我们对计算资源进行扩容,调大并行度,那么状态又需要进行重组调整。

##### 8.1.2 状态划分

状态依据是否需要其他数据的参与分为有状态和无状态两种,在Flink中如果我们继承RichFunction那么就可以自定义状态。

依据管理者的不同分为托管状态和原始状态:

- 托管状态就是由Flink的runtime统一管理的,存储访问,故障恢复和重组都是由Flink实现的。聚合和窗口等算子的内置状态,Flink也提供了ValueState,ListState,MapState等多种状态。

- 算子状态:一个算子会按照并行度划分为多个并行子任务执行,而不同的子任务会占据不同的任务槽,由于不同的slot在计算资源上是物理隔离的,所以算子状态只对当前并行子任务有效,不能跨子任务进行共享。

- 按键分区状态:一个子任务依据key将状态分割开来,按键分区状态的作用范围是指定的key。之前的聚合算子需要在keyBy之后才可以使用的原因就是聚合的结果是以Keyed State的形式保存的。在底层Keyed State类似于一个分布式的映射(map)数据结构,所有的状态会根据key保存成key-value的形式,当一个数据到来的时候,任务会自动的将状态的访问范围限定为当前数据的key,从而实现不同的key之间是彼此隔离的。不同的key对应的keyed State可以进一步组成key groups,每一组对应着一个并行子任务,键组是Flink重新分配keyed state的单元,键组的数量就等于最大的并行度,当算子并行度发生改变时,KeyState也会进行重新平均分配,保证运行时各个子任务的负载相同。

- 原始状态是由我们自定义的,相当于开辟了一块内存,需要我们自己管理,实现状态的序列化和故障恢复,Flink只会将这些状态存储为最原始的字节数组来存储。

##### 8.1.3 KeyedState支持的数据结构

> 状态的关键是需要运行时上下文的配合,而为了让运行时上下文清楚到底是哪一个状态,我们还需要创建一个“状态描述器(StateDescriptor)”来提供状态的基本信息。

- ValueState:值状态,保存单个值。

- ListState:列表状态,可以使用双流join实现两个表的联结。

- MapState:映射状态,可以使用mapState来模拟窗口的功能,例如统计每个url的每个窗口期间的点击数。

```java

/**

* 使用MapState来模拟时间窗口的功能.

*

* @author code1997

*/

public class FakeWindowDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

eventSource.print("input");

eventSource.keyBy(data -> data.url)

.process(new FakeWindowFunction(5000L))

.print();

executionEnvironment.execute();

}

public static class FakeWindowFunction extends KeyedProcessFunction {

Long windowSize;

//保存窗口的统计数据

MapState fakeWindows;

public FakeWindowFunction(Long ts) {

windowSize = ts;

}

@Override

public void open(Configuration parameters) throws Exception {

fakeWindows = getRuntimeContext().getMapState(new MapStateDescriptor("fake_windows", Types.LONG, Types.LONG));

}

@Override

public void processElement(Event value, KeyedProcessFunction.Context ctx, Collector out) throws Exception {

//计算窗口的范围

Long windowStart = value.timestamp / windowSize * windowSize;

long windowEnd = windowStart + windowSize;

//注册定时器

ctx.timerService().registerEventTimeTimer(windowEnd - 1);

//更新状态,进行增量聚合

Long oldCount = fakeWindows.get(windowStart);

fakeWindows.put(windowStart, oldCount == null ? 1 : oldCount + 1);

}

@Override

public void onTimer(long timestamp, KeyedProcessFunction.OnTimerContext ctx, Collector out) throws Exception {

long windowEnd = timestamp + 1;

long windStart = windowEnd - windowSize;

String currentUrl = ctx.getCurrentKey();

Long count = fakeWindows.get(windStart);

//时间到了,进行结果的收集

out.collect("窗口:" + new Timestamp(windStart) + "~" + new Timestamp(windowEnd) + ", url:" + currentUrl + " 的点击数为:" + count);

//模拟窗口关闭,删除对应的状态

fakeWindows.remove(windStart);

}

}

}

```

- reducingState:调用add的时候不是往状态中添加元素,而是直接把新数据和之前的状态进行规约,并用得到的结果更新状态。

- AggregatingState:聚合状态,可以传入一个更加一般化的聚合函数,也就是之前我们讲过的AggregateFunction,里面通过一个累加器来表示状态,这也就是之前我们讲过的AggrateFunction,里面通过一个累加器来表示状态,聚合的状态类型可以和添加进来的数据类型完全不同,更加灵活。

代码实现:

```java

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

SingleOutputStreamOperator eventStream = SourceUtils.getEventSource(executionEnvironment).assignTimestampsAndWatermarks(WatermarkStrategy.forBoundedOutOfOrderness(Duration.ZERO).withTimestampAssigner(new SerializableTimestampAssigner() {

@Override

public long extractTimestamp(Event element, long recordTimestamp) {

return element.timestamp;

}

}));

eventStream.keyBy(data -> data.user)

.flatMap(new MyFlatMapFunction()).print();

executionEnvironment.execute();

}

public static class MyFlatMapFunction extends RichFlatMapFunction {

ValueState myValueState;

ListState myListState;

MapState myMapState;

ReducingState myReducingState;

AggregatingState myAggregatingState;

@Override

public void open(Configuration parameters) throws Exception {

//状态的初始化放到算子的生命周期方法中

myValueState = getRuntimeContext().getState(new ValueStateDescriptor("myValueState", Types.POJO(Event.class)));

myListState = getRuntimeContext().getListState(new ListStateDescriptor("myListState", Types.POJO(Event.class)));

myMapState = getRuntimeContext().getMapState(new MapStateDescriptor("myMapState", Types.STRING, Types.LONG));

myReducingState = getRuntimeContext().getReducingState(new ReducingStateDescriptor("myReducingState", new ReduceFunction() {

@Override

public Long reduce(Long value1, Long value2) throws Exception {

return value1 + value2;

}

}, Types.LONG));

myAggregatingState = getRuntimeContext().getAggregatingState(new AggregatingStateDescriptor("myAggregatingState", new AggregateFunction() {

@Override

public String createAccumulator() {

return "url的集合:\n";

}

@Override

public String add(Event value, String accumulator) {

return accumulator + "\n" + value.url;

}

@Override

public String getResult(String accumulator) {

return accumulator;

}

@Override

public String merge(String a, String b) {

return null;

}

}, Types.STRING));

}

@Override

public void flatMap(Event value, Collector out) throws Exception {

//value

//System.out.println(myValueState.value());

myValueState.update(value);

//System.out.println("==update==" + myValueState.value());

//list

myListState.add(value);

//map

Long tempCount = myMapState.get(value.user);

myMapState.put(value.user, (tempCount == null) ? 1 : (tempCount + 1));

System.out.println("==myMapState::" + value.user + "==" + myMapState.get(value.user));

//myReducingState

myReducingState.add(value.timestamp);

System.out.println("==myReducingState==" + myReducingState.get());

//myAggregatingState

myAggregatingState.add(value);

System.out.println("==myAggregatingState==" + myAggregatingState.get());

}

}

```

##### 8.1.4 状态的TTL

对于flink来说,我们不能将状态的回收直接交给GC来进行处理,类似于redis的TTL,我们可以设置某个状态的超时时间,如果一个key超过指定TTL时间没有被访问,下一次被访问的时候会被删除掉;如果没有超过则会刷新生存时间。

```

StateTtlConfig stateTtlConfig = StateTtlConfig.newBuilder(Time.hours(1)).build();

myValueState.enableTimeToLive(stateTtlConfig);

```

source code:

```java

/**

updateType: default is OnCreateAndWrite

stateVisibility: default is NeverReturnExpired

ttlTimeCharacteristic: default is ProcessingTime

*/

@Nonnull

public StateTtlConfig build() {

return new StateTtlConfig(

updateType,

stateVisibility,

ttlTimeCharacteristic,

ttl,

new CleanupStrategies(strategies, isCleanupInBackground));

}

```

##### 8.1.5 算子状态

除了按键分区状态之外,另一类的状态就是算子状态。算子状态跟数据的key没有关系,所以不同的key的数据只要被分到同一个并行子任务,就会访问到同一个Operator state,一般用于source或者sink和外部系统进行连接的时候。

算子状态支持以下三种类型:

- ListState:每一个并行子任务上只保存一个列表,当算子的并行进行缩放调整的时候,会将算子的列表状态中的所有元素项统一收集起来形成大列表,然后使用轮询的方式将元素项平均分配,这种方式也叫做平均分割重组。

- UnionListState:联合列表状态也是一个列表和列表状态的区别在于算子并行度进行缩放调整的时候对于状态的分配方式不同。联合列表状态也会将状态联合成一个大的列表,然后将完整的列表广播出去,并行子任务获取到完整的状态项之后,可以自行选择要使用/丢弃的状态项,这种分配方式也叫做联合重组。如果列表中的状态项数量太多,为资源和效率考虑一般不建议使用重组的方式。

- BroadcastState:有时候我们希望算子并行子任务保持同一份”全局“状态来作为统一的配置和规则设定,这时所有的分区的所有数据都会访问到同一个状态,这种特殊的算子被称为广播状态。在底层使用类似于map的方式来保存的,且必须基于广播流来创建。

状态和本地变量的区别在于Flink会为状态提供完整的管理机制,来保证他的持久化保存,以便于发生故障恢复的时候`状态恢`复以及需要对`不同的key保存独立的状态实例`。KeyedState对两个功能都要考虑;而算子状态并不考虑key的影响,所以主要任务是状态持久化和保存,对于keyStream来说因为相同的key使用会分到同一个分区中,只要状态也按照key的hash值计算出对应的分区,进行重新分配就可以了,恢复状态后处理数据也可以按照key找到对应的状态也就保证了结果的一致性,而这些事情Flink已经做好了,我们不需要做任何处理。但是对于算子状态就需要我们进行处理。因此Flink给我们提供了接口供我们自己去实现。

- CheckpointedFunction:用于对状态进行持久化保存的快照机制称为检查点。

```java

@Public

public interface CheckpointedFunction {

/**

* This method is called when a snapshot for a checkpoint is requested. This acts as a hook to

* the function to ensure that all state is exposed by means previously offered through {@link

* FunctionInitializationContext} when the Function was initialized, or offered now by {@link

* FunctionSnapshotContext} itself.

*

* @param context the context for drawing a snapshot of the operator

* @throws Exception Thrown, if state could not be created ot restored.

*/

void snapshotState(FunctionSnapshotContext context) throws Exception;

/**

* This method is called when the parallel function instance is created during distributed

* execution. Functions typically set up their state storing data structures in this method.

*

* @param context the context for initializing the operator

* @throws Exception Thrown, if state could not be created ot restored.

*/

void initializeState(FunctionInitializationContext context) throws Exception;

}

```

-

demo:自定义的sinkFunction在CheckpointedFunction中进行数据缓存,然后统一发送到下游。

```java

/**

* 批量写出以及故障恢复.

* @author code1997

*/

public class BufferingSinkDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

SingleOutputStreamOperator eventSource = SourceUtils.getEventSource(executionEnvironment);

eventSource.print("input");

eventSource.addSink(new BufferingSink(5));

executionEnvironment.execute();

}

public static class BufferingSink implements SinkFunction, CheckpointedFunction {

private final int bufferSize;

private final List bufferedElements;

private ListState checkPointedState;

public BufferingSink(int bz) {

if (bz < 1) {

throw new IllegalArgumentException("buffer size must be more than 1");

}

this.bufferSize = bz;

this.bufferedElements = new ArrayList<>();

}

/**

* 每来一个数据我们需要做的.

*/

@Override

public void invoke(Event value, Context context) throws Exception {

bufferedElements.add(value);

//判断如果达到阈值,就批量写入

if (bufferedElements.size() == bufferSize) {

//写入数据到外部系统

for (Event event : bufferedElements) {

System.out.println(event);

}

System.out.println("========写出完毕=======");

bufferedElements.clear();

}

}

@Override

public void snapshotState(FunctionSnapshotContext context) throws Exception {

//需要清理状态

checkPointedState.clear();

//对状态进行持久化,复制缓存的列表到列表状态

for (Event event : bufferedElements) {

checkPointedState.add(event);

}

}

@Override

public void initializeState(FunctionInitializationContext context) throws Exception {

//初始化状态

ListStateDescriptor listStateDescriptor = new ListStateDescriptor<>("buffered_states", Types.POJO(Event.class));

checkPointedState = context.getOperatorStateStore().getListState(listStateDescriptor);

//如果从故障恢复,需要将ListState中所有元素复制到列表中

if (context.isRestored()) {

for (Event event : checkPointedState.get()) {

bufferedElements.add(event);

}

}

}

}

}

```

广播状态:动态配置或者动态规则的时候可以使用广播状态实现。使用流处理的事件驱动思路,将这动态的配置数据看作一条流,将这条流和本身要处理的数据流进行连接,这样就可以实时的更新配置进行计算了。

```java

/**

* 检测用户登录-下单,登录-支付的频次.

*

* @author code1997

*/

public class BehaviorPatternDetectDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

executionEnvironment.setParallelism(1);

DataStreamSource actionSource = executionEnvironment.fromElements(

new Action("Alice", "login"),

new Action("Alice", "pay"),

new Action("Bob", "login"),

new Action("Bob", "order")

);

//定义广播状态描述器

MapStateDescriptor rules = new MapStateDescriptor<>("rules", Types.VOID, Types.POJO(Pattern.class));

BroadcastStream patternBroadcastStream = executionEnvironment.fromElements(

new Pattern("login", "pay"),

new Pattern("login", "order")

).broadcast(rules);

actionSource.keyBy(data -> data.user)

.connect(patternBroadcastStream)

.process(new KeyedBroadcastProcessFunction>() {

//定义一个keyedState用于保存上一次用户的行为.

ValueState prevAction;

@Override

public void open(Configuration parameters) throws Exception {

prevAction = getRuntimeContext().getState(new ValueStateDescriptor<>("prev_action", Types.STRING));

}

@Override

public void processElement(Action value, KeyedBroadcastProcessFunction>.ReadOnlyContext ctx, Collector> out) throws Exception {

ReadOnlyBroadcastState pattern = ctx.getBroadcastState(new MapStateDescriptor<>("rules", Types.VOID, Types.POJO(Pattern.class)));

Pattern rule = pattern.get(null);

//获取用户上一次的行为

String prevAct = prevAction.value();

if (prevAct != null && rule != null) {

if (rule.action1.equalsIgnoreCase(prevAct) && rule.action2.equalsIgnoreCase(value.action)) {

out.collect(Tuple2.of(ctx.getCurrentKey(), rule));

}

}

prevAction.update(value.action);

}

@Override

public void processBroadcastElement(Pattern value, KeyedBroadcastProcessFunction>.Context ctx, Collector> out) throws Exception {

//从上下文中获取广播状态并更新广播状态

BroadcastState curPattern = ctx.getBroadcastState(new MapStateDescriptor<>("rules", Types.VOID, Types.POJO(Pattern.class)));

curPattern.put(null, value);

}

}).returns(Types.TUPLE(Types.STRING, Types.POJO(Pattern.class))).print();

executionEnvironment.execute();

}

public static class Action {

public String user;

public String action;

public Action(String user, String action) {

this.user = user;

this.action = action;

}

}

public static class Pattern {

public String action1;

public String action2;

public Pattern(){

}

public Pattern(String action1, String action2) {

this.action1 = action1;

this.action2 = action2;

}

@Override

public String toString() {

return "Pattern{" +

"action1='" + action1 + '\'' +

", action2='" + action2 + '\'' +

'}';

}

}

}

```

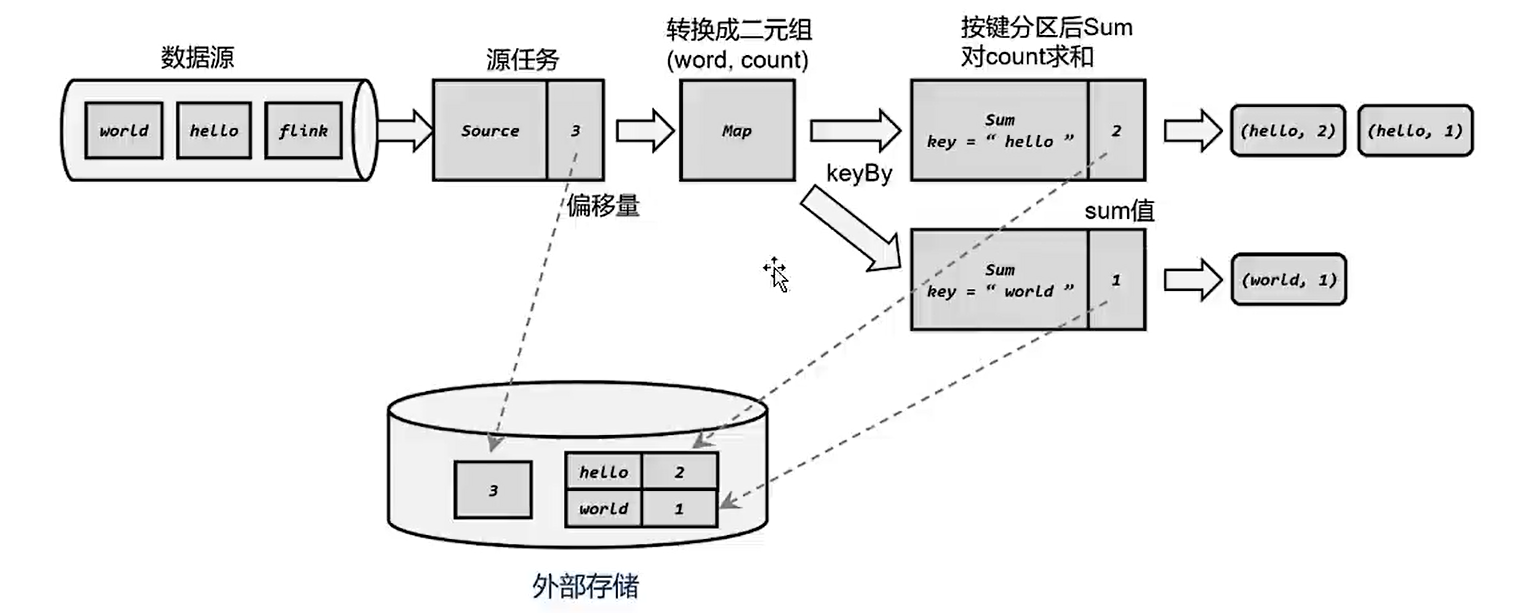

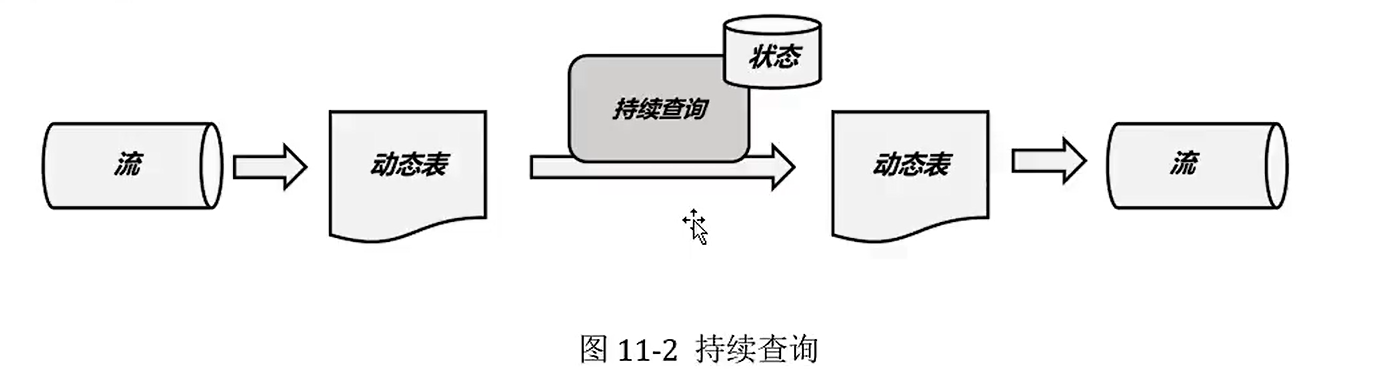

#### 8.2 持久化

Flink对状态进行持久化,将当前的分布式快照进行状态保存到外部的存储系统中,一般称为检查点,Flink还提供了保存点机制(savePoint),但是需要我们手动去实现。存储系统一般为分布式存储系统。

##### 8.2.1 检查点

Flink发生故障之后,Flink就会用最近一次成功保存的检查点来恢复应用的状态,重启处理流程,类似于游戏读档功能。

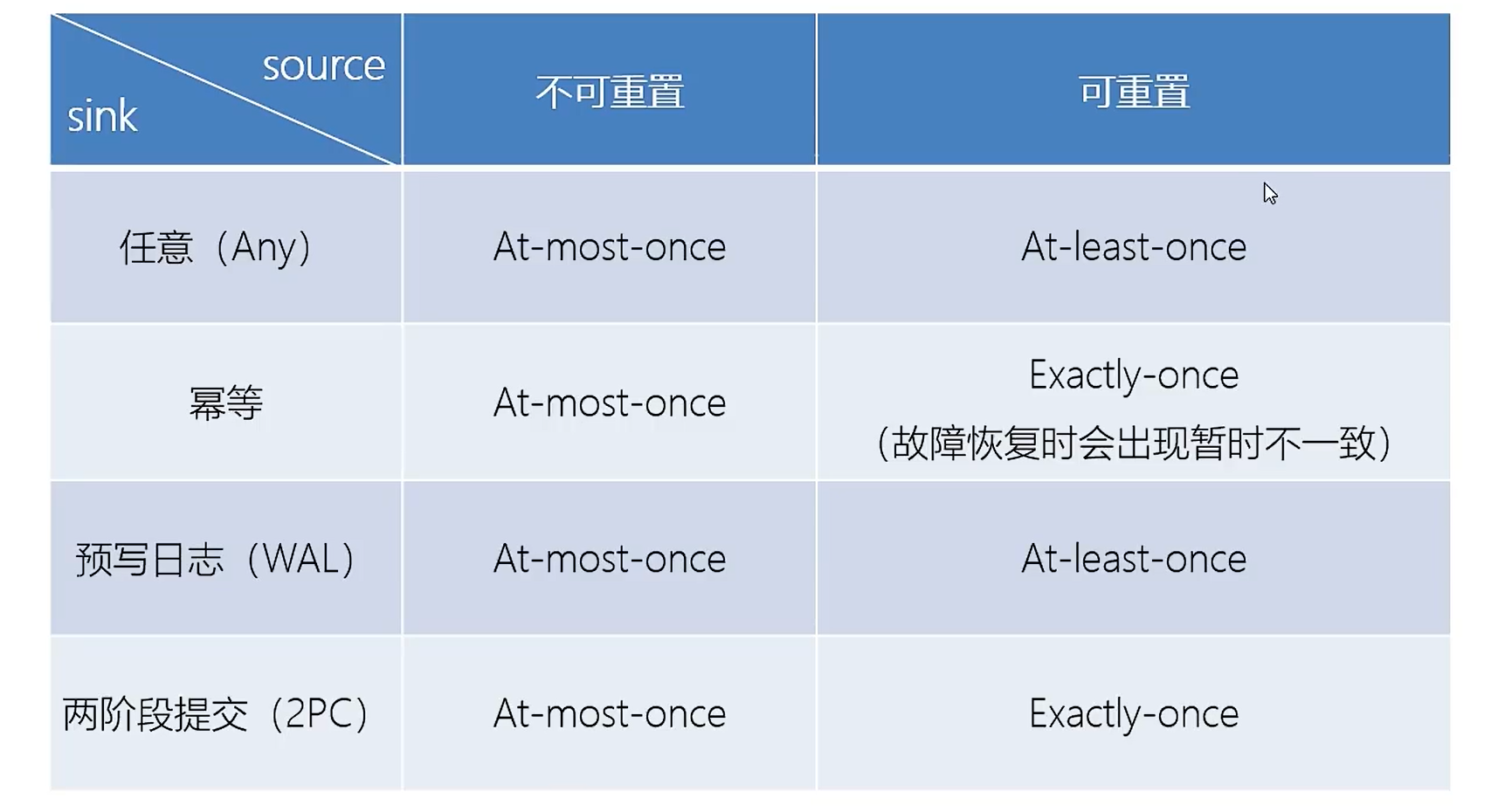

如果保存检查点之后又处理了一些数据,然后发生了故障,那么重启恢复状态之后,这些数据带来的状态改变会丢失,为了最终处理结果的正确,要求数据源具有重新读取的功能,例如kafka,这样就可以是按至少一次的状态一致性的保证,如果想要实现精确一次的一致性,那么还需要数据写入外部系统的保证。默认情况下,检查点是被金庸的,需要手动开启。

```java

executionEnvironment.enableCheckpointing(1000);

```

source code:

```java

/**

* Enables checkpointing for the streaming job. The distributed state of the streaming dataflow

* will be periodically snapshotted. In case of a failure, the streaming dataflow will be

* restarted from the latest completed checkpoint. This method selects {@link

* CheckpointingMode#EXACTLY_ONCE} guarantees.

*

* The job draws checkpoints periodically, in the default interval. The state will be stored

* in the configured state backend.

*

*

NOTE: Checkpointing iterative streaming dataflows in not properly supported at the moment.

* For that reason, iterative jobs will not be started if used with enabled checkpointing. To

* override this mechanism, use the {@link #enableCheckpointing(long, CheckpointingMode,

* boolean)} method.

*

* @deprecated Use {@link #enableCheckpointing(long)} instead.

*/

@Deprecated

@PublicEvolving

public StreamExecutionEnvironment enableCheckpointing() {

checkpointCfg.setCheckpointInterval(500);

return this;

}

```

##### 8.2.2 状态后端--State backends

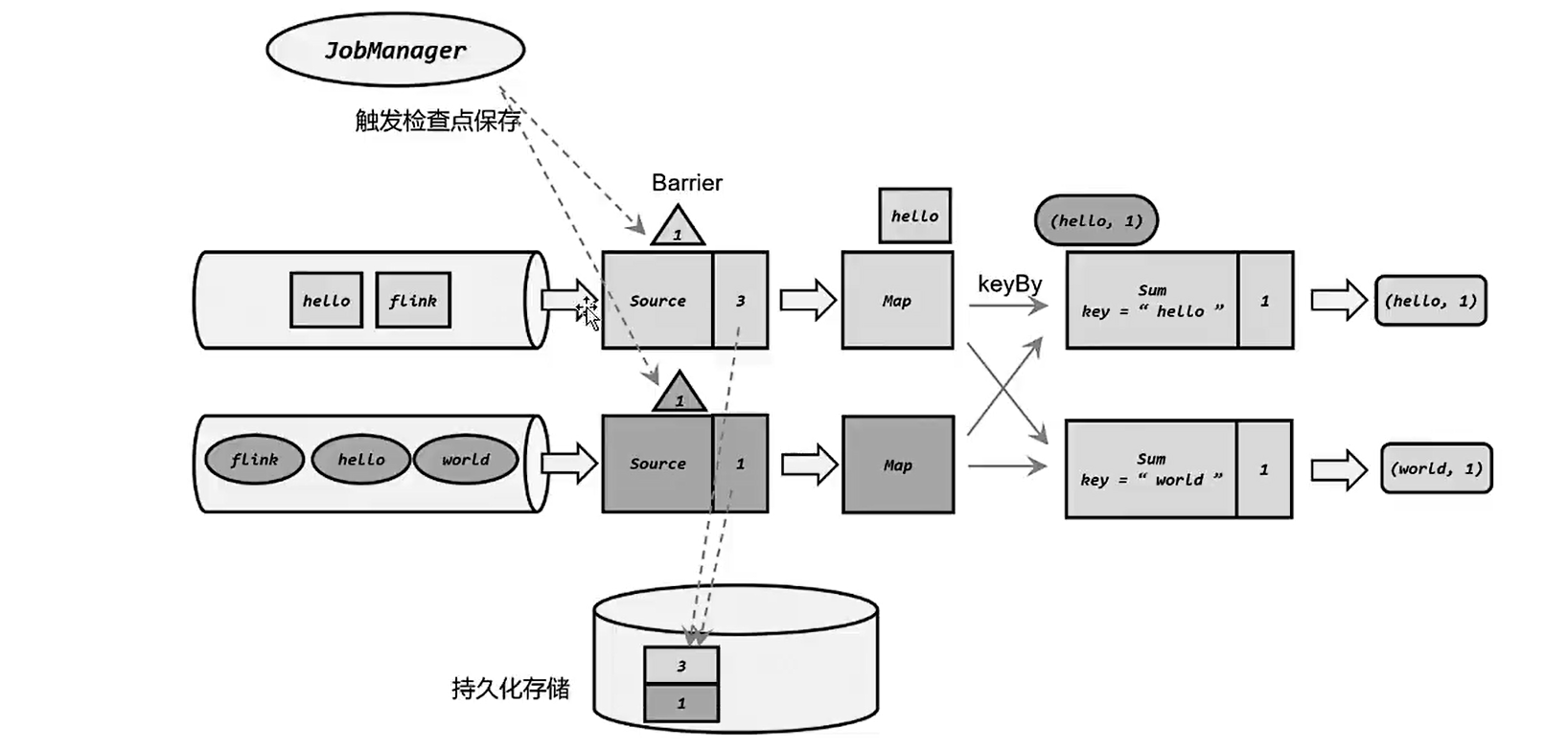

检查点保存依赖于JobManager和TaskManager以及外部存储系统的协调。在应用进行检查点保存时,首先会由JobManager向TaskManager发出触发检查点的命令,TaskManager收到之后,会将当前任务的所有状态进行快照保存,持久化到远程的存储介质中,完成之后向JobManager返回确认信息,当所有的TaskManager向JobManager返回确认信息之后,那么JobManager就会确认当前检查保存成功。在Flink中这一切就交给状态后端来处理。在Flink中状态后端被用来处理以下事情:

- 本地的状态管理。

- 将检查点写入远程的持久化存储。

状态后端被设定为开箱即用的组件,可以在不改变应用程序逻辑的情况下独立配置,Flink提供了两类不同的状态后端:

- 哈希表状态后端:HashMapStateBackend,默认的状态后端。将状态当作对象保存在TaskManager的JVM堆内存上,底层是一个哈希表,都会以键值对的方式存储起来。

- RocksDb状态后端:RockDb也是一种内嵌的Key-value存储介质,可以见数据持久化到本地磁盘。配置之后,会将处理中数据全部放到RocksDB数据库中,RocksDB默认存储在TaskManager的本地数据目录中。数据被村委序列化的字节数组,读写操作需要序列化/反序列化,因此状态的访问性能要差一些,key的比较也是按照字节进行的。对于检查点,是中执行的是异步快照,因此不会因为保存检查点而阻塞数据的处理,而且提供了增量式保存检查点的机制,可以提升保存的效率。状态非常大,窗口非常长的应用常见是一个很好选择,同样对于所有高可用性设置有效。

如何配置?

1)配置`flink-conf.yaml`的方式

```yaml

# 默认的状态后端:hashmap

state.backend: hashmap

#state.backend: rocksdb

# 检查点的文件路径

state.checkpoints.dir: hdfs://namenode:40010/flink/checkpoint

```

2)为每个job单独配置状态后端

```java

executionEnvironment.setStateBackend(new HashMapStateBackend());

```

使用:rocksdb

```xml

org.apache.flink

flink-statebackend-rocksdb_${scala.binary.version}

${flink.version}

```

```java

executionEnvironment.setStateBackend(new EmbeddedRocksDBStateBackend());

```

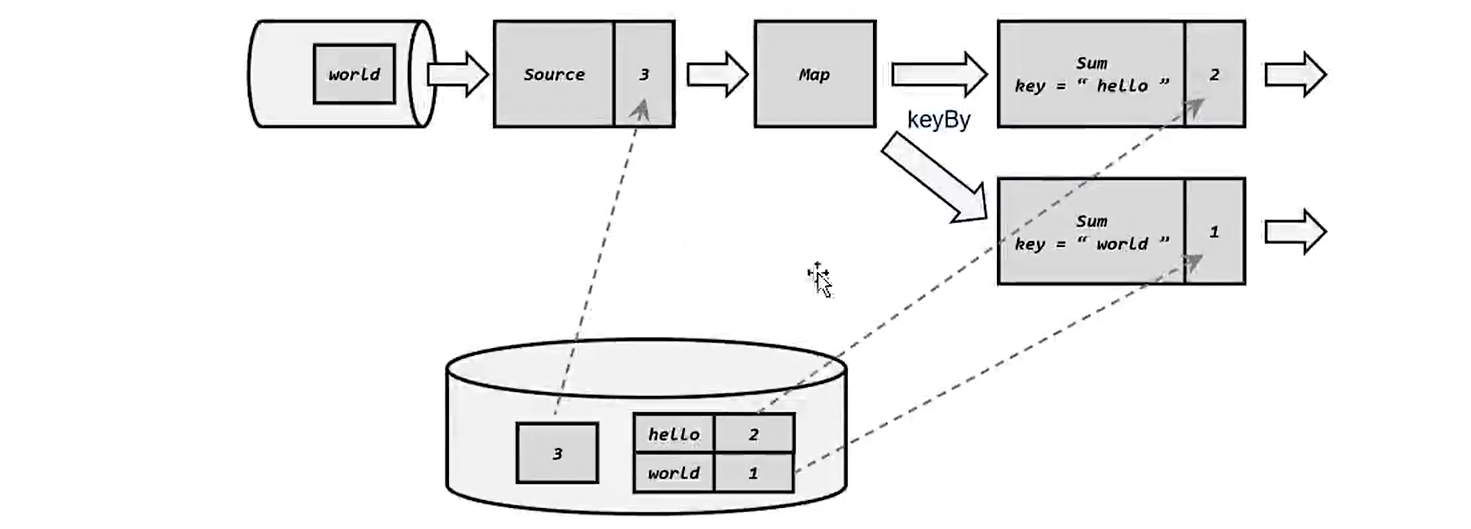

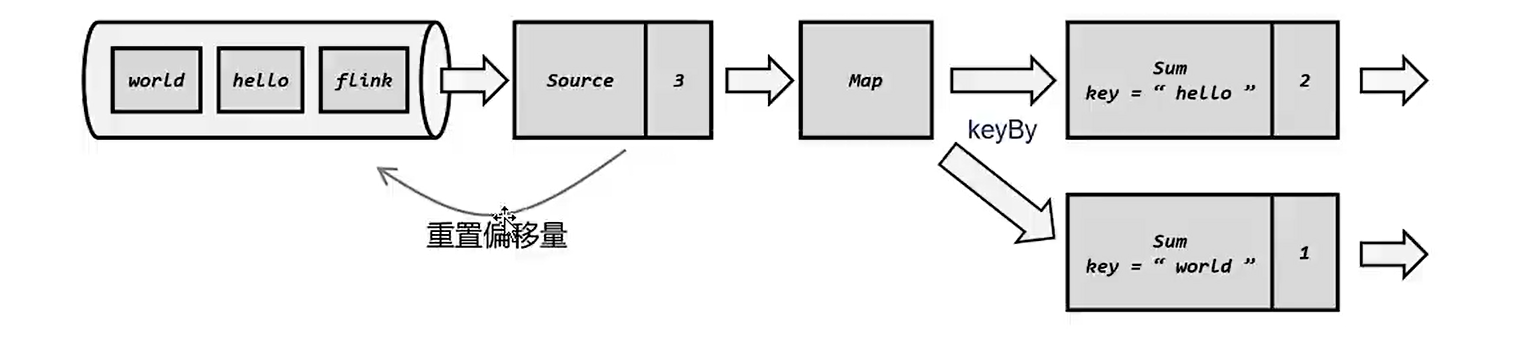

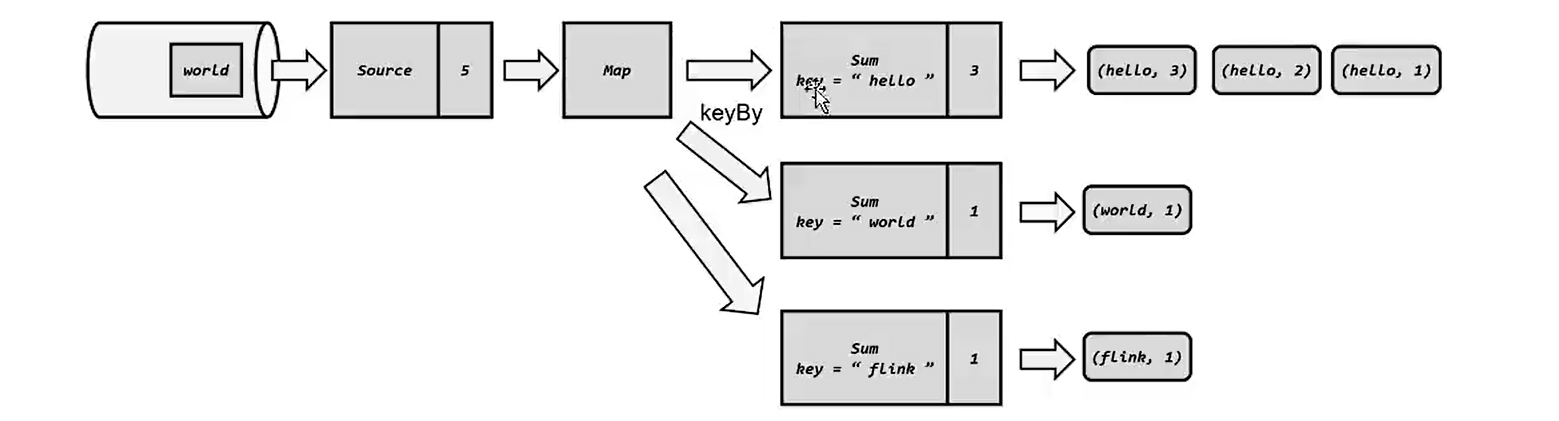

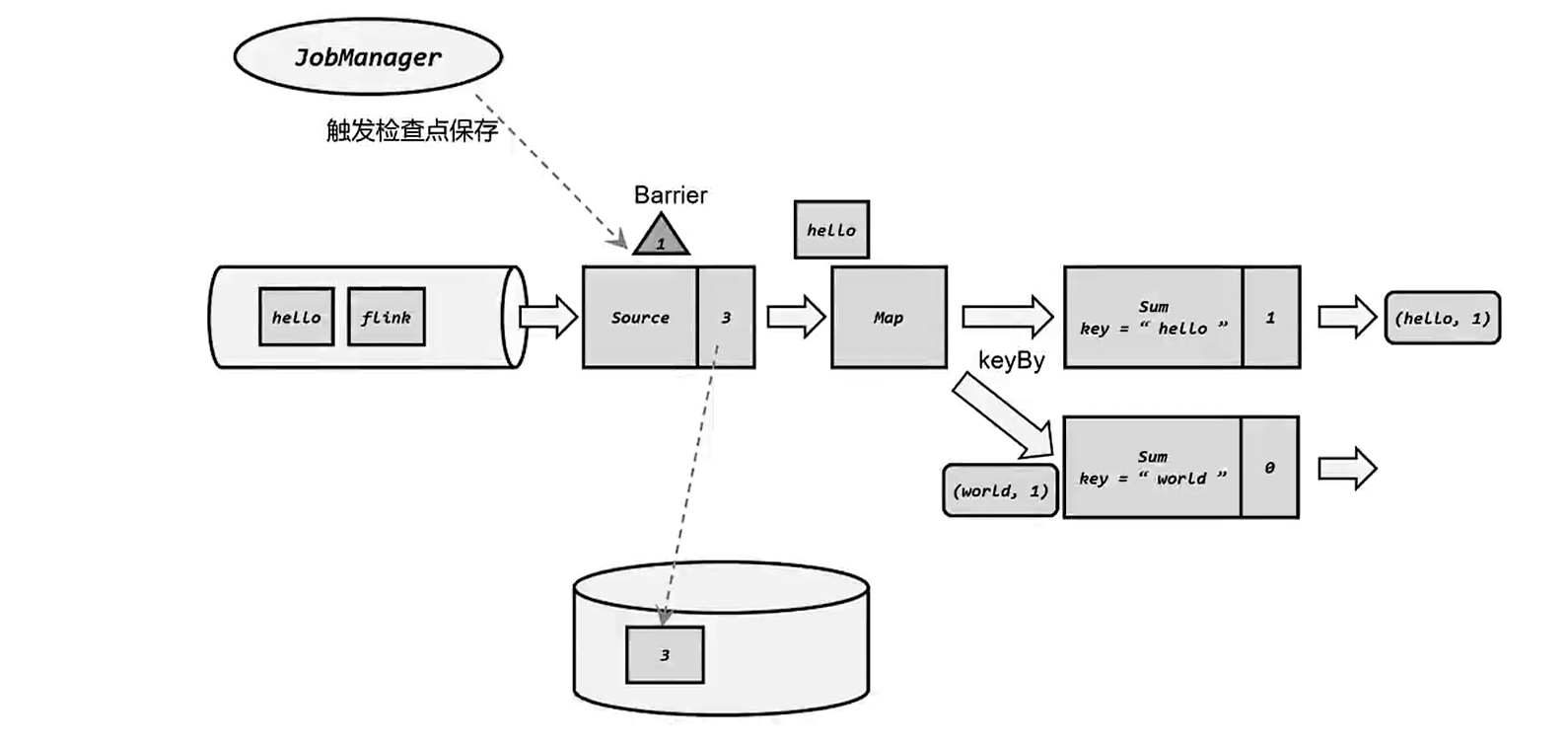

### 9 容错机制

> 流式处理程序是持续运行的,没有一个明确的退出时间,如果发生故障了怎么办呢?最简单的方式就是重启机器/应用,而分布式状态需要保存下来才可以实现故障恢复。