diff --git a/product/zh/docs-mogdb-stack/v3.0/architecture/backuping.md b/product/zh/docs-mogdb-stack/v3.0/architecture/backuping.md

new file mode 100644

index 0000000000000000000000000000000000000000..1e499692cc5eb3791896d260d0d28db62120d94b

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/architecture/backuping.md

@@ -0,0 +1,71 @@

+---

+title: 高可用架构

+summary: 高可用架构

+author: Ji Yabin

+date: 2023-07-04

+---

+

+## 备份管理

+

+MogDB Stack使用Mogdb内置的工具集执行备份和恢复功能,支持物理备份、逻辑备份,分别适用于不同的应用场景。最小化集群安装模式下,集群备份功能默认未开启,如果后续需要开启此功能,可以向系统提交相关配置yaml,即可实时开启备份功能。

+

+MogDB Stack提供了备份的保留期限,用户可根据实际的业务需求,配置保留的必要备份集数量,节省远程存储的使用空间。

+

+支持手动备份和周期性备份模式:

+

+- 手动备份:可以指定单次的备份,系统对于备份仅执行一次,如果需要再次执行,需要重置备份id。

+- 周期性备份:提供与crontab一致的时间描述方式,系统会根据配置,周期性调度备份任务。

+

+同时,支持两种不同的备份方式:

+

+- 物理备份:备份文件以物理页的形式存放,这种备份方式一般速度较快,但只能导入同版本数据库。

+- 逻辑备份:备份文件以SQL命令形式的存放,一般可用于跨版本数据库的数据导入。

+

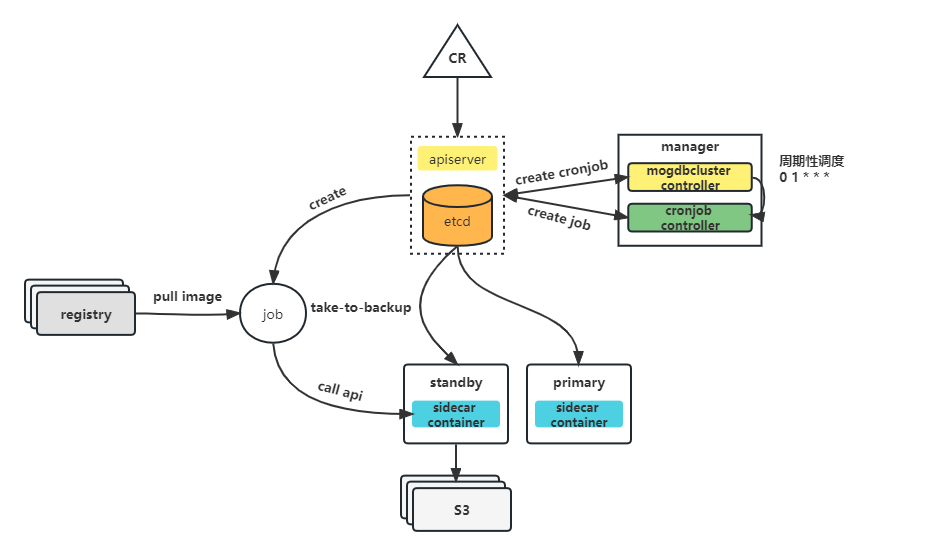

+以下是备份的架构图:

+

+

+

+其中:

+

+- CR: 备份配置作为mogdbcluster的一个配置项,用户只需要提供对应的字段,并提交到k8s系统,即可生效。

+- mogdbcluster controller: mogdbcluster控制器捕获到配置变更,触发备份相关的处理流。

+- cronjob controller:Kubernetes平台标准的控制器,用于周期性任务的调度。

+- job:实际执行备份的任务资源,会包含备份相关的程序,执行具体的备份任务。

+- s3:备份转储的外部存储。

+

+## 恢复

+

+恢复是MogDB Stack重要的功能模块,负责MogDB集群的可靠性。它通过读取远程存储的备份集数据,恢复出满足业务需求的完整数据库。

+

+恢复的应用场景:

+

+- 数据误删除

+- 数据错乱

+- 数据迁移

+- 集群克隆

+

+MogDB Stack支持两种恢复模式:

+

+- 基于文件的恢复

+- 基于PITR的恢复

+

+## 远程存储

+

+MogDB Stack支持常见的远程存储,用于转储备份文件:

+

+- Amazon S3

+- Minio

+- Google Cloud Storage

+- Google Drive

+- Google Photos

+- HDFS

+- Ceph

+- FTP

+- OpenStack Swift

+- QingStor

+- Qiniu Cloud Object Storage (Kodo)

+- SFTP

+- Tencent Cloud Object Storage (COS)

+- etc.

+

+以上列出的远程存储,只是常见的部分存储,完整的存储支持列表,请参考[Rclone官方文档](https://rclone.org/#providers)

\ No newline at end of file

diff --git a/product/zh/docs-mogdb-stack/v3.0/architecture/high-availability.md b/product/zh/docs-mogdb-stack/v3.0/architecture/high-availability.md

new file mode 100644

index 0000000000000000000000000000000000000000..44a22ff964e2e3ab5550b9c6f202ae3b4582c92a

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/architecture/high-availability.md

@@ -0,0 +1,37 @@

+---

+title: 高可用架构

+summary: 高可用架构

+author: Ji Yabin

+date: 2023-07-04

+---

+

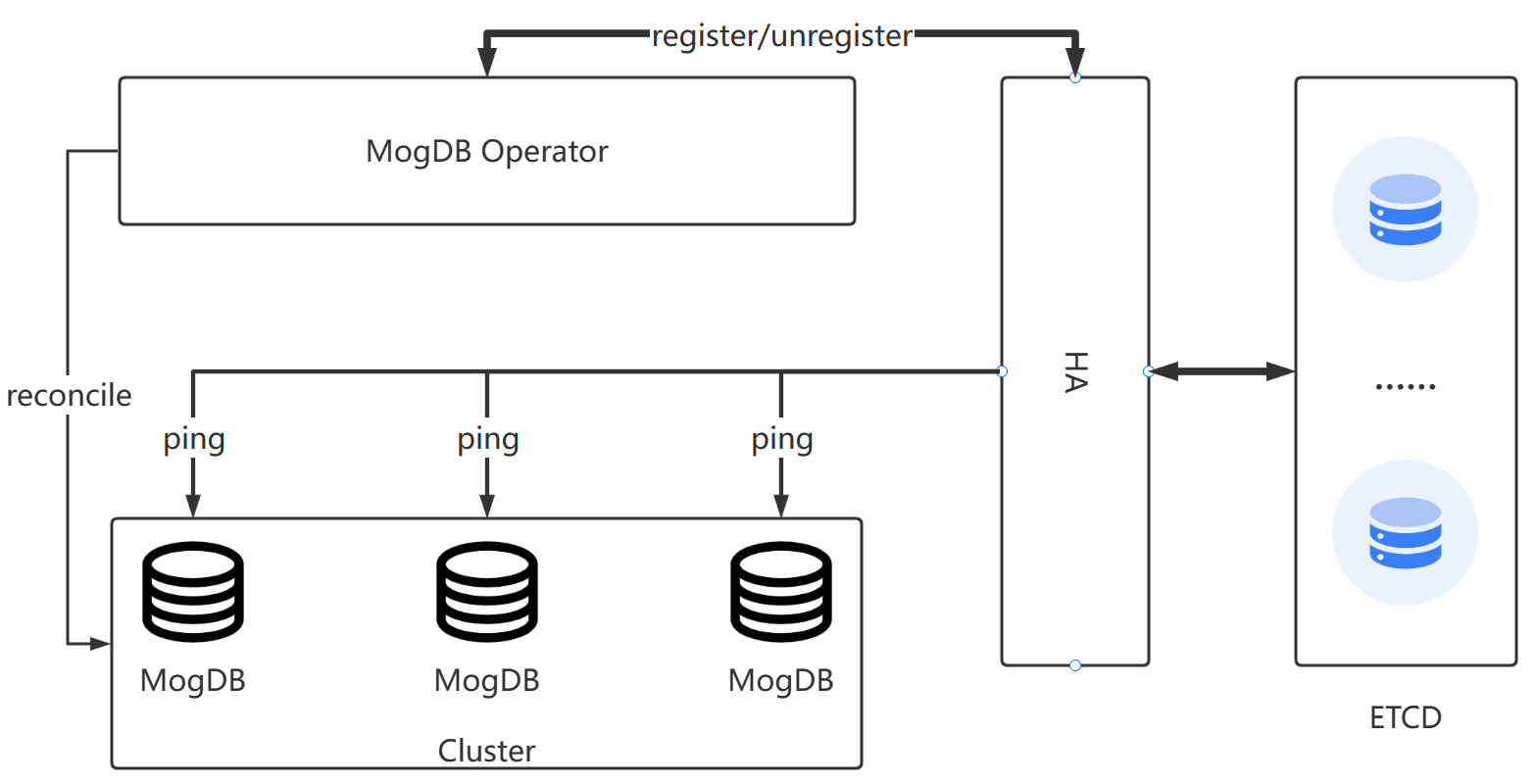

+高可用是 MogDB Stack 体系中的一个功能组件,以哨兵模式运行,提供命令行管理工具。支持以下功能:

+

+- 故障检测:

+

+ 通过向MogDB写入心跳表,并周期性更新心跳信息,探测MogDB存活状态。提供了三种心跳状态,可读、可写、可执行。

+

+- 故障转移:

+

+ 当检测到主库出现故障,并且持续了一段时间,系统会触发切换逻辑,通过选取最优的候选节点,提升为主库,完成故障切换。

+

+- 故障修复:

+

+ 当备库出现复制链路异常,系统会尝试修复复制状态,也会build数据,重新建立复制关系。

+

+发生切换的场景包括:

+

+- 机架掉电

+- 主库网络不可达

+- 数据库发生故障宕机

+- 数据库磁盘故障或者某些硬件故障

+

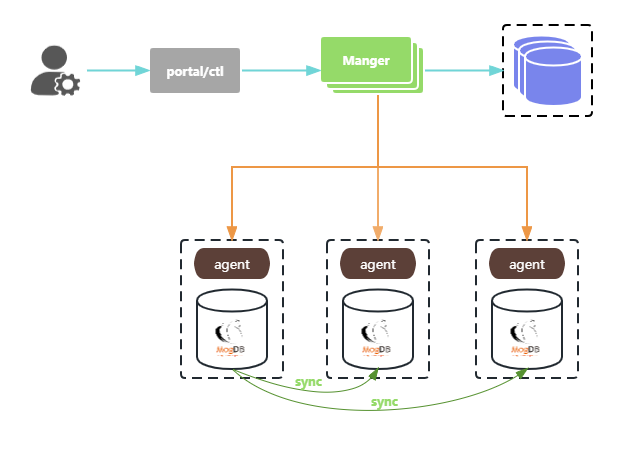

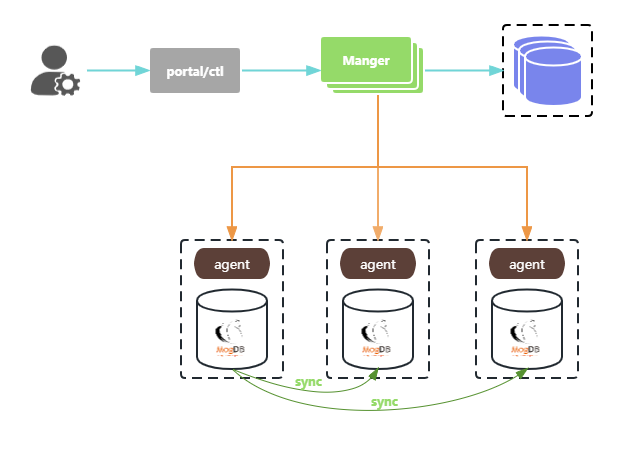

+以下是高可用的架构图:

+

+ +

+包含以下功能组件:

+

+- agent: 负责上报心跳信息,以及执行manager下发的的任务。

+- Manager: 系统的控制中心,负责心跳信息的分析决策,执行故障转移。

+- portal/ctl: 系统的入口,用户通过命令行或web界面发送任务,任务最终传递到Manager中,由Manager负责任务的管理。

diff --git a/product/zh/docs-mogdb-stack/v3.0/architecture/monitoring.md b/product/zh/docs-mogdb-stack/v3.0/architecture/monitoring.md

new file mode 100644

index 0000000000000000000000000000000000000000..9350996080f86b911a0ff9413fe80b5da399fdee

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/architecture/monitoring.md

@@ -0,0 +1,109 @@

+---

+title: 监控

+summary: 监控

+author: Ji Yabin, hhhhhzhen

+date: 2023-07-22

+

+---

+

+# 监控与告警

+

+本文介绍如何对 Kubernetes 集群进行监控。在 MogDB 集群运行的过程中,需要对容器资源、宿主机、Kubernetes 组件等进行监控。对于这些组件或资源的监控,需要在整个 Kubernetes 集群维度部署监控系统来实现。

+

+

+

+包含以下功能组件:

+

+- agent: 负责上报心跳信息,以及执行manager下发的的任务。

+- Manager: 系统的控制中心,负责心跳信息的分析决策,执行故障转移。

+- portal/ctl: 系统的入口,用户通过命令行或web界面发送任务,任务最终传递到Manager中,由Manager负责任务的管理。

diff --git a/product/zh/docs-mogdb-stack/v3.0/architecture/monitoring.md b/product/zh/docs-mogdb-stack/v3.0/architecture/monitoring.md

new file mode 100644

index 0000000000000000000000000000000000000000..9350996080f86b911a0ff9413fe80b5da399fdee

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/architecture/monitoring.md

@@ -0,0 +1,109 @@

+---

+title: 监控

+summary: 监控

+author: Ji Yabin, hhhhhzhen

+date: 2023-07-22

+

+---

+

+# 监控与告警

+

+本文介绍如何对 Kubernetes 集群进行监控。在 MogDB 集群运行的过程中,需要对容器资源、宿主机、Kubernetes 组件等进行监控。对于这些组件或资源的监控,需要在整个 Kubernetes 集群维度部署监控系统来实现。

+

+

+

+## 架构

+

+监控告警共包含四个维度:

+

+- 宿主机指标

+- 容器指标

+- Kubernetes 资源状态

+- MogDB 集群状态

+

+

+

+## 宿主机监控

+

+通过 node exporter 对物理机指标进行采集,统一抓取到 prometheus 中。Node Exporter 是 Prometheus 官方提供的一个节点资源采集组件,可以用于收集服务器节点的数据,如 CPU 频率信息、磁盘 IO 统计、剩余可用内存等等。Node Exporter 会将收集到的信息转换为 Prometheus 可识别的 Metrics 数据。Prometheus 可以从 Node Exporter 中对这些指标进行收集与存储,并且可以根据这些数据的实时变化进行服务器节点资源监控。

+

+

+

+## 容器监控

+

+cAdvisor 是 Google 开源的容器资源监控和性能分析工具,它是专门为容器而生,在 Kubernetes 中,我们不需要单独去安装,cAdvisor 作为 kubelet 内置的一部分程序可以直接使用,也就是我们可以直接使用 cAdvisor 采集数据,可以采集到和容器运行相关的所有指标。

+

+cadvisor 中获取到的典型监控指标如下:

+

+| 指标名称 | 类型 | 含义 |

+| -------------------------------------- | ------- | -------------------------------------------- |

+| container_cpu_load_average_10s | gauge | 过去10秒容器CPU的平均负载 |

+| container_cpu_usage_seconds_total | counter | 容器在每个CPU内核上的累积占用时间 (单位:秒) |

+| container_cpu_system_seconds_total | counter | System CPU累积占用时间(单位:秒) |

+| container_cpu_user_seconds_total | counter | User CPU累积占用时间(单位:秒) |

+| container_fs_usage_bytes | gauge | 容器中文件系统的使用量(单位:字节) |

+| container_fs_limit_bytes | gauge | 容器可以使用的文件系统总量(单位:字节) |

+| container_fs_reads_bytes_total | counter | 容器累积读取数据的总量(单位:字节) |

+| container_fs_writes_bytes_total | counter | 容器累积写入数据的总量(单位:字节) |

+| container_memory_max_usage_bytes | gauge | 容器的最大内存使用量(单位:字节) |

+| container_memory_usage_bytes | gauge | 容器当前的内存使用量(单位:字节) |

+| container_spec_memory_limit_bytes | gauge | 容器的内存使用量限制 |

+| machine_memory_bytes | gauge | 当前主机的内存总量 |

+| container_network_receive_bytes_total | counter | 容器网络累积接收数据总量(单位:字节) |

+| container_network_transmit_bytes_total | counter | 容器网络累积传输数据总量(单位:字节) |

+

+

+

+## 资源对象监控

+

+kube-state-metrics 提供资源对象本身的监控,如 pod 运行状态、有多少 job 在运行中等等,它基于 client-go 开发,轮询 Kubernetes API,并将 Kubernetes 的结构化信息转换为 metrics。

+

+指标类别包括:

+

+- CronJob Metrics

+

+- DaemonSet Metrics

+

+- Deployment Metrics

+

+- Job Metrics

+

+- LimitRange Metrics

+

+- Node Metrics

+

+- PersistentVolume Metrics

+

+- PersistentVolumeClaim Metrics

+

+- Pod Metrics

+

+- Pod Disruption Budget Metrics

+

+- ReplicaSet Metrics

+

+- ReplicationController Metrics

+

+- ResourceQuota Metrics

+

+- Service Metrics

+

+- StatefulSet Metrics

+

+- Namespace Metrics

+

+- Horizontal Pod Autoscaler Metrics

+

+- Endpoint Metrics

+

+- Secret Metrics

+

+- ConfigMap Metrics

+

+

+

+## MogDB 监控

+

+为了获取 MogDB 自身的监控指标,需要配套的 MogDB exporter 采集相应的数据。

+

+

\ No newline at end of file

diff --git a/product/zh/docs-mogdb-stack/v3.0/architecture/overview.md b/product/zh/docs-mogdb-stack/v3.0/architecture/overview.md

new file mode 100644

index 0000000000000000000000000000000000000000..537aeaaab99ffc058fbd9015948c43d8be5de6f8

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/architecture/overview.md

@@ -0,0 +1,49 @@

+---

+title: MogDB Stack 架构

+summary: MogDB Stack 架构

+author: Ji Yabin

+date: 2023-07-04

+---

+

+# 架构

+

+MogDB Stack提供了两种模式,分别是单机群模式和多集群模式。单机群模式适用于单一的Kubernetes集群,在整个Kubernetes内实现MogDB集群的生命周期管理,多集群模式提供了一种跨Kubernetes/机房的方案,满足用户对于跨机房的容灾要求。

+

+## 单集群模式

+

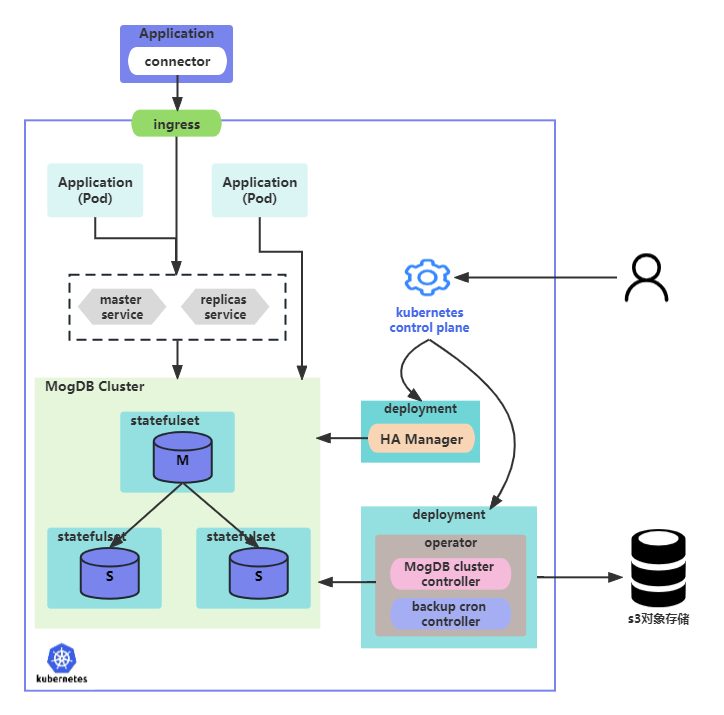

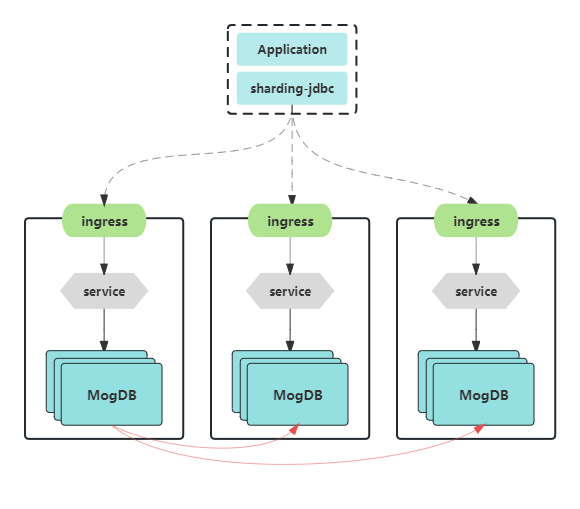

+单机群模式,一般指MogDB Stack所有组件部署在一套Kubernetes集群内,完成整个生命周期管理。以下是单机群模式的架构图:

+

+

+

+包含以下功能组件:

+

+- connector: 应用层连接数据库的api,如sharding-jdbc。

+- ingress: 外部应用访问Kubernetes内部服务的入口,提供四层、七层转发。

+- master service: Kubernetes内部读写服务,数据库的读写流量通过此service转发。

+- replicas service: Kubernetes内部只读服务,数据库的只读流量通过此service转发,具备负载均衡的能力。

+- MogDB Cluster: 运行在Kubernetes中的MogDB集群,以主备模式运行多个副本。

+- HA Manager: 高可用组件,负责MogDB的故障探测、故障转移。

+- operator: 集群生命周期管理模块,负责集群资源申请、回收、扩缩容等。

+

+## 多集群模式

+

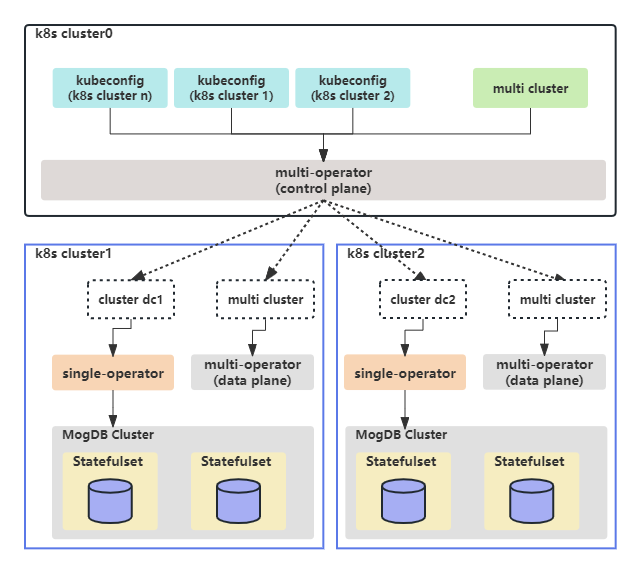

+多集群模式,一般应用在多中心场景下,不同的数据中心运行着不同的Kubernetes集群,MogDB Cluster需要跨越数据中心部署。以下是多集群模式的架构图:

+

+

+

+包含以下资源对象:

+

+- kubeconfig: Kubernetes的证书、权限等配置。

+- multi cluster: 用于描述用户期望的多集群/多中心的配置。

+

+包含以下功能组件:

+

+- multi-operator: 多集群管理控制器,负责下发集群到各个数据中心。

+- single-operator: 单集群管理控制器,负责单一Kubernetes集群的MogDB Cluster生命周期管理。

+- MogDB Cluster: MogDB集群,多副本运行,其中每个节点以statefulset负载运行。

+

+业务应用通过ingress入口转发到后端实际的数据库集群,具体流程架构图如下:

+

+

+

+业务应用通过sharding-jdbc访问各个数据中心的后端数据库,sharding-jdbc支持配置多条访问链路,自动探测最新的主库路径。

diff --git a/product/zh/docs-mogdb-stack/v3.0/faq.md b/product/zh/docs-mogdb-stack/v3.0/faq.md

new file mode 100644

index 0000000000000000000000000000000000000000..e69de29bb2d1d6434b8b29ae775ad8c2e48c5391

diff --git a/product/zh/docs-mogdb-stack/v3.0/installation/multi-helm.md b/product/zh/docs-mogdb-stack/v3.0/installation/multi-helm.md

new file mode 100644

index 0000000000000000000000000000000000000000..d3e885d2a7ec46d06ed1f4c1b2856955aa5c7502

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/installation/multi-helm.md

@@ -0,0 +1,720 @@

+---

+date: 2023-06-30

+author: houzhen.su

+title: 使用 helm 安装(多集群模式)

+summary: 使用 helm 安装(多集群模式)

+---

+

+# 使用 helm 安装(多集群模式)

+

+本节提供了使用 helm 安装和配置 mogdb-stack `多 kubernetes 集群模式`的说明。

+

+

+

+## 术语

+

+提前了解以下术语将有助于您阅读本文档。

+

+- 数据平面:数据层,mogdb 真实存在的位置;

+- 数据中心:每个数据平面被称为一个数据中心;

+- 控制平面:控制层,用于控制 mogdb 在多个数据中心上的分配逻辑;

+

+注意:控制平面、数据平面、数据中心均为逻辑概念。实际上,控制平面和数据平面出现在同一 kubernetes 集群中是被允许的,多个数据平面也可以同时出现在一个 kubernetes 集群中。**在生产环境中我们推荐将控制平面、数据平面分开部署。**

+

+

+

+## 前置条件

+

+- 已准备一个控制平面

+- 已准备至少一个数据平面

+- 各平面之间 kubernetes 网络已互通

+- 已安装 [helm](https://helm.sh),具体请参考

+- 添加 [enmotech helm 发布仓](https://github.com/enmotech/charts)

+

+```shell

+helm repo add enmotech https://enmotech.github.io/charts

+```

+

+ 期望输出:

+

+```shell

+$ helm repo add enmotech https://enmotech.github.io/charts

+"enmotech" has been added to your repositories

+

+$ helm search repo enmotech

+NAME CHART VERSION APP VERSION DESCRIPTION

+enmotech/mogha 3.0.0 3.0.0 Helm chart for deploying MogDB Ha on Kubernetes

+enmotech/mogdb-monitor 3.0.0 3.0.0 A Helm chart for Kubernetes

+enmotech/mogdb-cluster 3.0.0 3.0.0 Helm chart for deploying MogDB Cluster on Kubernetes

+enmotech/multi-cluster 3.0.0 3.0.0 Helm chart for deploying MogDB Multi Cluster on Kubernetes

+enmotech/mogdb-operator 3.0.0 3.0.0 Helm chart for deploying MogDB Operator on Kubernetes

+enmotech/multi-operator 3.0.0 3.0.0 Helm chart for deploying MogDB Multi Operator on Kubernetes

+```

+

+

+

+## 安装模式

+

+在安装 mogdb-stack 中的 mogdb-operator 与 multi-operator 组件时,可以配置其管理整个 kubernetes 集群的 mogdb 集群,或仅允许其管理单个 kubernetes 命名空间中的 mogdb 集群。

+

+在管理整个 kubernetes 集群的 mogdb 集群时,我们会创建 ClusterRole 与 ClusterRoleBinding。

+

+但是当仅允许其管理单个 kubernetes 命名空间中的 mogdb 集群时,我们则会创建 Role 与 RoleBinding。

+

+不论是集群模式还是命名空间模式,helm 都会自动帮助我们创建必须的资源。

+

+**默认情况下为集群模式,如果要使用命名空间模式,只需指定 `singleNamespace=true` 即可。**

+

+

+

+## 配置

+

+虽然默认的 helm chart 可以在大多数 kubernetes 环境中工作,但可能有必要根据您的特定需求进一步自定义。

+

+我们的 Helm charts 为您提供了丰富的可自定义选项,有关这些选项的具体信息,请参考[参考/helm-charts](../references/helm-charts)。

+

+

+

+## 控制平面安装

+

+**注意:只能同时存在一个控制平面。**

+

+在开始之前,确保您已将 kubectl 的当前上下文切换到控制平面:

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context control-plane

+Switched to context "control-plane".

+```

+

+

+

+### 1.安装 mogdb-ha

+

+**注意**:

+

+- mogdb-ha 组件是**必选的**;

+- 如果您要将其用于生产环境,确保您已准备了**高可用 etcd 集群**,我们会在在后续安装时传递相关信息。

+

+

+

+创建 namespace:

+

+```shell

+kubectl create namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl create namespace mogdb-ha

+namespace/mogdb-ha created

+```

+

+

+

+安装 mogdb-ha 组件,有关设置的详细信息说明请参考 [mogdb ha charts value](../references/charts/mogdb-ha):

+

+- 默认以**集群模式**安装 mogdb-ha:

+

+```shell

+helm install enmotech/mogdb-ha -n [--set =...]

+```

+

+ 期望输出(在本例中,关闭了 debug 日志,使用简化版 etcd,并设置 ha 容器的内存大小为 1Gi):

+

+```shell

+$ helm install mogdb-ha helm/mogdb-ha -n mogdb-ha \

+ --set debug=false \

+ --set withEtcd=true \

+ --set ha.resources.limits.memory=1Gi \

+ --set ha.resources.requests.memory=1Gi

+NAME: mogdb-ha

+LAST DEPLOYED: Tue Jul 4 13:58:13 2023

+NAMESPACE: mogdb-ha

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Ha!

+```

+

+

+

+- 要以**命名空间模式**安装 mogdb-ha,请指定 `--set singleNamespace=true`:

+

+```shell

+helm install enmotech/mogdb-ha -n --set singleNamespace=true [--set =...]

+```

+

+ 期望输出(在本例中,关闭了 debug 日志,使用简化版 etcd,并设置 ha 容器的内存大小为 1Gi):

+

+```shell

+$ helm install mogdb-ha helm/mogdb-ha -n mogdb-ha \

+ --set singleNamespace=true \

+ --set debug=false \

+ --set withEtcd=true \

+ --set ha.resources.limits.memory=1Gi \

+ --set ha.resources.requests.memory=1Gi

+NAME: mogdb-ha

+LAST DEPLOYED: Tue Jul 4 13:58:13 2023

+NAMESPACE: mogdb-ha

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Ha!

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n mogdb-ha

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-ha-58fb655887-59q8z 2/2 Running 0 71s

+

+NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

+service/mogdb-ha NodePort 10.96.7.215 6544/TCP 71s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-ha 1/1 1 1 71s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-ha-58fb655887 1 1 1 71s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+### 2.安装控制平面 multi-operator

+

+**注意**:multi-operator 组件是**必选的**;

+

+

+

+安装 CRD:

+

+**注意,在同一个 kubernetes 集群中,CRD 只需安装一次。**

+

+```shell

+kubectl apply --server-side -k kustomize/multi-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/multi-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io/kubeclientconfigs.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/multiclusters.mogdb.enmotech.io serverside-applied

+```

+

+

+

+创建 namespace:

+

+```shell

+kubectl create namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl create namespace control-plane

+namespace/control-plane created

+```

+

+

+

+安装 multi-operator,有关设置的详细信息说明请参考 [multi operator charts value](../references/charts/mmulti-operator):

+

+- 默认以**集群模式**安装 multi-operator:

+

+```shell

+helm install enmotech/multi-operator -n [--set =...]

+```

+

+ 期望输出:

+

+```shell

+$ helm install manager helm/multi-operator -n control-plane

+NAME: manager

+LAST DEPLOYED: Tue Jul 4 16:58:37 2023

+NAMESPACE: control-plane

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Multi Operator!

+```

+

+- 要以**命名空间模式**安装 multi-operator,请指定 `--set singleNamespace=true`,且指定ns为与context对应的namespace:

+

+```shell

+helm install enmotech/multi-operator -n --set singleNamespace=true [--set =...]

+```

+

+ 期望输出:

+

+```shell

+$ helm install manager helm/multi-operator --set singleNamespace=true -n control-plane

+NAME: manager

+LAST DEPLOYED: Tue Jul 4 16:58:37 2023

+NAMESPACE: control-plane

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Multi Operator!

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n control-plane

+NAME READY STATUS RESTARTS AGE

+pod/multi-operator-manager-758b65c869-bcnd7 1/1 Running 0 4s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/multi-operator-manager 1/1 1 1 4s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/multi-operator-manager-758b65c869 1 1 1 4s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+> 至此完成控制平面的安装。

+

+

+

+## 数据平面安装

+

+**注意:可以同时存在多个数据平面,如果您拥有多个数据平面,则只需切换至对应的上下文,并循环执行该小节。**

+

+**本小节以尾缀1代表数据平面1,其他数据平面可依次修改尾缀数字以区分不同数据平面**

+

+在开始之前,确保您已将 kubectl 的当前上下文切换到数据平面:

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context data-plane1

+Switched to context "data-plane1".

+```

+

+

+

+### 1.安装 mogdb-operator

+

+**注意**:mogdb-operator 组件是**必选的**;

+

+

+

+安装 CRD:

+

+**注意,在同一个 kubernetes 集群中,CRD 只需安装一次。**

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io/mogdbclusters.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/mogdbclustertemplates.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/mogdbpodtemplates.mogdb.enmotech.io serverside-applied

+```

+

+

+

+创建 namespace:

+

+```shell

+kubectl create namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl create namespace data-plane1

+namespace/data-plane1 created

+```

+

+

+

+安装 mogdb-operator,有关设置的详细信息说明请参考 [mogdb operator charts value](../references/charts/mogdb-operator):

+

+- 默认以**集群模式**安装 mogdb-operator:

+

+```shell

+helm install enmotech/mogdb-operator -n [--set =...]#在不同数据平面应使用不同名字,可以加后缀数字来区分

+```

+

+ 期望输出:

+

+```shell

+$ helm install manager1 helm/mogdb-operator -n data-plane1

+NAME: manager1

+LAST DEPLOYED: Tue Jul 4 17:14:17 2023

+NAMESPACE: data-plane1

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Operator!

+```

+

+- 要以**命名空间模式**安装 mogdb-operator,请指定 `--set singleNamespace=true`:

+

+```shell

+helm install enmotech/mogdb-operator -n --set singleNamespace=true [--set =...]

+```

+

+ 期望输出:

+

+```shell

+$ helm install manager1 helm/mogdb-operator --set singleNamespace=true -n data-plane1

+NAME: manager1

+LAST DEPLOYED: Tue Jul 4 17:14:17 2023

+NAMESPACE: data-plane1

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Operator!

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n data-plane1

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-operator-manager-68f7f7cb48-zbmfq 1/1 Running 0 47s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-operator-manager 1/1 1 1 47s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-operator-manager-68f7f7cb48 1 1 1 47s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+### 2.注册数据平面到控制平面

+

+我们提供了注册到数据平面的脚本供您使用,其中--src相关的值与您使用的安装模式的context及namespace相关,请注意修改:

+

+```shell

+./join-to-control-plane.sh \

+--output-dir ./build \

+--src-kubeconfig ~/.kube/config \

+--src-context data-plane1 \

+--src-namespace data-plane1 \

+--src-serviceaccount mogdb-operator-controller-manager \

+--dest-kubeconfig ~/.kube/config \

+--dest-context control-plane \

+--dest-namespace control-plane

+```

+

+其中各选项的含义如下:

+

+- --output-dir:脚本运行过程中生成文件的存放路径;

+- --src-context:数据平面上下文,在本例中为 data-plane1;

+- --src-kubeconfig:数据平面 kubeconfig 路径,在本例中为 ~/.kube/config;

+- --src-namespace:数据平面所在命名空间,在本例中为 data-plane1;

+- --src-serviceaccount:数据平面的 serviceaccount,用于控制控制平面对数据平面访问的权限,在本例中为 mogdb-operator-controller-manager;

+-

+- --dest-context:控制平面上下文,在本例中为 control-plane;

+- --dest-kubeconfig:控制平面 kubeconfig 路径,在本例中为 ~/.kube/config;

+- --dest-namespace:控制平面所在命名空间,在本例中为 control-plane;

+

+期望输出:

+

+```shell

+$ ./join-to-control-plane.sh \

+--output-dir ./build \

+--src-kubeconfig ~/.kube/config \

+--src-context data-plane1 \

+--src-namespace data-plane1 \

+--src-serviceaccount mogdb-operator-controller-manager \

+--dest-kubeconfig ~/.kube/config \

+--dest-context control-plane \

+--dest-namespace control-plane

+

+Source cluster had localhost as the API server address; replacing with https://172.19.0.6:6443

+Creating KubeConfig at ./build/kubeconfig

+Creating secret data-plane1

+Error from server (NotFound): secrets "data-plane1" not found

+secret/data-plane1 created

+Creating ClientConfig ./build/data-plane1.yaml

+kubeclientconfig.mogdb.enmotech.io/data-plane1 created

+```

+

+

+

+### 3.安装multi-cluster

+

+```shell

+helm install enmotech/multi-cluster -n --set enableControl=false [--set =...]

+```

+

+ 期望输出:

+

+```shell

+$ helm install multi-cluster helm/multi-cluster --set enableControl=false -n control-plane

+NAME: multi-cluster

+LAST DEPLOYED: Sat Jul 29 08:24:33 2023

+NAMESPACE: control-plane

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Multi Cluster!

+```

+

+

+

+> 至此完成数据平面的安装。

+

+

+

+## 卸载

+

+### 1.卸载数据平面组件

+

+> 首先确保要卸载的数据平面上已无 mogdb 集群残留。

+

+**卸载 multi-cluster**

+

+```shell

+helm uninstall -n

+```

+

+期望输出:

+

+```shell

+$ helm uninstall multi-cluster -n control-plane

+release "multi-cluster" uninstalled

+```

+

+> 如果您拥有多个数据平面,则只需切换至对应的上下文,并循环执行该小节。

+

+**切换到控制平面**

+

+解注册需要在控制平面进行,因此需要先切换到控制平面。

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context control-plane

+Switched to context "control-plane".

+```

+

+

+

+**解注册**

+

+```shell

+kubectl delete kubeclientconfig.mogdb.enmotech.io/ -n

+```

+

+期望输出:

+

+```shell

+$ kubectl delete kubeclientconfig.mogdb.enmotech.io/data-plane1 -n mogdb-operator-system

+kubeclientconfig.mogdb.enmotech.io "data-plane1" deleted

+```

+

+

+

+**切换到数据平面**

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context data-plane1

+Switched to context "data-plane1".

+```

+

+

+

+**卸载 mogdb-operator**

+

+```shell

+helm uninstall -n

+```

+

+期望输出:

+

+```shell

+$ helm uninstall manager1 -n data-plane1

+release "manager1" uninstalled

+```

+

+

+

+**卸载 CRD**

+

+```shell

+kubectl delete -k kustomize/mogdb-operator/bases/crd

+kubectl delete -k kustomize/multi-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/mogdb-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io "mogdbclusters.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "mogdbclustertemplates.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "mogdbpodtemplates.mogdb.enmotech.io" deleted

+

+$ kubectl delete -k kustomize/multi-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io "kubeclientconfigs.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "multiclusters.mogdb.enmotech.io" deleted

+```

+

+

+

+**删除命名空间**

+

+```shell

+kubectl delete namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl delete namespace data-plane1

+namespace "data-plane1" deleted

+```

+

+

+

+### 2.卸载控制平面组件

+

+> 首先确保要卸载的控制平面上已无 mogdb 集群残留。

+

+**切换到控制平面**

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context control-plane

+Switched to context "control-plane".

+```

+

+

+

+**卸载 mogdb-ha**

+

+```shell

+helm uninstall -n

+```

+

+期望输出:

+

+```shell

+$ helm uninstall mogdb-ha -n mogdb-ha

+release "mogdb-ha" uninstalled

+```

+

+

+

+**卸载 multi-operator**

+

+```shell

+helm uninstall -n

+```

+

+期望输出:

+

+```shell

+$ helm uninstall manager -n control-plane

+release "manager" uninstalled

+```

+

+

+

+**卸载 CRD**

+

+```shell

+kubectl delete -k kustomize/multi-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/multi-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io "kubeclientconfigs.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "multiclusters.mogdb.enmotech.io" deleted

+```

+

+

+

+**删除命名空间**

+

+```shell

+kubectl delete namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl delete namespace mogdb-ha

+namespace "mogdb-ha" deleted

+

+$ kubectl delete namespace control-plane

+namespace "control-plane" deleted

+```

diff --git a/product/zh/docs-mogdb-stack/v3.0/installation/multi-kustomize.md b/product/zh/docs-mogdb-stack/v3.0/installation/multi-kustomize.md

new file mode 100644

index 0000000000000000000000000000000000000000..54f7e09d9d65e6c508178907204ef8b41f8ea796

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/installation/multi-kustomize.md

@@ -0,0 +1,784 @@

+---

+date: 2023-06-30

+author: houzhen.su

+title: 使用 kustomize 安装(多集群模式)

+summary: 使用 kustomize 安装(多集群模式)

+---

+

+# 使用 kustomize 安装(多集群模式)

+

+本节提供了使用 kustomize 安装和配置 mogdb-stack `多 kubernetes 集群模式`的说明。

+

+

+

+## 术语

+

+提前了解以下术语将有助于您阅读本文档。

+

+- 控制平面:控制层,

+- 数据平面:数据层,mogdb 真实存在的位置

+- 数据中心:每个数据平面被称为一个数据中心

+

+注意:控制平面、数据平面、数据中心均为逻辑概念。实际上,控制平面和数据平面出现在同一 kubernetes 集群中是被允许的,多个数据平面也可以同时出现在一个 kubernetes 集群中。**在生产环境中我们推荐将控制平面、数据平面分开部署。**

+

+

+

+## 前置条件

+

+- 已准备一个控制平面

+- 已准备至少一个数据平面

+- 各平面之间 kubernetes 网络已互通

+- 已安装 [kustomize](https://kustomize.io/) v3+:具体请参考

+

+- 下载 mogdb-stack-examples 仓库

+

+首先,在 GitHub 上 [fork mogdb-stack-examples](https://github.com/enmotech/mogdb-stack-examples/fork) 仓库:

+

+ mogdb stack 的 kustomize 安装包。

+

+之后,您可以通过类似如下的命令将仓库下载至本地:

+

+```shell

+YOUR_GITHUB_UN=""

+git clone --depth 1 "git@github.com:${YOUR_GITHUB_UN}/mogdb-stack-examples.git"

+cd mogdb-stack-examples

+```

+

+

+

+## 安装模式

+

+在安装 mogdb-stack 中的 mogdb-operator 与 multi-operator 组件时,可以配置其管理整个 kubernetes 集群的 mogdb 集群,或仅允许其管理单个 kubernetes 命名空间中的 mogdb 集群。

+

+在管理整个 kubernetes 集群的 mogdb 集群时,我们会创建 ClusterRole 与 ClusterRoleBinding。

+

+但是当仅允许其管理单个 kubernetes 命名空间中的 mogdb 集群时,我们则会创建 Role 与 RoleBinding。

+

+不论是集群模式还是命名空间模式,kustomize 都会自动帮助我们创建必须的资源。其中集群模式的 kustomization 文件位于各组件安装包的 `default` 文件夹中,命名空间模式的 kustomization 文件位于各组件安装包的 `singlenamespace` 文件夹中。

+

+**因此,不论您选择哪种安装模式,都应该在自定义配置时修改对应文件夹中的内容,否则配置将不会生效。**

+

+

+

+## 配置

+

+虽然默认的 kustomize 安装项目可以在大多数 kubernetes 环境中工作,但可能有必要根据您的特定需求进一步自定义 kustomize 项目。

+

+例如,要自定义 stack 的镜像,可以修改位于 `kustomize/<具体组件>/install/default/kustomization.yaml` 文件中的 `images` 配置。

+

+这里以基础组件 `mogdb-operator` 为例:

+

+```yaml

+images:

+ - name: controller

+ newName: swr.cn-north-4.myhuaweicloud.com/mogdb-cloud/mogdb-operator

+ newTag: 3.0.0

+```

+

+

+

+请注意,kustomize 安装包还将默认为 mogdb-stack 创建一个/多个命名空间。要修改安装程序创建的命名空间的名称,应修改位于 `kustomize/<具体组件>/overlays/stable/kustomization.yaml` 文件中的 `namespace` 配置。

+

+这里以基础组件 `mogdb-operator` 为例:

+

+```yaml

+# Add namespace to all resources.

+namespace: mogdb-operator-system

+```

+

+

+

+除此之外,您还可以使用 patches 等诸多 kustomize 提供的强大功能自定义您的 mogdb-stack,有关这些功能的详细信息请参考 [kustomize 官方文档](https://kubectl.docs.kubernetes.io/)。

+

+

+

+## 控制平面安装

+

+在根据您的特定需求完成每个组件的 kustomize 安装包自定义后,我们可以开始控制平面的安装。

+

+**注意:只能同时存在一个控制平面。**

+

+在开始之前,确保您已将 kubectl 的当前上下文切换到控制平面:

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context control-plane

+Switched to context "control-plane".

+```

+

+

+

+### 1.安装 mogdb-ha

+

+**注意**:

+

+- mogdb-ha 组件是**必选的**;

+- 如果您要将其用于生产环境,确保您已准备了**高可用 etcd 集群**并在[配置](##配置)阶段完成了其相关配置。

+

+

+

+创建 namespace:

+

+```shell

+kubectl create namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl create namespace mogdb-ha

+namespace/mogdb-ha created

+```

+

+

+

+安装 mogdb-ha 组件:

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-ha/install

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-ha/install

+namespace/mogdb-ha serverside-applied

+serviceaccount/mogdb-ha serverside-applied

+clusterrole.rbac.authorization.k8s.io/mogdb-ha-role serverside-applied

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-ha-rolebinding serverside-applied

+secret/mogdb-ha-huawei-registry serverside-applied

+service/mogdb-ha serverside-applied

+deployment.apps/mogdb-ha serverside-applied

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n mogdb-ha

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-ha-58fb655887-59q8z 2/2 Running 0 71s

+

+NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

+service/mogdb-ha NodePort 10.96.7.215 6544:32544/TCP 71s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-ha 1/1 1 1 71s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-ha-58fb655887 1 1 1 71s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+### 2.安装控制平面 multi-operator

+

+**注意**:

+

+- multi-operator 组件是**必选的**;

+

+

+

+安装 CRD:

+

+**注意,在同一个 kubernetes 集群中,CRD 只需安装一次。**

+

+```shell

+kubectl apply --server-side -k kustomize/multi-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/multi-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io/kubeclientconfigs.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/multiclusters.mogdb.enmotech.io serverside-applied

+```

+

+

+

+创建 namespace:

+

+```shell

+kubectl create namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl create namespace control-plane

+namespace/control-plane created

+```

+

+

+

+安装 multi-operator:

+

+- 要以**集群模式**安装 multi-operator,请使用位于 `default` 文件夹中的 kustomization 文件:

+

+```shell

+kubectl apply --server-side -k kustomize/multi-operator/install-ctl-plane/default

+```

+

+ 期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/multi-operator/install-ctl-plane/default

+serviceaccount/mogdb-multi-serviceaccount serverside-applied

+clusterrole.rbac.authorization.k8s.io/mogdb-multi-leader-election-role serverside-applied

+clusterrole.rbac.authorization.k8s.io/mogdb-multi-manager-role serverside-applied

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-multi-leader-election-rolebinding serverside-applied

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-multi-manager-rolebinding serverside-applied

+secret/mogdb-multi-multi-operator-huawei-registry serverside-applied

+deployment.apps/mogdb-multi-manager serverside-applied

+```

+

+- 要以**命名空间模式**安装 multi-operator,请使用位于 `singlenamespace` 文件夹中的 kustomization 文件:

+

+```shell

+kubectl apply --server-side -k kustomize/multi-operator/install-ctl-plane/singlenamespace

+```

+

+ 期望输出

+

+```shell

+$ kubectl apply --server-side -k kustomize/multi-operator/install-ctl-plane/singlenamespace

+serviceaccount/mogdb-multi-serviceaccount serverside-applied

+role.rbac.authorization.k8s.io/mogdb-multi-leader-election-role serverside-applied

+role.rbac.authorization.k8s.io/mogdb-multi-manager-role serverside-applied

+rolebinding.rbac.authorization.k8s.io/mogdb-multi-leader-election-rolebinding serverside-applied

+rolebinding.rbac.authorization.k8s.io/mogdb-multi-manager-rolebinding serverside-applied

+secret/mogdb-multi-multi-operator-huawei-registry serverside-applied

+deployment.apps/mogdb-multi-manager serverside-applied

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n control-plane

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-multi-manager-77587fd775-npf9d 1/1 Running 0 25s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-multi-manager 1/1 1 1 25s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-multi-manager-77587fd775 1 1 1 25s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+> 至此完成控制平面的安装。

+

+

+

+## 数据平面安装

+

+在根据您的特定需求完成每个组件的 kustomize 安装包自定义后,我们可以开始数据平面的安装。

+

+**注意:可以同时存在多个数据平面,如果您拥有多个数据平面,则只需切换至对应的上下文,并循环执行该小节。**

+

+在开始之前,确保您已将 kubectl 的当前上下文切换到数据平面:

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context data-plane1

+Switched to context "data-plane1".

+```

+

+

+

+### 1.安装 mogdb-operator

+

+**注意**:

+

+- mogdb-operator 组件是**必选的**;

+

+

+

+安装 CRD:

+

+**注意,在同一个 kubernetes 集群中,CRD 只需安装一次。**

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io/mogdbclusters.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/mogdbclustertemplates.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/mogdbpodtemplates.mogdb.enmotech.io serverside-applied

+```

+

+

+

+创建 namespace:

+

+```shell

+kubectl create namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl create namespace data-plane1

+namespace/data-plane1 created

+```

+

+

+

+安装mogdb-operator:

+

+首先将以下几个文件的对应的值修改成和data-plane1相关:

+

+```shell

+kustomize/mogdb-operator/install/singlenamespace/kustomization.yaml:

+namespace:data-plane1

+

+kustomize/mogdb-operator/install/singlenamespace/patches/rbac/leader_election_role_binding.yaml:

+value: mogdb-operator-system-leader-election-rolebinding-data-plane1

+

+kustomize/mogdb-operator/install/singlenamespace/patches/rbac/leader_election_role.yaml:

+value: mogdb-operator-system-leader-election-role-data-plane1

+

+kustomize/mogdb-operator/install/singlenamespace/patches/rbac/manager_role_binding.yaml

+value: mogdb-operator-system-manager-rolebinding-data-plane1

+

+kustomize/mogdb-operator/install/singlenamespace/patches/rbac/manager_role.yaml

+value: mogdb-operator-system-manager-role-data-plane1

+```

+

+

+

+安装 mogdb-operator:

+

+- 要以**集群模式**安装 mogdb-operator,请使用位于 `default` 文件夹中的 kustomization 文件:

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-operator/install/default

+```

+

+ 期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-operator/install/default

+serviceaccount/mogdb-operator-controller-manager serverside-applied

+clusterrole.rbac.authorization.k8s.io/mogdb-operator-leader-election-role serverside-applied

+clusterrole.rbac.authorization.k8s.io/mogdb-operator-manager-role serverside-applied

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-operator-leader-election-rolebinding serverside-applied

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-operator-manager-rolebinding serverside-applied

+configmap/mogdb-operator-global-config serverside-applied

+configmap/mogdb-operator-rclone-config serverside-applied

+secret/mogdb-operator-huawei-registry serverside-applied

+secret/mogdb-operator-token serverside-applied

+deployment.apps/mogdb-operator-manager serverside-applied

+```

+

+- 要以**命名空间模式**安装 mogdb-operator,请使用位于 `singlenamespace` 文件夹中的 kustomization 文件:

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-operator/install/singlenamespace

+```

+

+ 期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-operator/install/default

+serviceaccount/mogdb-operator-controller-manager serverside-applied

+role.rbac.authorization.k8s.io/mogdb-operator-leader-election-role serverside-applied

+role.rbac.authorization.k8s.io/mogdb-operator-manager-role serverside-applied

+rolebinding.rbac.authorization.k8s.io/mogdb-operator-leader-election-rolebinding serverside-applied

+rolebinding.rbac.authorization.k8s.io/mogdb-operator-manager-rolebinding serverside-applied

+configmap/mogdb-operator-global-config serverside-applied

+configmap/mogdb-operator-rclone-config serverside-applied

+secret/mogdb-operator-huawei-registry serverside-applied

+secret/mogdb-operator-token serverside-applied

+deployment.apps/mogdb-operator-manager serverside-applied

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n data-plane1

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-operator-manager-5b5c4bb8b8-z2l48 1/1 Running 0 32s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-operator-manager 1/1 1 1 32s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-operator-manager-5b5c4bb8b8 1 1 1 32s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+### 2.注册数据平面到控制平面

+

+我们提供了注册到数据平面的脚本供您使用:

+

+```shell

+./join-to-control-plane.sh \

+--output-dir ./build \

+--src-kubeconfig ~/.kube/config \

+--src-context data-plane1 \

+--src-namespace data-plane1 \

+--src-serviceaccount mogdb-operator-controller-manager \

+--dest-kubeconfig ~/.kube/config \

+--dest-context control-plane \

+--dest-namespace control-plane

+```

+

+其中各选项的含义如下:

+

+- --output-dir:脚本运行过程中生成文件的存放路径;

+- --src-context:数据平面上下文,在本例中为 data-plane1;

+- --src-kubeconfig:数据平面 kubeconfig 路径,在本例中为 ~/.kube/config;

+- --src-namespace:数据平面所在命名空间,在本例中为 data-plane1;

+- --src-serviceaccount:数据平面的 serviceaccount,用于控制控制平面对数据平面访问的权限,在本例中为 mogdb-operator-controller-manager;

+-

+- --dest-context:控制平面上下文,在本例中为 control-plane;

+- --dest-kubeconfig:控制平面 kubeconfig 路径,在本例中为 ~/.kube/config;

+- --dest-namespace:控制平面所在命名空间,在本例中为 control-plane;

+

+期望输出:

+

+```shell

+% ./join-to-control-plane.sh \

+--output-dir ./build \

+--src-kubeconfig ~/.kube/config \

+--src-context data-plane1 \

+--src-namespace data-plane1 \

+--src-serviceaccount mogdb-operator-controller-manager \

+--dest-kubeconfig ~/.kube/config \

+--dest-context control-plane \

+--dest-namespace control-plane

+

+Source cluster had localhost as the API server address; replacing with https://172.19.0.6:6443

+Creating KubeConfig at ./build/kubeconfig

+Creating secret data-plane1

+secrets "data-plane1" not found

+secret/data-plane1 created

+Creating ClientConfig ./build/data-plane1.yaml

+kubeclientconfig.mogdb.enmotech.io/data-plane1 created

+```

+

+

+

+### 3.部署Multi Cluster

+

+```shell

+kubectl apply --server-side -k kustomize/multi-cluster/install/default

+```

+

+期望输出:

+

+```shell

+multicluster.mogdb.enmotech.io/multi-cluster created

+```

+

+查看Multi Cluster pod状态:

+

+```shell

+kubectl get pods -A --selector='mogdb.enmotech.io/app=multi-operator'

+```

+

+查看结果:

+

+```shell

+NAMESPACE NAME READY STATUS RESTARTS AGE

+data-plane1 dc1-sts-259bm-0 2/2 Running 0 3h52m

+data-plane1 dc1-sts-fxq24-0 2/2 Running 0 3h53m

+data-plane2 dc2-sts-djsm2-0 2/2 Running 0 3h51m

+data-plane2 dc2-sts-zbqxb-0 2/2 Running 0 3h51m

+```

+

+

+

+> 至此完成数据平面的安装。

+

+

+

+## 卸载

+

+### 1.删除多k8s集群的MogDB集群

+

+```shell

+kubectl delete -k kustomize/multi-cluster/install/default

+```

+

+期望输出:

+

+```text

+mogdbcluster.mogdb.enmotech.io "mogdb-cluster" deleted

+```

+

+### 2.卸载数据平面组件

+

+> 首先确保要卸载的数据平面上已无 mogdb 集群残留。

+>

+> 如果您拥有多个数据平面,则只需切换至对应的上下文,并循环执行该小节。

+

+**切换到控制平面**

+

+解注册需要在控制平面进行,因此需要先切换到控制平面。

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context control-plane

+Switched to context "control-plane".

+```

+

+

+

+**解注册**

+

+```shell

+kubectl delete kubeclientconfig.mogdb.enmotech.io/ -n

+```

+

+期望输出:

+

+```shell

+$ kubectl delete kubeclientconfig.mogdb.enmotech.io/data-plane1 -n mogdb-operator-system

+kubeclientconfig.mogdb.enmotech.io "data-plane1" deleted

+```

+

+

+

+**切换到数据平面**

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context data-plane1

+Switched to context "data-plane1".

+```

+

+

+

+**卸载 multi-cluster**

+

+```shell

+kubectl delete -k kustomize/multi-operator/install-ctl-plane/default

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/multi-operator/install-ctl-plane/default

+serviceaccount/mogdb-multi-serviceaccount deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-multi-leader-election-role deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-multi-manager-role deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-multi-leader-election-rolebinding deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-multi-manager-rolebinding deleted

+secret/mogdb-multi-multi-operator-huawei-registry deleted

+deployment.apps/mogdb-multi-manager deleted

+```

+

+

+

+**卸载 mogdb-cluster**

+

+```shell

+kubectl delete -k kustomize/mogdb-operator/install/default

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/mogdb-operator/install/default

+namespace/mogdb-operator-system deleted

+serviceaccount/mogdb-operator-controller-manager deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-operator-leader-election-role deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-operator-manager-role deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-operator-leader-election-rolebinding deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-operator-manager-rolebinding deleted

+configmap/mogdb-operator-global-config deleted

+configmap/mogdb-operator-rclone-config deleted

+secret/mogdb-operator-huawei-registry deleted

+secret/mogdb-operator-token deleted

+deployment.apps/mogdb-operator-manager deleted

+```

+

+

+

+**卸载 CRD**

+

+```shell

+kubectl delete -k kustomize/mogdb-operator/bases/crd

+kubectl delete -k kustomize/multi-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/mogdb-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io "mogdbclusters.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "mogdbclustertemplates.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "mogdbpodtemplates.mogdb.enmotech.io" deleted

+

+$ kubectl delete -k kustomize/multi-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io "kubeclientconfigs.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "multiclusters.mogdb.enmotech.io" deleted

+```

+

+

+

+**删除命名空间**

+

+```shell

+kubectl delete namespace

+```

+

+期望输出:

+

+```shell

+kubectl delete namespace mogdb-operator-system

+namespace "mogdb-operator-system" deleted

+```

+

+

+

+### 3.卸载控制平面组件

+

+> 首先确保要卸载的控制平面上已无 mogdb 集群残留。

+

+**切换到控制平面**

+

+```shell

+kubectl config --kubeconfig use-context

+```

+

+期望输出:

+

+```shell

+$ kubectl config --kubeconfig ~/.kube/config use-context control-plane

+Switched to context "control-plane".

+```

+

+

+

+**卸载 mogdb-ha**

+

+```shell

+kubectl delete -k kustomize/mogdb-ha/install

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/mogdb-ha/install

+namespace/mogdb-ha deleted

+serviceaccount/mogdb-ha deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-ha-role deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-ha-rolebinding deleted

+secret/mogdb-ha-huawei-registry deleted

+service/mogdb-ha deleted

+deployment.apps/mogdb-ha deleted

+```

+

+

+

+**卸载 multi-cluster**

+

+```shell

+kubectl delete -k kustomize/multi-operator/install-ctl-plane/default

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/multi-operator/install-ctl-plane/default

+serviceaccount/mogdb-multi-serviceaccount deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-multi-leader-election-role deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-multi-manager-role deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-multi-leader-election-rolebinding deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-multi-manager-rolebinding deleted

+secret/mogdb-multi-multi-operator-huawei-registry deleted

+deployment.apps/mogdb-multi-manager deleted

+```

+

+

+

+**卸载 CRD**

+

+```shell

+kubectl delete -k kustomize/multi-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/multi-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io "kubeclientconfigs.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "multiclusters.mogdb.enmotech.io" deleted

+```

+

+

+

+**删除命名空间**

+

+```shell

+kubectl delete namespace

+```

+

+期望输出:

+

+```shell

+kubectl delete namespace mogdb-ha

+namespace "mogdb-ha" deleted

+

+kubectl delete namespace mogdb-operator-system

+namespace "mogdb-operator-system" deleted

+```

diff --git a/product/zh/docs-mogdb-stack/v3.0/installation/single-helm.md b/product/zh/docs-mogdb-stack/v3.0/installation/single-helm.md

new file mode 100644

index 0000000000000000000000000000000000000000..173ebd9c5bcf73b0a132c78ec0967fb6b09d76fc

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/installation/single-helm.md

@@ -0,0 +1,383 @@

+---

+date: 2023-06-30

+author: houzhen.su

+title: 使用 helm 安装(单集群模式)

+summary: 使用 helm 安装(单集群模式)

+---

+

+# 使用 helm 安装(单集群模式)

+

+本节提供了使用 helm 安装和配置 mogdb-stack `单 kubernetes 集群模式`的说明。

+

+

+

+## 前置条件

+

+- 已安装 [helm](https://helm.sh),具体请参考

+- 添加 [enmotech helm 发布仓](https://github.com/enmotech/charts)

+

+```shell

+helm repo add enmotech https://enmotech.github.io/charts

+```

+

+ 期望输出:

+

+```shell

+$ helm repo add enmotech https://enmotech.github.io/charts

+"enmotech" has been added to your repositories

+

+$ helm search repo enmotech

+NAME CHART VERSION APP VERSION DESCRIPTION

+enmotech/mogha 3.0.0 3.0.0 Helm chart for deploying MogDB Ha on Kubernetes

+enmotech/mogdb-monitor 3.0.0 3.0.0 A Helm chart for Kubernetes

+enmotech/mogdb-cluster 3.0.0 3.0.0 Helm chart for deploying MogDB Cluster on Kubernetes

+enmotech/multi-cluster 3.0.0 3.0.0 Helm chart for deploying MogDB Multi Cluster on Kubernetes

+enmotech/mogdb-operator 3.0.0 3.0.0 Helm chart for deploying MogDB Operator on Kubernetes

+enmotech/multi-operator 3.0.0 3.0.0 Helm chart for deploying MogDB Multi Operator on Kubernetes

+```

+

+

+

+## 安装模式

+

+在安装 mogdb-stack 中的 mogdb-operator 与 multi-operator 组件时,可以配置其管理整个 kubernetes 集群的 mogdb 集群,或仅允许其管理单个 kubernetes 命名空间中的 mogdb 集群。

+

+在管理整个 kubernetes 集群的 mogdb 集群时,我们会创建 ClusterRole 与 ClusterRoleBinding。

+

+但是当仅允许其管理单个 kubernetes 命名空间中的 mogdb 集群时,我们则会创建 Role 与 RoleBinding。

+

+不论是集群模式还是命名空间模式,helm 都会自动帮助我们创建必须的资源。

+

+**默认情况下为集群模式,如果要使用命名空间模式,只需指定 `singleNamespace=true` 即可。**

+

+

+

+## 配置

+

+虽然默认的 helm chart 可以在大多数 kubernetes 环境中工作,但可能有必要根据您的特定需求进一步自定义。

+

+我们的 Helm charts 为您提供了丰富的可自定义选项,有关这些选项的具体信息,请参考[参考/helm-charts](../references/helm-charts)。

+

+

+

+## 安装

+

+### 1.安装 mogdb-ha

+

+**注意**:

+

+- mogdb-ha 组件是**可选的**。如果您要将 mogdb-stack 用于生产环境,我们推荐您安装该组件;

+- 如果您要将其用于生产环境,确保您已准备了**高可用 etcd 集群**,我们会在在后续安装时传递相关信息。

+

+

+

+创建 namespace:

+

+```shell

+kubectl create namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl create namespace mogdb-ha

+namespace/mogdb-ha created

+```

+

+

+

+安装 mogdb-ha 组件,有关设置的详细信息说明请参考 [mogdb ha charts value](../references/charts/mogdb-ha):

+

+- 默认以**集群模式**安装 mogdb-ha:

+

+```shell

+helm install enmotech/mogdb-ha -n [--set =...]

+```

+

+ 期望输出(在本例中,关闭了 debug 日志,使用简化版 etcd,并设置 ha 容器的内存大小为 1Gi):

+

+```shell

+$ helm install mogdb-ha helm/mogdb-ha -n mogdb-ha \

+ --set debug=false \

+ --set withEtcd=true \

+ --set ha.resources.limits.memory=1Gi \

+ --set ha.resources.requests.memory=1Gi

+NAME: mogdb-ha

+LAST DEPLOYED: Tue Jul 4 13:58:13 2023

+NAMESPACE: mogdb-ha

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Ha!

+```

+

+

+

+- 要以**命名空间模式**安装 mogdb-ha,请指定 `--set singleNamespace=true`:

+

+```shell

+helm install enmotech/mogdb-ha -n --set singleNamespace=true [--set =...]

+```

+

+ 期望输出(在本例中,关闭了 debug 日志,使用简化版 etcd,并设置 ha 容器的内存大小为 1Gi):

+

+```shell

+$ helm install mogdb-ha helm/mogdb-ha -n mogdb-ha \

+ --set singleNamespace=true \

+ --set debug=false \

+ --set withEtcd=true \

+ --set ha.resources.limits.memory=1Gi \

+ --set ha.resources.requests.memory=1Gi

+NAME: mogdb-ha

+LAST DEPLOYED: Tue Jul 4 13:58:13 2023

+NAMESPACE: mogdb-ha

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Ha!

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n mogdb-ha

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-ha-58fb655887-59q8z 2/2 Running 0 71s

+

+NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

+service/mogdb-ha NodePort 10.96.7.215 6544/TCP 71s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-ha 1/1 1 1 71s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-ha-58fb655887 1 1 1 71s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+### 2.安装 mogdb-operator

+

+**注意**:mogdb-operator 组件是**必选的**;

+

+

+

+安装 CRD:

+

+**注意,在同一个 kubernetes 集群中,CRD 只需安装一次。**

+

+```shell

+kubectl apply --server-side -k xxx

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io/mogdbclusters.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/mogdbclustertemplates.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/mogdbpodtemplates.mogdb.enmotech.io serverside-applied

+```

+

+

+

+创建 namespace:

+

+```shell

+kubectl create namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl create namespace mogdb-operator-system

+namespace/mogdb-operator-system created

+```

+

+

+

+安装 mogdb-operator,有关设置的详细信息说明请参考 [mogdb operator charts value](../references/charts/mogdb-operator):

+

+- 默认以**集群模式**安装 mogdb-operator:

+

+```shell

+helm install enmotech/mogdb-operator -n [--set =...]

+```

+

+ 期望输出:

+

+```shell

+$ helm install manager helm/mogdb-operator -n mogdb-operator-system

+NAME: manager

+LAST DEPLOYED: Tue Jul 4 17:14:17 2023

+NAMESPACE: mogdb-operator-system

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Operator!

+```

+

+- 要以**命名空间模式**安装 mogdb-operator,请指定 `--set singleNamespace=true`:

+

+```shell

+helm install enmotech/mogdb-operator -n --set singleNamespace=true [--set =...]

+```

+

+ 期望输出:

+

+```shell

+$ helm install manager helm/mogdb-operator --set singleNamespace=true -n mogdb-operator-system

+NAME: manager

+LAST DEPLOYED: Tue Jul 4 17:14:17 2023

+NAMESPACE: mogdb-operator-system

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Operator!

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n mogdb-operator-system

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-operator-manager-68f7f7cb48-zbmfq 1/1 Running 0 47s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-operator-manager 1/1 1 1 47s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-operator-manager-68f7f7cb48 1 1 1 47s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+### 3.安装 mogdb-cluster

+

+安装 mogdb-cluster,有关设置的详细信息说明请参考 [mogdb cluster charts value](../references/charts/mogdb-cluster):

+

+- 默认以**集群模式**安装 mogdb-cluster

+

+```shell

+helm install enmotech/mogdb-cluster -n [--set =...]

+```

+

+ 期望输出:

+

+```shell

+$ helm install cluster helm/mogdb-cluster -n mogdb-operator-system

+NAME: cluster

+LAST DEPLOYED: Tue Jul 4 17:14:17 2023

+NAMESPACE: mogdb-operator-system

+STATUS: deployed

+REVISION: 1

+TEST SUITE: None

+NOTES:

+Thank you for deploying MogDB Cluster!

+```

+

+

+

+## 卸载

+

+> 首先确保要卸载的集群中上已无 mogdb 集群残留。

+

+**卸载 cluster**

+

+```shell

+helm uninstall -n

+```

+

+期望输出:

+

+```shell

+$ helm uninstall cluster -n mogdb-operator-system

+release "cluster" uninstalled

+```

+

+**卸载 mogdb-ha**

+

+```shell

+helm uninstall -n

+```

+

+期望输出:

+

+```shell

+$ helm uninstall mogdb-ha -n mogdb-ha

+release "mogdb-ha" uninstalled

+```

+

+

+

+**卸载 mogdb-cluster**

+

+```shell

+helm uninstall -n

+```

+

+期望输出:

+

+```shell

+$ helm uninstall manager -n mogdb-operator-system

+release "manager" uninstalled

+```

+

+

+

+**卸载 CRD**

+

+```shell

+kubectl delete -k kustomize/mogdb-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/mogdb-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io "mogdbclusters.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "mogdbclustertemplates.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "mogdbpodtemplates.mogdb.enmotech.io" deleted

+```

+

+

+

+**删除命名空间**

+

+```shell

+kubectl delete namespace

+```

+

+期望输出:

+

+```shell

+kubectl delete namespace mogdb-ha

+namespace "mogdb-ha" deleted

+

+kubectl delete namespace mogdb-operator-system

+namespace "mogdb-operator-system" deleted

+```

diff --git a/product/zh/docs-mogdb-stack/v3.0/installation/single-kustomize.md b/product/zh/docs-mogdb-stack/v3.0/installation/single-kustomize.md

new file mode 100644

index 0000000000000000000000000000000000000000..604cd6477941166f0264b1425606d4b630547d71

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/installation/single-kustomize.md

@@ -0,0 +1,386 @@

+---

+date: 2022-06-30

+author: houzhen.su

+title: 使用 kustomize 安装(单集群模式)

+summary: 使用 kustomize 安装(单集群模式)

+---

+

+# 使用 kustomize 安装(单集群模式)

+

+本节提供了使用 kustomize 安装和配置 mogdb-stack `单 kubernetes 集群模式`的说明。

+

+

+

+## 前置条件

+

+- 已安装 [kustomize](https://kustomize.io/) v3+:具体请参考

+

+- 下载 mogdb-stack-examples 仓库

+

+首先,在 GitHub 上 [fork mogdb-stack-examples](https://github.com/enmotech/mogdb-stack-examples/fork) 仓库:

+

+ mogdb stack 的 kustomize 安装包。

+

+之后,您可以通过类似如下的命令将仓库下载至本地:

+

+```shell

+YOUR_GITHUB_UN=""

+git clone --depth 1 "git@github.com:${YOUR_GITHUB_UN}/mogdb-stack-examples.git"

+cd mogdb-stack-examples

+```

+

+

+

+## 安装模式

+

+在安装 mogdb-stack 中的 mogdb-operator 组件时,可以配置其管理整个 kubernetes 集群的 mogdb 集群,或仅允许其管理单个 kubernetes 命名空间中的 mogdb 集群。

+

+在管理整个 kubernetes 集群的 mogdb 集群时,我们会创建 ClusterRole 与 ClusterRoleBinding。

+

+但是当仅允许其管理单个 kubernetes 命名空间中的 mogdb 集群时,我们则会创建 Role 与 RoleBinding。

+

+不论是集群模式还是命名空间模式,kustomize 都会自动帮助我们创建必须的资源。其中集群模式的 kustomization 文件位于各组件安装包的 `default` 文件夹中,命名空间模式的 kustomization 文件位于各组件安装包的 `singlenamespace` 文件夹中。

+

+**因此,不论您选择哪种安装模式,都应该在自定义配置时修改对应文件夹中的内容,否则配置将不会生效。**

+

+

+

+## 配置

+

+虽然默认的 kustomize 安装项目可以在大多数 kubernetes 环境中工作,但可能有必要根据您的特定需求进一步自定义 kustomize 项目。

+

+例如,要自定义 stack 的镜像,可以修改位于 `kustomize/<具体组件>/install/default/kustomization.yaml` 文件中的 `images` 配置。

+

+这里以基础组件 `mogdb-operator` 为例:

+

+```yaml

+images:

+ - name: controller

+ newName: swr.cn-north-4.myhuaweicloud.com/mogdb-cloud/mogdb-operator

+ newTag: 3.0.0

+```

+

+

+

+请注意,kustomize 安装包还将默认为 mogdb-stack 创建一个/多个命名空间。要修改安装程序创建的命名空间的名称,应修改位于 `kustomize/<具体组件>/install/default/kustomization.yaml` 文件中的 `namespace` 配置。

+

+这里以基础组件 `mogdb-operator` 为例:

+

+```yaml

+# Add namespace to all resources.

+namespace: mogdb-operator-system

+```

+

+

+

+除此之外,您还可以使用 patches 等诸多 kustomize 提供的强大功能自定义您的 mogdb-stack,有关这些功能的详细信息请参考 [kustomize 官方文档](https://kubectl.docs.kubernetes.io/)。

+

+

+

+## 安装

+

+在根据您的特定需求完成每个组件的 kustomize 安装包自定义后,我们可以开始安装。

+

+### 1.安装 mogdb-ha

+

+**注意**:

+

+- mogdb-ha 组件是**可选的**。如果您要将 mogdb-stack 用于生产环境,我们推荐您安装该组件;

+- 如果您要将其用于生产环境,确保您已准备了**高可用 etcd 集群**并在[配置](##配置)阶段完成了其相关配置。

+

+

+

+安装 mogdb-ha 组件:

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-ha/install

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-ha/install

+namespace/mogdb-ha serverside-applied

+serviceaccount/mogdb-ha serverside-applied

+clusterrole.rbac.authorization.k8s.io/mogdb-ha-role serverside-applied

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-ha-rolebinding serverside-applied

+secret/mogdb-ha-huawei-registry serverside-applied

+service/mogdb-ha serverside-applied

+deployment.apps/mogdb-ha serverside-applied

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n mogha

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n mogha

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-ha-58fb655887-59q8z 2/2 Running 0 71s

+

+NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

+service/mogdb-ha NodePort 10.96.7.215 6544:32544/TCP 71s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-ha 1/1 1 1 71s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-ha-58fb655887 1 1 1 71s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+

+

+### 2.安装 mogdb-operator

+

+**注意**:

+

+- mogdb-operator 组件是**必选的**;

+

+

+

+安装 CRD:

+

+**注意,在同一个 kubernetes 集群中,CRD 只需安装一次。**

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io/mogdbclusters.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/mogdbclustertemplates.mogdb.enmotech.io serverside-applied

+customresourcedefinition.apiextensions.k8s.io/mogdbpodtemplates.mogdb.enmotech.io serverside-applied

+```

+

+

+

+安装 mogdb-operator:

+

+- 要以**集群模式**安装 mogdb-operator,请使用位于 `default` 文件夹中的 kustomization 文件:

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-operator/install/default

+```

+

+期望输出:

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-operator/install/default

+namespace/mogdb-operator-system serverside-applied

+serviceaccount/mogdb-operator-controller-manager serverside-applied

+clusterrole.rbac.authorization.k8s.io/mogdb-operator-leader-election-role serverside-applied

+clusterrole.rbac.authorization.k8s.io/mogdb-operator-manager-role serverside-applied

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-operator-leader-election-rolebinding serverside-applied

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-operator-manager-rolebinding serverside-applied

+configmap/mogdb-operator-global-config serverside-applied

+configmap/mogdb-operator-rclone-config serverside-applied

+secret/mogdb-operator-huawei-registry serverside-applied

+secret/mogdb-operator-token serverside-applied

+deployment.apps/mogdb-operator-manager serverside-applied

+```

+

+- 要以**命名空间模式**安装 mogdb-operator,请使用位于 `singlenamespace` 文件夹中的 kustomization 文件:

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-operator/install/singlenamespace

+```

+

+期望输出

+

+```shell

+$ kubectl apply --server-side -k kustomize/mogdb-operator/install/default

+namespace/mogdb-operator-system serverside-applied

+serviceaccount/mogdb-operator-controller-manager serverside-applied

+role.rbac.authorization.k8s.io/mogdb-operator-leader-election-role serverside-applied

+role.rbac.authorization.k8s.io/mogdb-operator-manager-role serverside-applied

+rolebinding.rbac.authorization.k8s.io/mogdb-operator-leader-election-rolebinding serverside-applied

+rolebinding.rbac.authorization.k8s.io/mogdb-operator-manager-rolebinding serverside-applied

+configmap/mogdb-operator-global-config serverside-applied

+configmap/mogdb-operator-rclone-config serverside-applied

+secret/mogdb-operator-huawei-registry serverside-applied

+secret/mogdb-operator-token serverside-applied

+deployment.apps/mogdb-operator-manager serverside-applied

+```

+

+

+

+检查相关组件是否运行正常:

+

+```shell

+kubectl get all -n mogdb-operator-system

+```

+

+期望输出:

+

+```shell

+$ kubectl get all -n mogdb-operator-system

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-operator-manager-5b5c4bb8b8-z2l48 1/1 Running 0 32s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-operator-manager 1/1 1 1 32s

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-operator-manager-5b5c4bb8b8 1 1 1 32s

+```

+

+当 pod 处于 running 状态时,继续下一步。

+

+### 部署MogDB集群

+

+```shell

+kubectl apply --server-side -k kustomize/mogdb-cluster/install/default

+```

+

+期望输出:

+

+```shell

+mogdbcluster.mogdb.enmotech.io/mogdb-cluster serverside-applied

+```

+

+查看相关组件:

+

+```shell

+kubectl get all -n mogdb-operator-system

+```

+

+期望输出:

+

+```shell

+NAME READY STATUS RESTARTS AGE

+pod/mogdb-cluster-sts-4bvbg-0 2/2 Running 0 2m15s

+pod/mogdb-cluster-sts-rmssp-0 2/2 Running 0 97s

+pod/mogdb-operator-manager-74c955bdd-6pwkr 1/1 Running 0 2m45s

+

+NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

+service/mogdb-cluster-svc-headless ClusterIP None 26000/TCP,9187/TCP 2m15s

+service/mogdb-cluster-svc-master NodePort 10.96.225.229 26000:30416/TCP 2m15s

+service/mogdb-cluster-svc-replicas NodePort 10.96.48.193 26000:32493/TCP 2m15s

+

+NAME READY UP-TO-DATE AVAILABLE AGE

+deployment.apps/mogdb-operator-manager 1/1 1 1 29m

+

+NAME DESIRED CURRENT READY AGE

+replicaset.apps/mogdb-operator-manager-74c955bdd 1 1 1 2m45s

+

+NAME READY AGE

+statefulset.apps/mogdb-cluster-sts-4bvbg 1/1 2m15s

+statefulset.apps/mogdb-cluster-sts-rmssp 1/1 97s

+```

+

+等待所有pod都处于running状态,单集群模式MogDB Cluster就安装好了,可以进行下一步,连接到MogDB集群。

+

+

+> 至此安装完成。

+

+

+

+## 卸载

+

+**卸载 单集群模式MogDB集群**

+

+```shell

+kubectl delete mogdbcluster mogdb-cluster -n mogdb-operator-system

+```

+

+或

+

+```shell

+kubectl delete -k kustomize/mogdb-cluster/install/default

+```

+

+期望输出:

+

+```text

+mogdbcluster.mogdb.enmotech.io "mogdb-cluster" deleted

+```

+

+**卸载 mogdb-ha**

+

+```shell

+kubectl delete -k kustomize/mogdb-ha/install

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/mogdb-ha/install

+namespace/mogdb-ha deleted

+serviceaccount/mogdb-ha deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-ha-role deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-ha-rolebinding deleted

+secret/mogdb-ha-huawei-registry deleted

+service/mogdb-ha deleted

+deployment.apps/mogdb-ha deleted

+```

+

+

+

+**卸载 mogdb-cluster**

+

+```shell

+kubectl delete -k kustomize/mogdb-operator/install/default

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/mogdb-operator/install/default

+namespace/mogdb-operator-system deleted

+serviceaccount/mogdb-operator-controller-manager deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-operator-leader-election-role deleted

+clusterrole.rbac.authorization.k8s.io/mogdb-operator-manager-role deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-operator-leader-election-rolebinding deleted

+clusterrolebinding.rbac.authorization.k8s.io/mogdb-operator-manager-rolebinding deleted

+configmap/mogdb-operator-global-config deleted

+configmap/mogdb-operator-rclone-config deleted

+secret/mogdb-operator-huawei-registry deleted

+secret/mogdb-operator-token deleted

+deployment.apps/mogdb-operator-manager deleted

+```

+

+

+

+**卸载 CRD**

+

+```shell

+kubectl delete -k kustomize/mogdb-operator/bases/crd

+```

+

+期望输出:

+

+```shell

+$ kubectl delete -k kustomize/mogdb-operator/bases/crd

+customresourcedefinition.apiextensions.k8s.io "mogdbclusters.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "mogdbclustertemplates.mogdb.enmotech.io" deleted

+customresourcedefinition.apiextensions.k8s.io "mogdbpodtemplates.mogdb.enmotech.io" deleted

+```

+

+

+

+**删除命名空间**

+

+```shell

+kubectl delete namespace

+```

+

+期望输出:

+

+```shell

+$ kubectl delete namespace mogdb-ha

+namespace "mogdb-ha" deleted

+

+$ kubectl delete namespace mogdb-operator-system

+namespace "mogdb-operator-system" deleted

+```

diff --git a/product/zh/docs-mogdb-stack/v3.0/overview.md b/product/zh/docs-mogdb-stack/v3.0/overview.md

new file mode 100644

index 0000000000000000000000000000000000000000..3991a58c078ade39032d3513f3e6a79b191f5dd7

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/overview.md

@@ -0,0 +1,49 @@

+---

+title: MogDB Stack 简介

+summary: MogDB Stack 简介

+author: Ji Yabin

+date: 2021-06-16

+---

+

+# MogDB Stack 简介

+

+MogDB Stack是Kubernetes上的MogDB集群自动运维系统,提供包括部署、高可用、扩缩容、监控、备份恢复的MogDB全生命周期管理。借助MogDB Stack,MogDB可以无缝运行在公有云或私有部署的Kubernetes集群上。

+

+

+

+## MogDB Stack特性

+

+- **简单便捷的自动部署/回收**

+

+ 以Kubernetes作为原生的容器编排系统,以扩展资源的方式,轻松便捷地创建整套MogDB集群,并且根据用户的期望任意扩缩容。

+

+- **稳定可靠的备份恢复能力**

+

+ 支持基于SQL的备份方式,并且存储在远端分布式存储中,多副本保证备份的可靠性,指定point-in-time的恢复方式,恢复到指定的时间点。

+

+- **企业级的高可用性**

+

+ 自动故障探测、切换,并自动化的拉取数据快照恢复故障节点或重新调度新节点,实现系统的自愈能力,保证用户期望的副本数。

+

+- **完善可靠的监控能力**

+

+ 基于Prometheus实现多维度的统一监控,囊括了系统层、容器层、数据库层的完整的监控指标。

+

+- **精细化的资源管控**

+

+ 针对CPU、内存、存储等资源的限额,保证容器层的独立性,不会互相干扰,支持容器的亲和性、反亲和性调度。

+

+

+

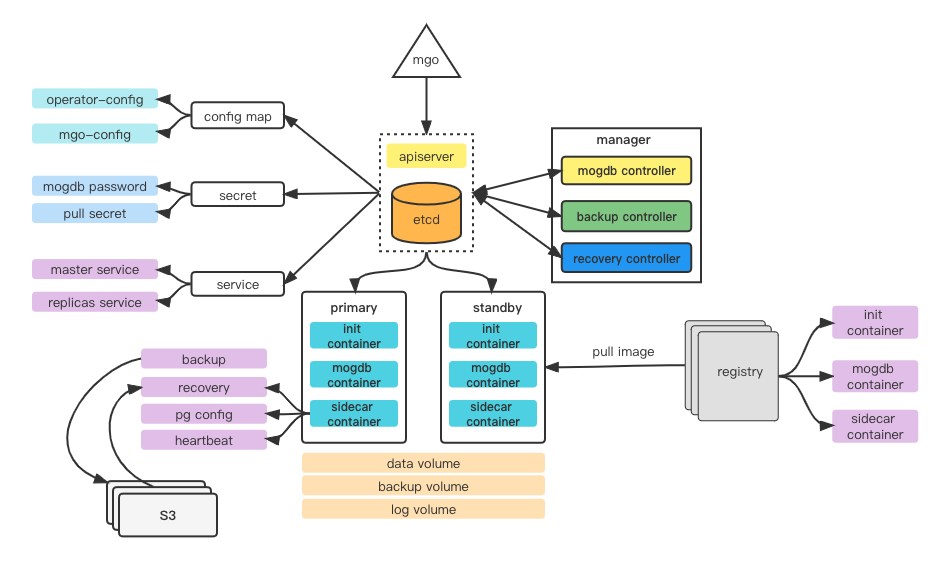

+## 系统架构

+

+

+

+

+

+## 操作系统与平台支持

+

+MogDB Stack 目前支持在如下操作系统和平台架构下运行:

+

+1. Linux x86_64

+2. Linux arm64

\ No newline at end of file

diff --git a/product/zh/docs-mogdb-stack/v3.0/quick-start.md b/product/zh/docs-mogdb-stack/v3.0/quick-start.md

new file mode 100644

index 0000000000000000000000000000000000000000..b5c54e81baf11c90039f9adf2d14636612e9d8d2

--- /dev/null

+++ b/product/zh/docs-mogdb-stack/v3.0/quick-start.md

@@ -0,0 +1,1007 @@

+---

+title: 快速上手

+summary: 快速上手

+author: Wang Dong

+date: 2023-06-20

+---

+

+# 快速上手

+

+本文介绍了如何创建一个简单的 Kubernetes 集群, 以单集群模式和多集群模式部署 MogDB Stack。

+

+> 本文中的部署说明仅用于测试目的,不要直接用于生产环境。如果要在生产环境部署,请参阅部署 > 部署 MogDB Stack 集群章节。

+

+基本步骤如下:

+

+[1. 创建Kubernetes测试集群](#创建kubernetes测试集群)

+

+[2. 单集群模式部署 MogDB Stack](#单集群模式部署MogDBStack)

+

+[3. 多集群模式部署 MogDB Stack](#多集群模式部署MogDBStack)

+

+[4. 连接MogDB集群](#连接mogdb集群)

+

+[5. 销毁MogDB集群](#销毁mogdb集群)

+

+

+

+## 创建Kubernetes测试集群

+

+本节介绍了两种创建 Kubernetes 测试集群的方法,可用于测试 MogDB Operator 管理的 MogDB 集群。

+

+- [使用 kind](#使用kind创建Kubernetes集群)创建在 Docker 中运行的 Kubernetes

+

+- [使用 minikube](#使用minikube创建Kubernetes集群)创建在虚拟机中运行的 Kubernetes

+

+

+

+### 使用 kind 创建 Kubernetes 集群

+

+目前比较通用的方式是使用 [kind](https://kind.sigs.k8s.io/) 部署本地测试 Kubernetes 集群。kind 适用于使用 Docker 容器作为集群节点运行本地 Kubernetes 集群。请参阅 [Docker Hub](https://hub.docker.com/r/kindest/node/tags) 以查看可用 tags。默认使用当前 kind 支持的最新版本。

+

+部署前,请确保满足以下要求:

+

+- docker:版本 >= 18.09

+

+- kubectl:版本 >= 1.18.1

+