一、准备环境

+ +1. 源库创建(Oracle)

+-

+

- 创建Oracle 11.2.0.4 +

MTK程序迁移Oracle需要安装Oracle客户端

+-

+

- 安装Oracle客户端 +

2. 目标库创建(MogDB)

+ +二、迁移

+1. 上传程序,编写配置文件

+迁移为Oracle下的scott用户

+-

+

- 编写配置文件 +

2 迁移

+-

+

- 执行迁移命令 +

-

+

-

+

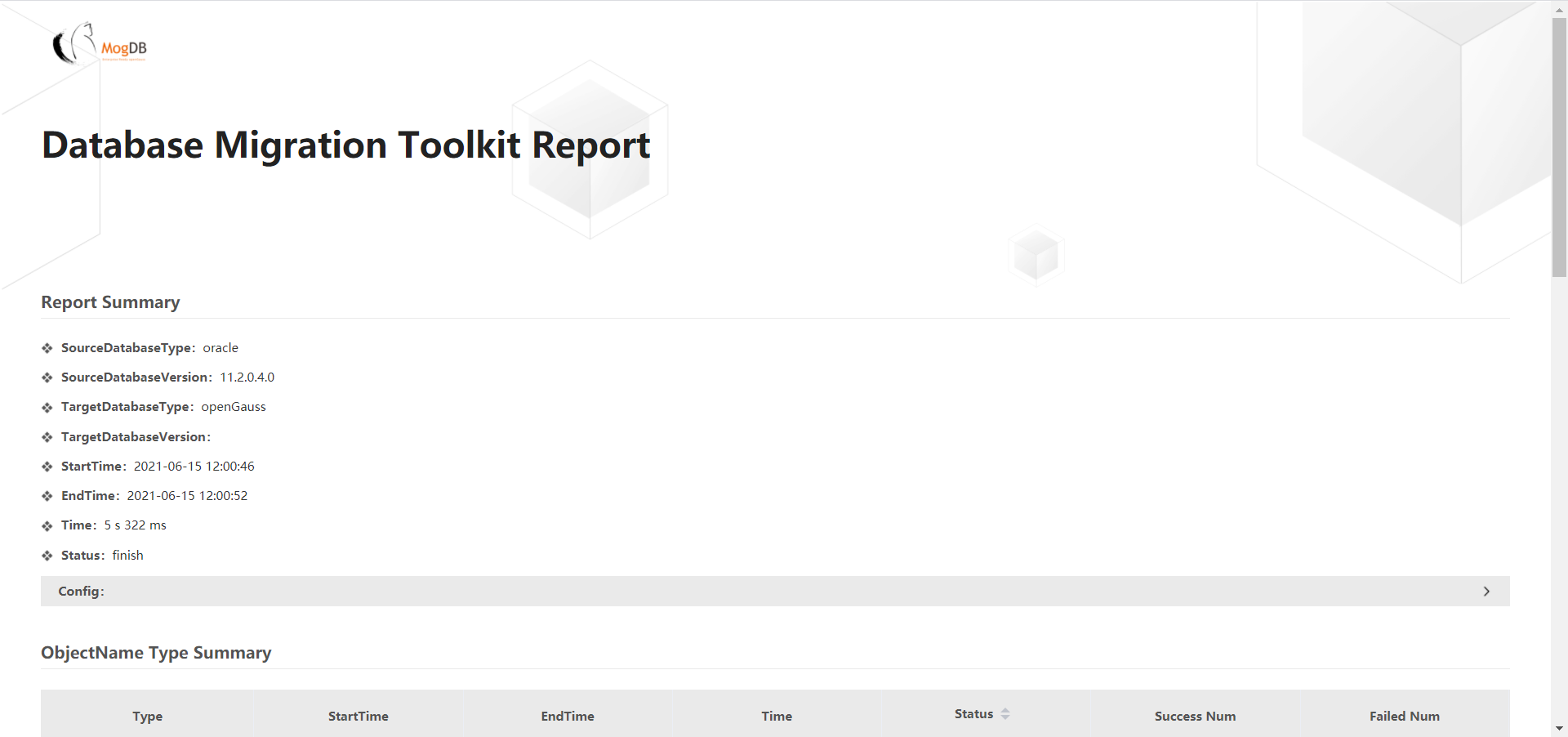

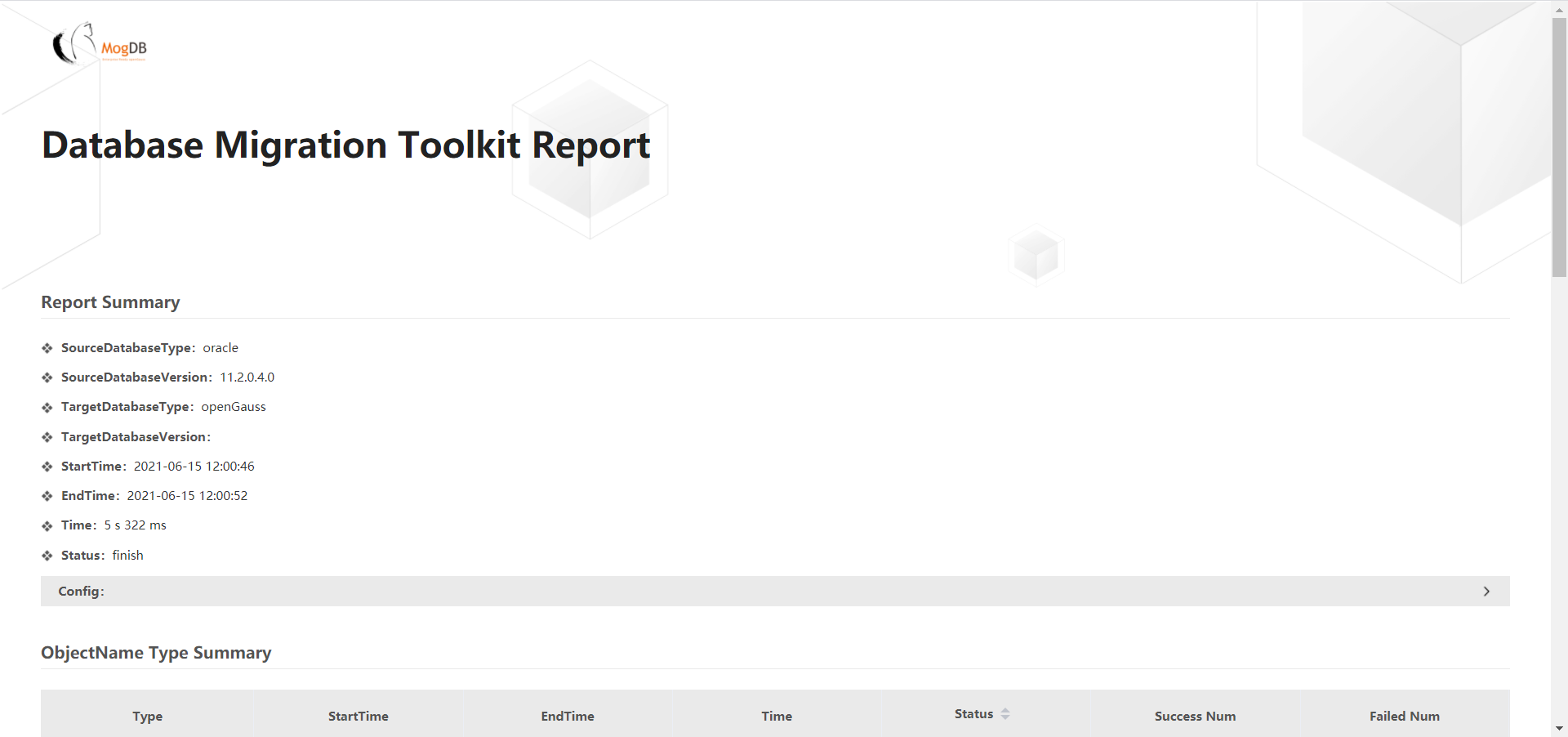

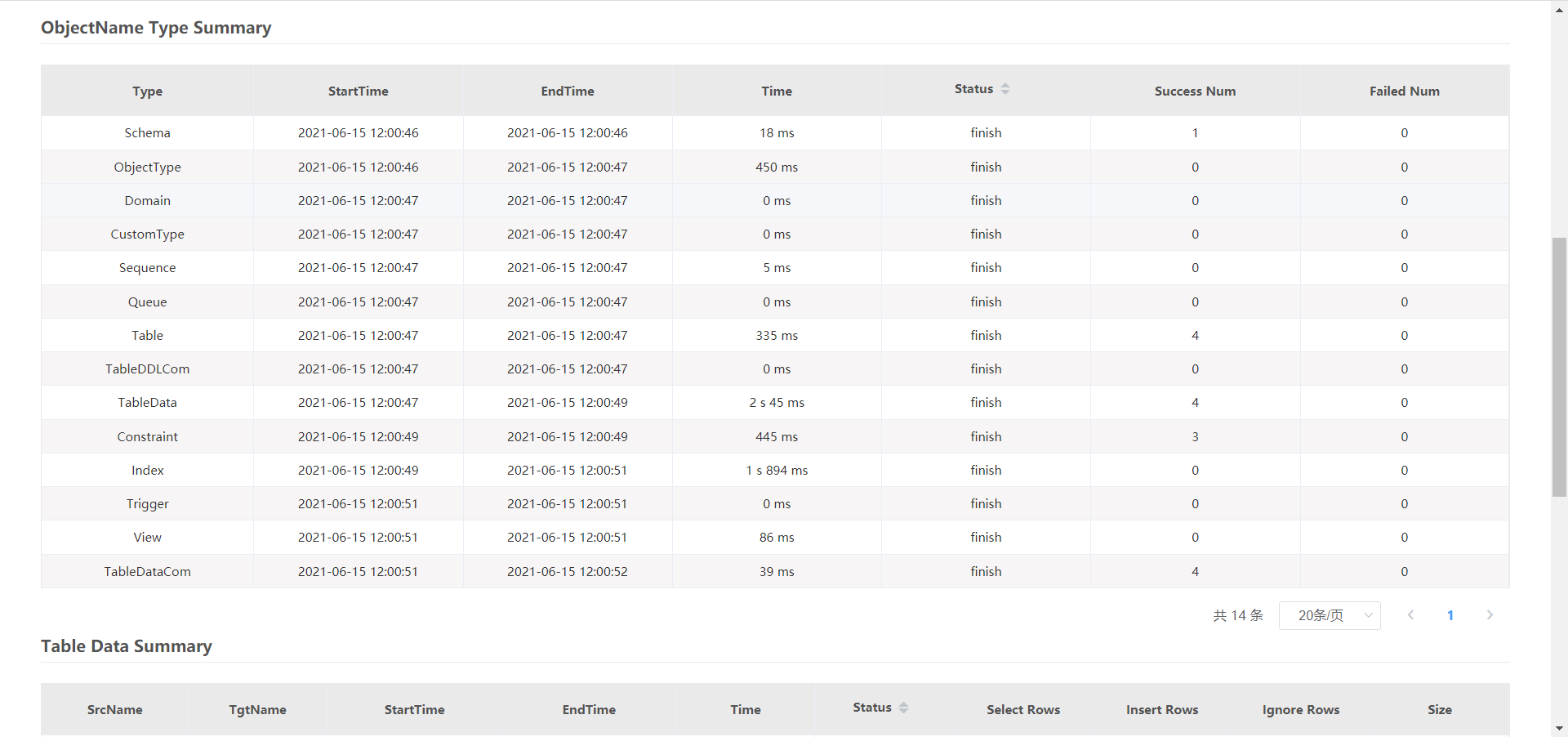

主界面

+

+ +

+ -

+

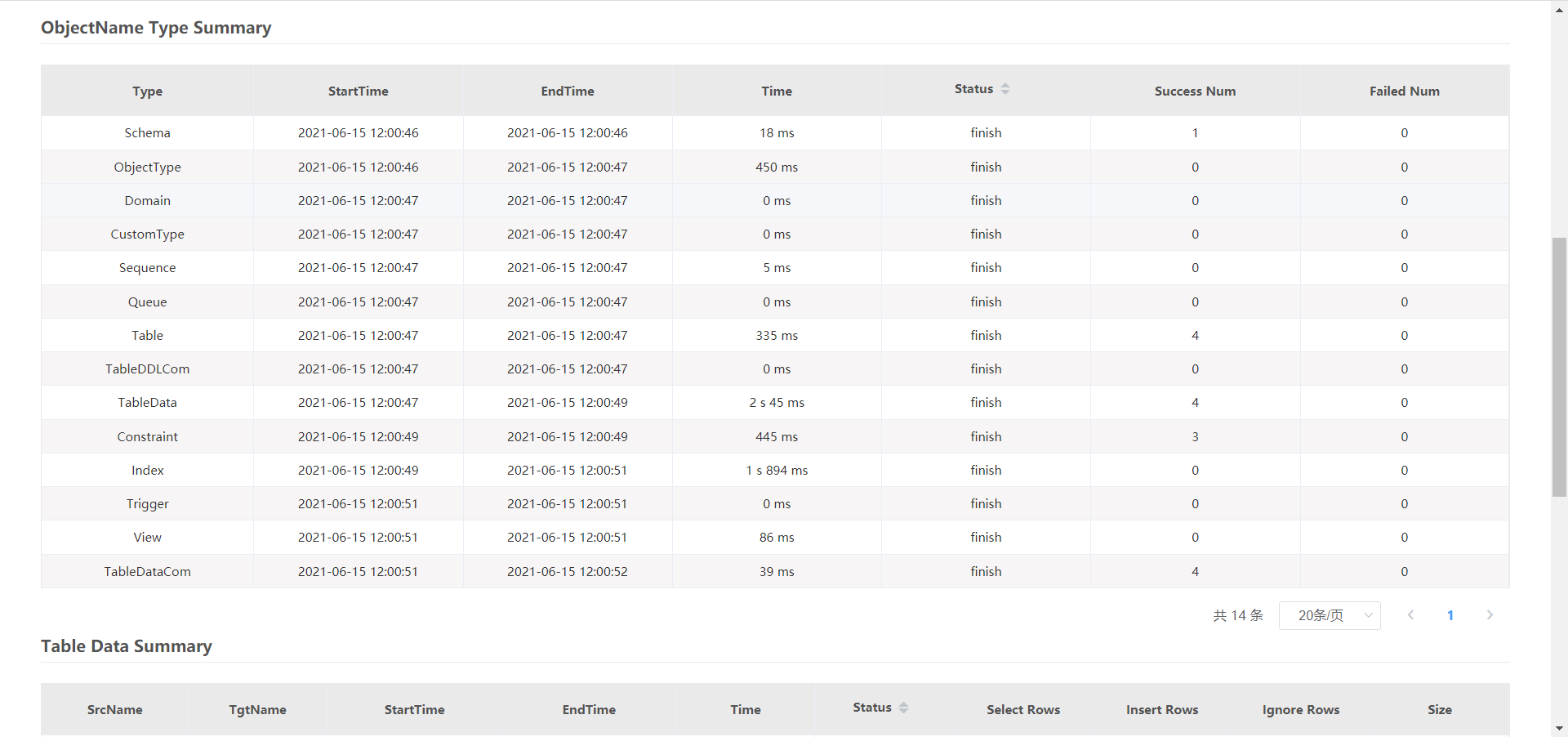

对象

+

+ +

+ -

+

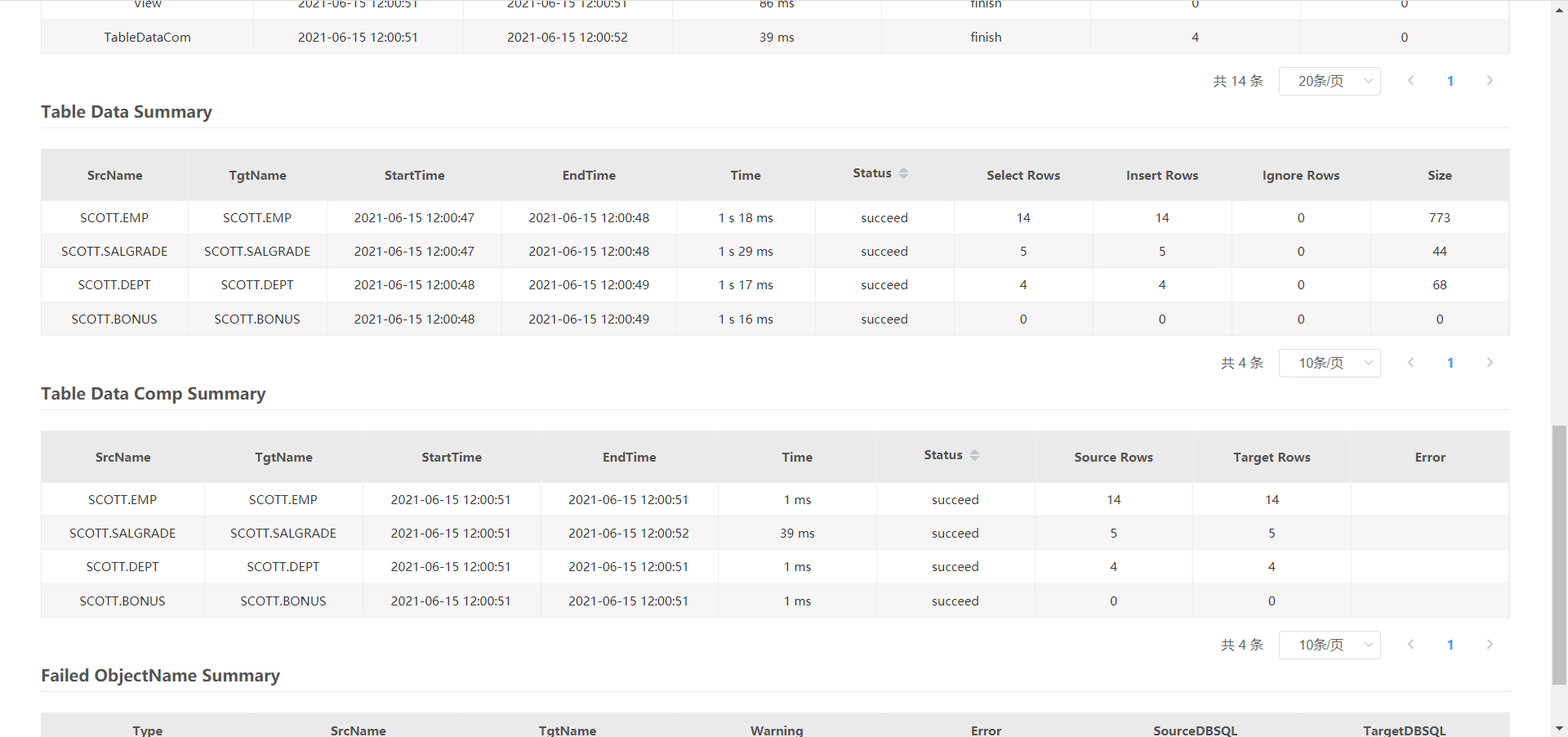

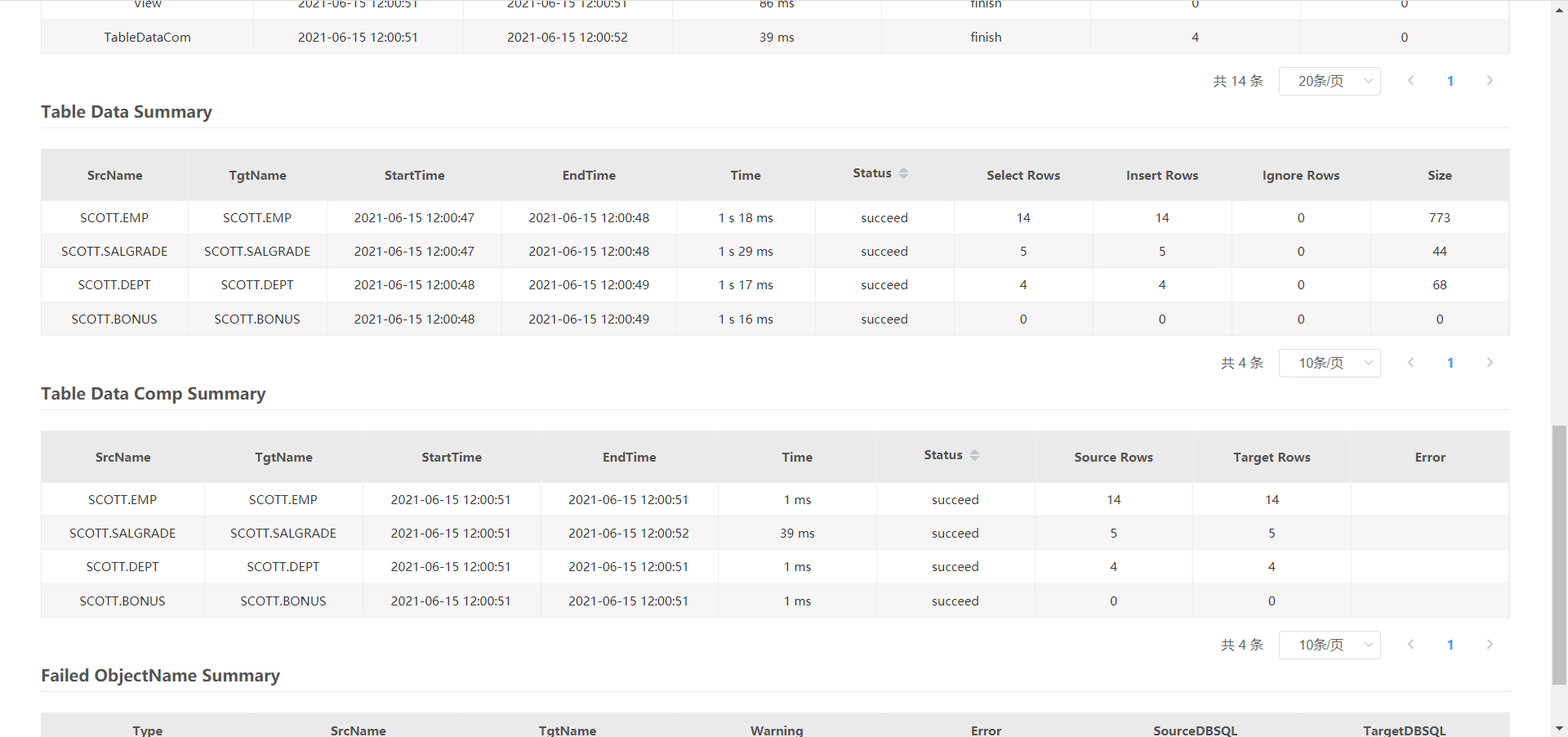

表数据

+

+ +

+

| + | ++ | +

|---|---|

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

|---|---|

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | ++ | ++ | +

|---|---|---|---|

| + | ++ | ++ | ++ |

| + | ++ + | ++ | ++ | +

| + | ++ + | ++ | ++ |

| + | ++ | ++ | ++ | ++ + | ++ | +

|---|---|---|---|---|---|

| + | ++ | ++ | ++ | ++ | ++ | +

| + | ++ | ++ | ++ | ++ | ++ |

| + | ++ | ++ | ++ | ++ | ++ |

| + | ++ | ++ | ++ | ++ | ++ | +

| + | ++ | ++ | ++ | ++ | ++ | +

| + | ++ | ++ | ++ | ++ | ++ | +

| + | ++ | ++ | ++ | ++ + | ++ | +

| + | ++ | ++ | ++ | ++ | ++ | +

| + | ++ | ++ | ++ | ++ | ++ | +

| + | ++ | +

|---|---|

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | ++ | ++ | ++ | +

|---|---|---|---|---|

| + | ++ | ++ | ++ | ++ | +

| 信息分类 | 信息描述 |

| 报告采集类型 | Summary + Detail,即汇总数据+明细数据 |

| Snapshot信息 | 使用snapshot_id为24和25的快照采集2021-04-21(08:59 ~ 09:59)的运行信息 |

| 硬件配置 | 1*1c/4g |

| 节点名 | dn_6001 |

| openGauss版本 | openGauss 2.0.0 |

wait_event类型 | |

|---|---|

| + | ++ | +

|---|---|

| + | +openGauss的配置文件,在gaussmaster线程启动时会读取该文件,获取监听地址、服务端口、内存分配、功能设置等配置信息,并且根据该文件,在openGauss启动时创建共享内存和信号量池等 + |

+

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

|---|---|

| + | ++ | +

| + | ++ | +

| + | ++ | +

| + | ++ | +

MTK程序迁移Oracle需要安装Oracle客户端

+迁移为Oracle下的scott用户

+主界面

+

对象

+

表数据

+

+

+- 打开网络

+

+

+

+- 打开网络

+

+  +

+- 设置时区

+

+

+

+- 设置时区

+

+  +

+- 安装位置和分区

+

+

+

+- 安装位置和分区

+

+  +

+- 软件选择最小安装(也可以选带GUI安装)

+

+

+

+- 软件选择最小安装(也可以选带GUI安装)

+

+  +

+- 开始安装

+

+- 设置ROOT密码和新建用户

+

+- 安装完成后重启

+

+

+

+### 配置CentOS7.6

+

+- 简单配置

+

+ 设置字体 `setfont lat4-19`

+

+ [重新安装VMware Tools(Optional)](https://segmentfault.com/a/1190000038633985)(对于无GUI的应该没啥用,可以在本地ssh到vmware中就可以复制粘贴了)

+

+

+

+

+

+- 使用MobaXterm SSH连接

+

+- yum源更新 `yum update`

+

+- 安装Python3.6 `yum install -y python36`

+

+- 安装其他依赖`yum install -y bzip2 libaio-devel flex bison ncurses-devel glibc-devel patch`

+

+- 关闭防火墙和SeLinux,然后重启,重连ssh

+

+

+

+- 设置字符集参数:在/etc/profile文件中添加”export LANG=XXX”(XXX为Unicode编码)

+

+

+

+- 检查设置时区

+

+

+

+- 关闭swap交换内存(Optional) `swapoff -a`

+

+- 关闭RemovelPC,CentOS操作系统默认为关闭

+

+

+

+

+## 开始安装

+

+- 创建用户组dbgrp、用户omm,将该用户添加至root组,并修改用户omm的密码

+

+

+

+- 配置共享文件夹,把openGauss的安装包(2.0.1 极简版)放进去

+

+- 以root用户创建软件目录,以omm用户登录解压

+

+

+

+- 进入simpleInstall目录,执行安装脚本 `sh install.sh -w xxxx`

+

+ 出现如下错误:

+

+

+

+ 解决办法:

+

+ 在/etc/sysctl.conf中加入语句`kernel.sem = 250 32000 100 999`,然后执行`sysctl -p`

+

+

+

+

+

+- 执行完安装脚本之后:

+

+ openGauss端口号默认为5432

+

+ 默认生成名称为postgres的数据库

+

+ 数据库目录安装路径/opt/software/openGauss/data/single_node,其中/opt/software/openGauss为解压包路径,data/single_node为新创建的数据库节点目录。

+

+- 使用ps和gs_ctl查看进程是否正常(如果没有找到gs_ctl,配置环境变量即可 `export PATH=/opt/software/openGauss/bin:$PATH`,如果缺失lib则配置`LD_LIBRARY_PATH`)

+

+

+

+ 如果ps里没有的话可以先重启一下:

+

+ `gs_ctl restart -D /opt/software/openGauss/data/single_node -Z single_node`

+

+

+

+## 连接与使用

+

+### Gsql方式

+

+数据库安装完成后,默认生成名称为postgres的数据库,默认端口是5432。

+

+因为omm用户是管理员用户,因此系统显示“DBNAME=#”。若使用普通用户身份登录和连接数据库,系统显示“DBNAME=>”。

+

+“Non-SSL connection”表示未使用SSL方式连接数据库。如果需要高安全性时,请使用SSL连接。

+

+

+

+查看对象操作:

+

+- 查看帮助信息:\\?

+- 列举数据库:\\l

+- 列举表:\\dt

+- 查看表结构:\\d tablename

+- 切换数据库:\\c dbname

+- 列举schema:\\dn

+- 查看索引:\\di

+

+

+

+

+

+### 远程连接前的准备

+

+- 配置数据库用户和权限(omm不能用于远程连接):

+

+

+

+- 修改数据库的pg_hba.conf文件,**给要远程连接的主机/用户放行**(这里好像不能用gs_auc命令完成,直接编辑文件即可):

+

+

+

+- 使用gs_ctl将策略生效:`gs_ctl reload -D ./data/single_node`

+

+- **修改postgresql.conf中的监听地址**:`listen_addresses = '*'`,默认只监听local,改后包括了要进行远程连接的ip地址就行

+

+- 重启数据库生效:`gs_ctl restart -D ./data/single_node`

+

+如果之后进行JDBC连接的时候出现如下图中的目标地址拒绝连接的异常,可能就是这一步出问题了

+

+

+

+

+

+### ODBC/JDBC

+

+根据文档JDBC应该是都支持,ODBC支持受限

+

+

+

+- 开始安装

+

+- 设置ROOT密码和新建用户

+

+- 安装完成后重启

+

+

+

+### 配置CentOS7.6

+

+- 简单配置

+

+ 设置字体 `setfont lat4-19`

+

+ [重新安装VMware Tools(Optional)](https://segmentfault.com/a/1190000038633985)(对于无GUI的应该没啥用,可以在本地ssh到vmware中就可以复制粘贴了)

+

+

+

+

+

+- 使用MobaXterm SSH连接

+

+- yum源更新 `yum update`

+

+- 安装Python3.6 `yum install -y python36`

+

+- 安装其他依赖`yum install -y bzip2 libaio-devel flex bison ncurses-devel glibc-devel patch`

+

+- 关闭防火墙和SeLinux,然后重启,重连ssh

+

+

+

+- 设置字符集参数:在/etc/profile文件中添加”export LANG=XXX”(XXX为Unicode编码)

+

+

+

+- 检查设置时区

+

+

+

+- 关闭swap交换内存(Optional) `swapoff -a`

+

+- 关闭RemovelPC,CentOS操作系统默认为关闭

+

+

+

+

+## 开始安装

+

+- 创建用户组dbgrp、用户omm,将该用户添加至root组,并修改用户omm的密码

+

+

+

+- 配置共享文件夹,把openGauss的安装包(2.0.1 极简版)放进去

+

+- 以root用户创建软件目录,以omm用户登录解压

+

+

+

+- 进入simpleInstall目录,执行安装脚本 `sh install.sh -w xxxx`

+

+ 出现如下错误:

+

+

+

+ 解决办法:

+

+ 在/etc/sysctl.conf中加入语句`kernel.sem = 250 32000 100 999`,然后执行`sysctl -p`

+

+

+

+

+

+- 执行完安装脚本之后:

+

+ openGauss端口号默认为5432

+

+ 默认生成名称为postgres的数据库

+

+ 数据库目录安装路径/opt/software/openGauss/data/single_node,其中/opt/software/openGauss为解压包路径,data/single_node为新创建的数据库节点目录。

+

+- 使用ps和gs_ctl查看进程是否正常(如果没有找到gs_ctl,配置环境变量即可 `export PATH=/opt/software/openGauss/bin:$PATH`,如果缺失lib则配置`LD_LIBRARY_PATH`)

+

+

+

+ 如果ps里没有的话可以先重启一下:

+

+ `gs_ctl restart -D /opt/software/openGauss/data/single_node -Z single_node`

+

+

+

+## 连接与使用

+

+### Gsql方式

+

+数据库安装完成后,默认生成名称为postgres的数据库,默认端口是5432。

+

+因为omm用户是管理员用户,因此系统显示“DBNAME=#”。若使用普通用户身份登录和连接数据库,系统显示“DBNAME=>”。

+

+“Non-SSL connection”表示未使用SSL方式连接数据库。如果需要高安全性时,请使用SSL连接。

+

+

+

+查看对象操作:

+

+- 查看帮助信息:\\?

+- 列举数据库:\\l

+- 列举表:\\dt

+- 查看表结构:\\d tablename

+- 切换数据库:\\c dbname

+- 列举schema:\\dn

+- 查看索引:\\di

+

+

+

+

+

+### 远程连接前的准备

+

+- 配置数据库用户和权限(omm不能用于远程连接):

+

+

+

+- 修改数据库的pg_hba.conf文件,**给要远程连接的主机/用户放行**(这里好像不能用gs_auc命令完成,直接编辑文件即可):

+

+

+

+- 使用gs_ctl将策略生效:`gs_ctl reload -D ./data/single_node`

+

+- **修改postgresql.conf中的监听地址**:`listen_addresses = '*'`,默认只监听local,改后包括了要进行远程连接的ip地址就行

+

+- 重启数据库生效:`gs_ctl restart -D ./data/single_node`

+

+如果之后进行JDBC连接的时候出现如下图中的目标地址拒绝连接的异常,可能就是这一步出问题了

+

+

+

+

+

+### ODBC/JDBC

+

+根据文档JDBC应该是都支持,ODBC支持受限

+

+ +

+因为是在CentOS 7.6上装的openGauss,所以选择JDBC。

+

+JDBC Connectors可以不用从源码构建,直接从官网下载页下载即可。

+

+在Win上VSCode中配置好JAVA环境,需要Java11和Java8,配置该项目的JDK Runtime和Referenced Libraries(把下载解压得到的postgresql.jar加进去)

+

+代码:

+

+```java

+import java.sql.Connection;

+import java.sql.DriverManager;

+import java.sql.ResultSet;

+import java.sql.SQLException;

+import java.sql.Statement;

+import java.sql.Timestamp;

+import java.util.Properties;

+

+class openGaussTest {

+ public static void main(String[] args) {

+ System.out.println("=====START TEST=====");

+

+ Connection conn = getConnect("luooofan", "Luooofan1");

+

+ Statement stmt = null;

+ try {

+ stmt = conn.createStatement();

+ ResultSet rs = null;

+ try {

+ rs = stmt.executeQuery(

+ "select pro_c_id, pro_id, pro_status, pro_quantity, pro_income, pro_purchase_time from property;");

+ while (rs.next()) {

+ int pro_c_id = rs.getInt(1);

+ int pro_id = rs.getInt(2);

+ String pro_status = rs.getString(3);

+ int pro_quantity = rs.getInt(4);

+ int pro_income = rs.getInt(5);

+ Timestamp pro_pruchase_time = rs.getTimestamp("pro_purchase_time");

+ System.out.printf("%4d %4d %4s %4d %4d ", pro_c_id, pro_id, pro_status, pro_quantity, pro_income);

+ System.out.println(pro_pruchase_time);

+ }

+ } catch (SQLException e) {

+ if (rs != null) {

+ try {

+ rs.close();

+ } catch (SQLException e1) {

+ e1.printStackTrace();

+ }

+ }

+ e.printStackTrace();

+ }

+

+ stmt.close();

+ } catch (SQLException e) {

+ if (stmt != null) {

+ try {

+ stmt.close();

+ } catch (SQLException e1) {

+ e1.printStackTrace();

+ }

+ }

+ e.printStackTrace();

+ }

+

+ try {

+ conn.close();

+ } catch (SQLException e) {

+ e.printStackTrace();

+ }

+ }

+

+ public static Connection getConnect(String username, String passwd) {

+ // 驱动类

+ String driver = "org.postgresql.Driver";

+ // 数据库连接描述符

+ String sourceURL = "jdbc:postgresql://192.168.193.129:5432/finance";

+ Connection conn = null;

+

+ try {

+ // 加载驱动

+ Class.forName(driver);

+ } catch (Exception e) {

+ e.printStackTrace();

+ return null;

+ }

+

+ try {

+ // 创建连接

+ conn = DriverManager.getConnection(sourceURL, username, passwd);

+ System.out.println("Connection succeed!");

+ } catch (Exception e) {

+ e.printStackTrace();

+ return null;

+ }

+

+ return conn;

+ }

+}

+```

+

+NOTE:

+

+- 要执行什么操作就要赋予用户什么权限,代码中要对property表查询,故:`grant select on table property to luooofan;`

+

+- 因为CentOS没配置中文编码,所以直接在CentOS上查找的话应该无法显示中文,不过这并不影响在win 上远程连接然后查询并显示

+

+

+

+

+

+

+

+## References

+

+[openGauss Server&Connectors Official Download](https://opengauss.org/zh/download.html)

+

+[官方文档-快速入门](https://opengauss.org/zh/docs/2.0.1/docs/Quickstart/Quickstart.html)

+

+[官方文档-开发者指南](https://opengauss.org/zh/docs/2.0.1/docs/Developerguide/Developerguide.html)

+

+[openGauss数据库部署Linux遇到的问题](https://blog.csdn.net/RANGO_CSDN/article/details/118761322)

+

+[【数据库原理实验(openGauss)】 使用JDBC连接数据库](https://blog.csdn.net/BlacKingZ/article/details/117915010)

+

diff --git "a/content/zh/post/luooofan/openGauss\344\272\213\345\212\241\346\234\272\345\210\266-MVCC\346\212\200\346\234\257\347\232\204\345\256\236\347\216\260.md" "b/content/zh/post/luooofan/openGauss\344\272\213\345\212\241\346\234\272\345\210\266-MVCC\346\212\200\346\234\257\347\232\204\345\256\236\347\216\260.md"

new file mode 100644

index 0000000000000000000000000000000000000000..4ae8ddce50b0761fa50943aa845ea4e7329e7fcc

--- /dev/null

+++ "b/content/zh/post/luooofan/openGauss\344\272\213\345\212\241\346\234\272\345\210\266-MVCC\346\212\200\346\234\257\347\232\204\345\256\236\347\216\260.md"

@@ -0,0 +1,519 @@

++++

+title = "openGauss事务机制中MVCC技术的实现分析"

+date = "2021-11-27"

+tags = ["openGauss事务机制", "openGaussMVCC技术", "openGauss源码解析"]

+archives = "2021-11"

+author = "luooofan"

+summary = "分析openGauss2.0.1中MVCC技术的实现部分"

+img = "/zh/post/luooofan/title/openGauss.png"

++++

+

+# openGauss事务机制中MVCC技术的实现分析

+

+## 概述

+

+### 事务

+

+**事务**是为用户提供的最核心、最具吸引力的数据库功能之一。简单地说,事务是用户定义的一系列**数据库操作**(如查询、插入、修改或删除等)的**集合**,从数据库内部保证了该操作集合作为一个整体的原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)和持久性(Durability),这些特性统称事务的**ACID特性**。

+

+

+

+### DBMS中的并发控制

+

+并发控制旨在针对数据库中对**事务并行**的场景,保证 ACID 中的**一致性**(Consistency)与**隔离性**(Isolation)。数据库技术中主流的三种并发控制技术分别是: Multi-version Concurrency Control (MVCC), Strict Two-Phase Locking (S2PL), 以及 Optimistic Concurrency Control (OCC),每种技术也都有很多的变种。

+

+

+

+### MVCC

+

+MVCC的基本机制是:写事务不会原地修改元组内容,每次写操作都会在旧的版本之上创建新的版本,并且会保留旧的版本。当某个事务需要读取数据时,数据库系统会从所有的版本中选取出符合该事务隔离级别要求的版本。

+

+MVCC 的主要优点是读数据的锁请求与写数据的锁请求不冲突,以此来实现**读不阻塞写,写也不阻塞读**。

+

+

+

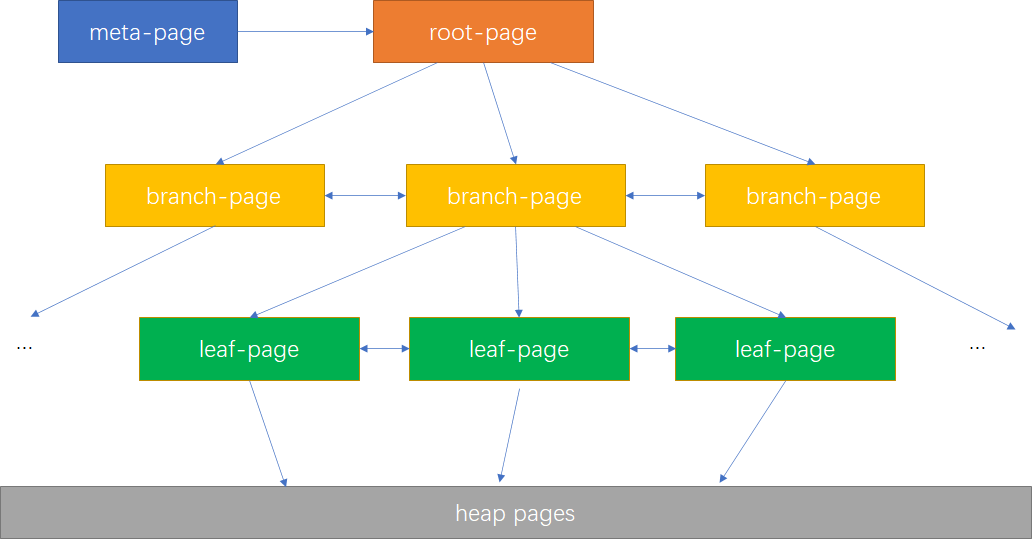

+### openGauss事务整体架构

+

+

+

+

+

+在openGauss中,事务的实现与存储引擎的实现有很强关联,代码主要集中在src/gausskernel/storage/access/transam及src/gausskernel/storage/lmgr下,关键文件如图所示。

+

+(1) 事务管理器:事务系统的中枢,它的实现是一个有限循环状态机,通过接受外部系统的命令并根据当前事务所处的状态决定事务的下一步执行过程。

+

+(2) 日志管理器:用来记录事务执行的状态以及数据变化的过程,包括事务提交日志(CLOG)、事务提交序列日志(CSNLOG)以及事务日志(XLOG)。其中CLOG日志只用来记录事务执行的结果状态,CSNLOG记录日志提交的顺序,用于可见性判断;XLOG是数据的redo日志,用于恢复及持久化。

+

+(3) 线程管理机制:通过一片内存区域记录所有线程的事务信息,任何一个线程可以通过访问该区域获取其他事务的状态信息。

+

+(4) MVCC机制:openGauss系统中,事务执行读流程结合各事务提交的CSN序列号,采用了多版本并发控制机制,实现了元组的读和写互不阻塞。

+

+(5) 锁管理器:实现系统的写并发控制,通过锁机制来保证事务写流程的隔离性。

+

+

+

+

+

+## MVCC的实现

+

+我们需要关注:

+

+- 元组版本号的实现

+- 快照的实现

+- 判断数据有效性、可见性、可更新性的算法的实现

+- 不同的隔离级别的实现

+

+### 多版本元组存储结构

+

+*src/include/access/htup.h*

+

+为了定义MVCC 中不同版本的数据,Opengauss在每个元组的头部信息HeapTupleHeaderData中引入了一些字段如下:

+

+```c++

+typedef struct HeapTupleHeaderData {

+ union {

+ HeapTupleFields t_heap; /* 存储该元组的一些描述信息 */

+ DatumTupleFields t_datum;

+ } t_choice;

+

+ ItemPointerData t_ctid; /* (块号,块内偏移) 存储用来记录当前元组或新元组的物理位置 */

+

+ /* Fields below here must match MinimalTupleData! */

+

+ uint16 t_infomask2;

+

+ uint16 t_infomask; /* various flag bits, see below */

+

+ uint8 t_hoff;

+

+ /* ^ - 23 bytes - ^ */

+

+ bits8 t_bits[FLEXIBLE_ARRAY_MEMBER];

+

+ /* MORE DATA FOLLOWS AT END OF STRUCT */

+} HeapTupleHeaderData;

+typedef HeapTupleHeaderData* HeapTupleHeader

+```

+

+HeapTupleFields

+

+```c++

+typedef struct HeapTupleFields {

+ ShortTransactionId t_xmin; /* 存放插入该 Tuple 时的 txid */

+ ShortTransactionId t_xmax; /* 存放删除或者更新该 Tuple 时的 txid,如果还没更新或者删除,那么置 0,表示无效 */

+

+ union {

+ CommandId t_cid; /* 创建或更新/删除该 Tuple 的命令在该事务内执行的所有 SQL 命令中的编号 */

+ ShortTransactionId t_xvac; /* old-style VACUUM FULL xact ID */

+ } t_field3;

+} HeapTupleFields;

+```

+

+t_infomask

+

+```c++

+#define HEAP_HASNULL 0x0001 /* has null attribute(s) */

+#define HEAP_HASVARWIDTH 0x0002 /* has variable-width attribute(s) */

+#define HEAP_HASEXTERNAL 0x0004 /* has external stored attribute(s) */

+#define HEAP_HASOID 0x0008 /* has an object-id field */

+#define HEAP_COMPRESSED 0x0010 /* has compressed data */

+#define HEAP_COMBOCID 0x0020 /* t_cid is a combo cid */

+#define HEAP_XMAX_EXCL_LOCK 0x0040 /* xmax is exclusive locker */

+#define HEAP_XMAX_SHARED_LOCK 0x0080 /* xmax is shared locker */

+/* if either LOCK bit is set, xmax hasn't deleted the tuple, only locked it */

+#define HEAP_IS_LOCKED (HEAP_XMAX_EXCL_LOCK | HEAP_XMAX_SHARED_LOCK)

+#define HEAP_XMIN_COMMITTED 0x0100 /* t_xmin committed */

+#define HEAP_XMIN_INVALID 0x0200 /* t_xmin invalid/aborted */

+#define HEAP_XMIN_FROZEN (HEAP_XMIN_INVALID | HEAP_XMIN_COMMITTED)

+#define HEAP_XMAX_COMMITTED 0x0400 /* t_xmax committed */

+#define HEAP_XMAX_INVALID 0x0800 /* t_xmax invalid/aborted */

+...

+```

+

+

+

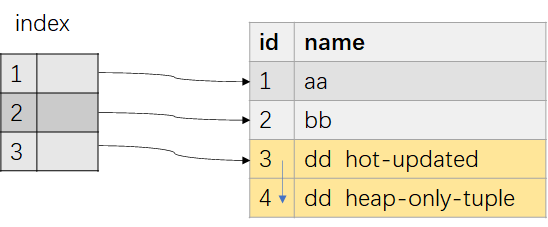

+### 插入、删除、更新元组

+

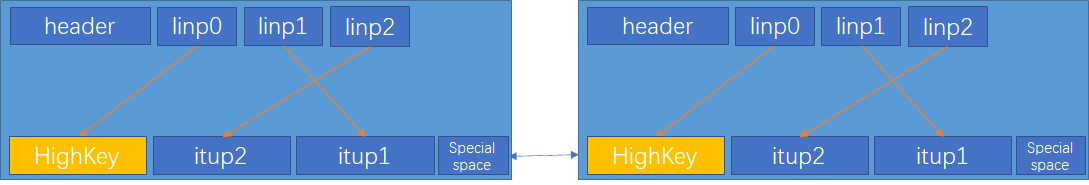

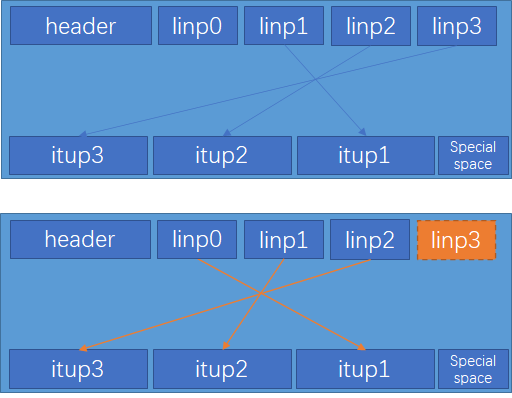

+#### 元组在页中是如何存放的

+

+

+

+

+

+#### 插入

+

+假设一个txid为99的事务插入一个元组

+

+

+

+#### 删除

+

+假设一个txid为111的事务删除一个元组

+

+

+

+#### 更新

+

+假设99号事务插入的元组被100号事务更新了两次

+

+

+

+openGauss通过HeapTupleHeaderData 的几个特殊的字段,给元组设置了不同的版本号,元组的每次更新操作都会产生一条新版本的元组,版本之间从旧到新形成了一条版本链(旧的ctid指向新的元组)。

+

+

+

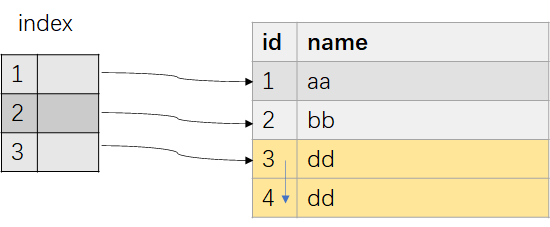

+### 事务快照的实现

+

+为了实现元组对事务的可见性判断,openGauss引入了事务快照SnapshotData

+

+在openGauss中,有两种方式来实现快照。

+

+#### (1)活跃事务数组方法

+

+在数据库进程中,维护一个**全局的数组**,其中的成员为**正在执行的事务信息**,包括事务的事务号,该数组即活跃事务数组。

+

+在每个事务开始的时候,复制一份该数组内容。

+

+当事务执行过程中扫描到某个元组时,需要通过判断元组xmin和xmax这两个事务对于查询事务的可见性,来决定该元组是否对查询事务可见。

+

+

+

+

+

+

+

+#### (2)时间戳方法

+

+

+

+在openGauss内部,使用一个全局自增的长整数作为逻辑的时间戳,模拟数据库内部的时序,该逻辑时间戳被称为提交顺序号(Commit Sequence Number,简称CSN)。

+

+每当一个事务提交的时候,在CSN日志中会记录该事务号 XID对应的逻辑时间戳 CSN 值。

+

+

+

+```c++

+#define COMMITSEQNO_INPROGRESS UINT64CONST(0x0) // 表示该事务还未提交或回滚

+#define COMMITSEQNO_ABORTED UINT64CONST(0x1) // 表示该事务已经回滚

+#define COMMITSEQNO_FROZEN UINT64CONST(0x2) // 表示该事务已提交,且对任何快照可见

+#define COMMITSEQNO_FIRST_NORMAL UINT64CONST(0x3) // 事务正常的CSN号起始值

+#define COMMITSEQNO_COMMIT_INPROGRESS (UINT64CONST(1) << 62) // 事务正在提交中

+```

+

+

+

+#### 事务快照数据结构SnapshotData

+

+*src/include/utils/snapshot.h*

+

+获取快照时会记录当前活跃的最小的xid,记为snapshot.xmin。当前最新提交的“事务id(latestCompleteXid) + 1”,记为snapshot.xmax。当前最新提交的“CSN号 + 1”(NextCommitSeqNo),记为snapshot.csn。

+

+```c++

+typedef struct SnapshotData {

+ SnapshotSatisfiesFunc satisfies; /* 判断可见性的函数;通常使用MVCC,即HeapTupleSatisfiesMVCC */

+ TransactionId xmin; /*当前活跃事务最小值,小于该值的事务说明已结束 */

+ TransactionId xmax; /*最新提交事务id(latestCompeleteXid)+1,大于等于改值说明事务还未开始,该事务id不可见 */

+ TransactionId* xip; /*记录当前活跃事务链表,在CSN版本中该值无用 */

+ TransactionId* subxip; /* 记录缓存子事务活跃链表,在CSN版本中该值无用 */

+ uint32 xcnt; /* 记录活跃事务的个数(xip中元组数)在CSN版本中该值无用 */

+ ...

+

+ CommitSeqNo snapshotcsn; /* 快照的CSN号,一般为最新提交事务的CSN号+1(NextCommitSeqNo),CSN号严格小于该值的事务可见。 */

+ ...

+

+ CommandId curcid; /*事务块中的命令序列号,即同一事务中,前面插入的数据,后面可见。 */

+ uint32 active_count; /* ActiveSnapshot stack的refcount */

+ uint32 regd_count; /* RegisteredSnapshotList 的refcount*/

+ void* user_data; /* 本地多版本快照使用,标记该快照还有线程使用,不能直接释放 */

+ SnapshotType snapshot_type; /* openGauss单机无用 */

+} SnapshotData;

+```

+

+satisfies是openGauss提供的对于事务可见性判断的统一操作接口。

+

+*src/gausskernel/storage/access/heap/heapam_visibility.c*

+

+- HeapTupleSatisfiesMVCC:判断元组对某一快照版本是否有效

+- HeapTupleSatisfiesUpdate:判断元组是否可更新

+- HeapTupleSatisfiesDirty:判断当前元组是否已脏

+- HeapTupleSatisfiesSelf:判断tuple对自身信息是否有效

+- HeapTupleSatisfiesToast:用于TOAST表(参考[文档](httpss://www.postgresql.org/docs/10/static/storage-toast.html))的判断

+- HeapTupleSatisfiesVacuum:用在VACUUM,判断某个元组是否对任何正在运行的事务可见,如果是,则该元组不能被VACUUM删除

+- HeapTupleSatisfiesAny:所有元组都可见

+- HeapTupleSatisfiesHistoricMVCC:用于CATALOG 表

+- ……

+

+

+

+#### MVCC可见性判断机制

+

+| 状态 | xmax对于查询可见 | xmax对于查询不可见 |

+| :----------------: | :--------------------------: | :--------------------------: |

+| xmin对于查询可见 | 记录不可见(先插入,后删除) | 记录可见(先插入,未删除) |

+| xmin对于查询不可见 | 不可能发生 | 记录不可见(未插入,未删除) |

+

+##### XidVisibleInSnapshot

+

+*src/gausskernel/storage/access/heap/heapam_visibility.c*

+

+```c++

+bool XidVisibleInSnapshot(TransactionId xid, Snapshot snapshot, TransactionIdStatus* hintstatus, Buffer buffer, bool* sync)

+{

+ bool looped = false;

+ *hintstatus = XID_INPROGRESS;

+ if (GTM_MODE && TransactionIdFollowsOrEquals(xid, snapshot->xmax)) {

+ return false;

+ }

+loop:

+ csn = TransactionIdGetCommitSeqNo(xid, false, true, false);

+ if (COMMITSEQNO_IS_COMMITTED(csn)) {

+ *hintstatus = XID_COMMITTED;

+ if (csn < snapshot->snapshotcsn)

+ return true;

+ else

+ return false;

+ } else if (COMMITSEQNO_IS_COMMITTING(csn)) {

+ ...

+ } else {

+ if (csn == COMMITSEQNO_ABORTED)

+ *hintstatus = XID_ABORTED;

+ return false;

+ }

+}

+```

+

+如果xid事务正在执行:

+

+```c++

+if (looped) {

+ ereport(DEBUG1, (errmsg("transaction id %lu's csn %ld is changed to ABORT after lockwait.", xid, csn)));

+ RecheckXidFinish(xid, csn);

+ CSNLogSetCommitSeqNo(xid, 0, NULL, COMMITSEQNO_ABORTED);

+ SetLatestFetchState(xid, COMMITSEQNO_ABORTED);

+ *hintstatus = XID_ABORTED;

+ return false;

+} else {

+ if (!COMMITSEQNO_IS_SUBTRANS(csn)) {

+ ...

+ CommitSeqNo latestCSN = GET_COMMITSEQNO(csn);

+ if (latestCSN >= snapshot->snapshotcsn) {

+ ...

+ return false;

+ }

+ } else {

+ parentXid = (TransactionId)GET_PARENTXID(csn);

+ }

+ ...

+ if (TransactionIdIsValid(parentXid))

+ SyncWaitXidEnd(parentXid, buffer);

+ else

+ SyncWaitXidEnd(xid, buffer);

+ looped = true;

+ parentXid = InvalidTransactionId;

+ goto loop;

+}

+```

+

+##### HeapTupleSatisfiesMVCC

+

+

+```c++

+static bool HeapTupleSatisfiesMVCC(HeapTuple htup, Snapshot snapshot, Buffer buffer)

+{

+ // 取元组头

+ HeapTupleHeader tuple = htup->t_data;

+ ...

+ // 根据hint bit,若xmin没有被标记为已提交:可能被标记为回滚,或者还未标记

+ if (!HeapTupleHeaderXminCommitted(tuple)) {

+ // 如果xmin已经被标记为invalid,说明插入该元组的事务已经回滚,直接返回不可见

+ if (HeapTupleHeaderXminInvalid(tuple))

+ return false;

+ // xmin还未标记,并且xmin为当前事务,说明是在同一个事务内的插入命令和扫描命令,则需要去判断CID

+ // 同一个事务内,后面的查询可以查到当前事务之前命令插入的并且未删除的结果

+ if (TransactionIdIsCurrentTransactionId(HeapTupleHeaderGetXmin(page, tuple))) {

+ if ((tuple->t_infomask & HEAP_COMBOCID) && CheckStreamCombocid(tuple, snapshot->curcid, page))

+ return true; /* delete after stream producer thread scan started */

+

+ // 当前扫描命令之后的某条命令才插入

+ if (HeapTupleHeaderGetCmin(tuple, page) >= snapshot->curcid)

+ return false; /* inserted after scan started */

+ // 到这里说明当前扫描命令之前已经插入

+ // 根据hint bit,xmax被标记为invalid

+ if (tuple->t_infomask & HEAP_XMAX_INVALID)

+ return true;

+

+ ...

+

+ // 当前扫描命令之后的某条命令删除了该元组

+ if (HeapTupleHeaderGetCmax(tuple, page) >= snapshot->curcid)

+ return true; /* deleted after scan started */

+ else

+ return false; /* deleted before scan started */

+ }

+ // xmin还没打标记,并且不是当前事务

+ else {

+ // 通过csnlog判断事务是否可见,并且返回该事务的最终提交状态

+ visible = XidVisibleInSnapshot(HeapTupleHeaderGetXmin(page, tuple), snapshot, &hintstatus, buffer, NULL);

+ // 如果该事务提交,则打上提交的hint bit用于加速判断

+ if (hintstatus == XID_COMMITTED)

+ SetHintBits(tuple, buffer, HEAP_XMIN_COMMITTED, HeapTupleHeaderGetXmin(page, tuple));

+ // 如果事务回滚,则打上回滚标记

+ if (hintstatus == XID_ABORTED) {

+ ...

+ SetHintBits(tuple, buffer, HEAP_XMIN_INVALID, InvalidTransactionId);

+ }

+ // 如果xmin不可见,则该元组不可见

+ if (!visible) {

+ ...

+ return false;

+ }

+ }

+ }

+ // 根据hint bit,若xmin已经被标记为已提交,则通过函数接口CommittedXidVisibleInSnapshot判断是否对本次快照可见

+ else {

+ /* xmin is committed, but maybe not according to our snapshot */

+ if (!HeapTupleHeaderXminFrozen(tuple) &&

+ !CommittedXidVisibleInSnapshot(HeapTupleHeaderGetXmin(page, tuple), snapshot, buffer)) {

+ if (...) {

+ return false; /* treat as still in progress */

+ }

+ }

+ }

+ // 到此为止认为xmin visible,继续判断xmax的可见性

+

+recheck_xmax:

+ // 根据hint bit,xmax已经被标记为invalid,即已经回滚

+ if (tuple->t_infomask & HEAP_XMAX_INVALID) /* xid invalid or aborted */

+ return true;

+

+ ... // 还有一些其他状态判断

+

+ // 根据hint bit,xmax没有被标记为commited

+ if (!(tuple->t_infomask & HEAP_XMAX_COMMITTED)) {

+ bool sync = false;

+ TransactionId xmax = HeapTupleHeaderGetXmax(page, tuple);

+

+ // 如果xmax为当前事务

+ if (TransactionIdIsCurrentTransactionId(HeapTupleHeaderGetXmax(page, tuple))) {

+ // 如果删除该元组的命令后发生于快照扫描时刻

+ if (HeapTupleHeaderGetCmax(tuple, page) >= snapshot->curcid)

+ return true; /* deleted after scan started */

+ else

+ return false; /* deleted before scan started */

+ }

+

+ visible = XidVisibleInSnapshot(HeapTupleHeaderGetXmax(page, tuple), snapshot, &hintstatus, buffer, &sync);

+ /*

+ * If sync wait, xmax may be modified by others. So we need to check xmax again after acquiring the page lock.

+ */

+ if (sync && (xmax != HeapTupleHeaderGetXmax(page, tuple))) {

+ goto recheck_xmax;

+ }

+ // 根据hintstatus在元组头部打标记 hint bit

+ if (hintstatus == XID_COMMITTED) {

+ SetHintBits(tuple, buffer, HEAP_XMAX_COMMITTED, HeapTupleHeaderGetXmax(page, tuple));

+ }

+ if (hintstatus == XID_ABORTED) {

+ ...

+ SetHintBits(tuple, buffer, HEAP_XMAX_INVALID, InvalidTransactionId);

+ }

+ if (!visible) {

+ if (...) {

+ if (sync && (xmax != HeapTupleHeaderGetXmax(page, tuple))) {

+ goto recheck_xmax;

+ }

+ return true; /* treat as still in progress */

+ }

+ }

+ }

+ // 根据hint bit,xmax被标记为commited

+ else {

+ /* xmax is committed, but maybe not according to our snapshot */

+ if (!CommittedXidVisibleInSnapshot(HeapTupleHeaderGetXmax(page, tuple), snapshot, buffer)) {

+ if (...) {

+ return true; /* treat as still in progress */

+ }

+ }

+ }

+ return false;

+}

+```

+

+

+

+

+

+

+

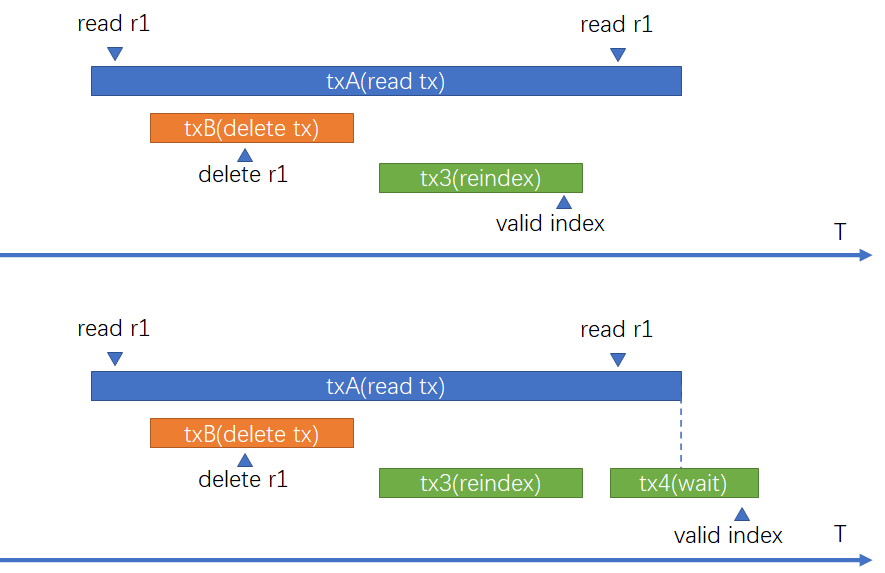

+### 隔离级别的实现

+

+| 隔离级别 | P0:脏写 | P1:脏读 | P4:更新丢失 | P2:不可重复读 | P3:幻读 | A5A:读偏斜 | A5B:写偏斜 |

+| ------------ | -------- | -------- | ----------- | -------------- | ------- | ---------- | ---------- |

+| 读未提交 | 不可能 | 可能 | 可能 | 可能 | 可能 | 可能 | 可能 |

+| 读已提交 | 不可能 | 不可能 | 可能 | 可能 | 可能 | 可能 | 可能 |

+| 可重复读 | 不可能 | 不可能 | 不可能 | 不可能 | 可能 | 不可能 | 不可能 |

+| 快照一致性读 | 不可能 | 不可能 | 不可能 | 不可能 | 偶尔 | 不可能 | 可能 |

+| 可串行化 | 不可能 | 不可能 | 不可能 | 不可能 | 不可能 | 不可能 | 不可能 |

+

+(1)**脏写(dirty write)**:两个事务分别写入,两个事务分别提交或回滚,则事务的结果无法确定,即一个事务可以回滚另一个事务的提交。

+

+(2)**脏读(dirty read)**:一个事务可以读取另一个事务未提交的修改数据。

+

+(3)**不可重复读(fuzzy read)**:一个事务重复读取前面读取过的数据,数据的结果被另外的事务修改。

+

+(4)**幻读(phantom)**:一个事务重复执行范围查询,返回一组符合条件的数据,每次查询的结果集因为其他事务的修改发生改变(条数)。

+

+(5)**更新丢失(lost update)**:一个事务在读取元组并更新该元组的过程中,有另一个事务修改了该元组的值,导致最终这次修改丢失。

+

+(6)**读偏斜(read skew)**:假设数据x,y有隐式的约束x+y=100;事务一读取x=50;事务二写x=25并更新y=75保证约束成立,事务二提交,事务一再读取y=75,导致事务一中读取x+y=125,不满足约束。

+

+(7)**写偏斜(write skew)**:假设数据x,y有隐式的约束x+y<=100;事务一读取x=50,并写入y=50;事务二读取y=30并写入x=70,并提交;事务一再提交;最终导致x=70,y=50不满足x+y<=100的约束。

+

+

+

+隔离级别越高,在一个事务执行过程中,它能“感知”到的并发事务的影响越小。在最高的可串行化隔离级别下,任意一个事务的执行,均“感知”不到有任何其他并发事务执行的影响,并且所有事务执行的效果就和一个个顺序执行的效果完全相同。

+

+在openGauss中,隔离级别的实现基于MVCC和快照机制,因此这种隔离方式被称为快照隔离(`Snapshot Isolation`,SI)。目前,openGauss支持读已提交和可重复读这两种隔离级别。两者实现上的差别在于在一个事务中获取快照的次数。(在实现上可重复读隔离级别无幻读问题,有A5B写偏斜问题)

+

+

+如果采用读已提交的隔离级别,那么在一个事务块中每条语句的执行开始阶段,都会去获取一次最新的快照,从而可以看到那些在本事务块开始以后、在前面语句执行过程中提交的并发事务的效果。

+

+如果采用可重复读的隔离级别,那么在一个事务块中,只会在第一条语句的执行开始阶段,获取一次快照,后面执行的所有语句都会采用这个快照,整个事务块中的所有语句均不会看到该快照之后提交的并发事务的效果。

+

+

+

+

+

+

+

+## 总结

+- **元组版本号的实现**:使用元组头部信息的字段来标示元组的版本号

+- **快照的实现**:活跃事务数组方法和时间戳方法

+- **判断数据有效性、可见性、可更新性的算法的实现**: `XidVisibleInSnapshot`和`HeapTupleSatisfiesMVCC`

+- **不同隔离级别的实现**:在一个事务中获取快照的次数

+

+

+

+## 参考资料

+

+[知乎:openGauss数据库源码解析系列文章](https://www.zhihu.com/column/c_1358363246349635584)

+

+[CSDN:openGauss事务机制](https://blog.csdn.net/GaussDB/article/details/116058155)

+

+[The Internals of PostgreSQL](https://www.interdb.jp/pg/pgsql05.html)

+

+[PgSQL · 特性分析 · MVCC机制浅析](http://mysql.taobao.org/monthly/2017/10/01)

+

+[PosrgreSQL 学习计划——Vacuum 清理机制](https://blog.yasking.org/a/postgresql-vacuum.html)

+

+[PostgreSql pageinspect 更深的理解PG](https://www.modb.pro/db/24577)

+

+[openGauss的MVCC以及vacuum机制源码解析—CSN LOG](https://blog.opengauss.org/zh/post/minshengyunwei/opengauss%E7%9A%84mvcc%E4%BB%A5%E5%8F%8Avacuum%E6%9C%BA%E5%88%B6%E6%BA%90%E7%A0%81%E8%A7%A3%E6%9E%90csn-log/)

+

+[浅谈数据库并发控制 - 锁和 MVCC](https://draveness.me/database-concurrency-control/)

+

+[PostgreSQL MVCC可见性判断](https://cloud.tencent.com/developer/article/1598195)

+

+

+

+

diff --git a/content/zh/post/luooofan/title/openGauss.png b/content/zh/post/luooofan/title/openGauss.png

new file mode 100644

index 0000000000000000000000000000000000000000..86a420b92fb8289658d807d49f137b6d13862f6d

Binary files /dev/null and b/content/zh/post/luooofan/title/openGauss.png differ

diff --git a/content/zh/post/luooofan/title/title1.png b/content/zh/post/luooofan/title/title1.png

new file mode 100644

index 0000000000000000000000000000000000000000..830c8bc490a1b830e759df1f04b453909a097406

Binary files /dev/null and b/content/zh/post/luooofan/title/title1.png differ

diff --git "a/content/zh/post/luoyuchen/OpenGauss\346\225\260\346\215\256\345\272\223\345\256\211\350\243\205\344\270\216\344\275\277\347\224\250.md" "b/content/zh/post/luoyuchen/OpenGauss\346\225\260\346\215\256\345\272\223\345\256\211\350\243\205\344\270\216\344\275\277\347\224\250.md"

new file mode 100644

index 0000000000000000000000000000000000000000..6d3397d9c001bfe0427f35d6dd84d63e78b1b14c

--- /dev/null

+++ "b/content/zh/post/luoyuchen/OpenGauss\346\225\260\346\215\256\345\272\223\345\256\211\350\243\205\344\270\216\344\275\277\347\224\250.md"

@@ -0,0 +1,224 @@

++++

+

+title = "OpenGauss数据库安装与使用"

+

+date = "2021-11-27"

+

+tags = ["OpenGauss数据库安装与使用"]

+

+archives = "2021-11"

+

+author = "罗宇辰"

+

+summary = "OpenGauss数据库安装与使用"

+

+img = "/zh/post/luoyuchen/title/1.png"

+

+times = "13:50"

+

++++

+

+# OpenGauss数据库安装与使用报告

+

+### 1.获取openGauss安装包

+

+在 https://opengauss.org/zh/download.html 官网上下载安装包

+

+

+

+这里我安装的是极简版。

+

+

+

+### 2.CentOS设置

+

+####1)CentOS版本

+CentOS7

+

+

+####2)centos网络连接设置

+>cd /etc/sysconfig/network-scripts #进入网络配置文件目录

+ls #找到目录下第一个文件

+vi 文件名 #用vi修改配置

+

+

+最后一行改为yes。

+>service network restart #重启网卡,使配置生效

+

+####3)yum安装图形化界面(非必须)

+>yum groupinstall -y "GNOME Desktop"

+

+安装完重启。在命令行界面输入

+>startx

+

+进入图形化界面。

+

+

+####4)配置yum源

+

+####5)yum安装依赖的软件包

+以下环境配置均参考 https://zhuanlan.zhihu.com/p/402928515

+>yum install libaio-devel flex bison ncurses-devel glibc-devel patch redhat-lsb-core readline-devel -y

+

+####6)关闭防火墙

+

+>systemctl status firewalld

+systemctl disable firewalld.service

+systemctl stop firewalld.service

+

+

+####7)关闭SELinux

+

+>sed -i '/SELINUX=/d' /etc/selinux/config

+echo "SELINUX=disabled" >> /etc/selinux/config

+cat /etc/selinux/config|grep -v ^#|grep -v '^$'

+

+

+

+####8)设置时区

+

+>rm -fr /etc/localtime

+ln -s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

+ll /etc/localtime

+

+

+

+####9)关闭swap

+修改分区表文件,删除SWAP挂载信息

+>cp /etc/fstab /etc/fstab.bak

+sed -i '/swap/s/^/#/' /etc/fstab

+cat /etc/fstab|grep -v ^#|grep -v '^$'

+

+关闭swap

+>swapoff -a

+

+####10)创建dbgrp的组,创建新用户omm并授权

+

+>groupadd -g 1001 dbgrp

+useradd -u 2001 -g dbgrp omm

+chown -R omm:dbgrp /opt

+

+####11)配置操作系统内核参数

+

+>cat >> /etc/sysctl.conf << EOF

+net.ipv4.tcp_max_tw_buckets = 10000

+net.ipv4.tcp_tw_reuse = 1

+net.ipv4.tcp_tw_recycle = 1

+net.ipv4.tcp_keepalive_time = 30

+net.ipv4.tcp_keepalive_probes = 9

+net.ipv4.tcp_keepalive_intvl = 30

+net.ipv4.tcp_retries1 = 5

+net.ipv4.tcp_syn_retries = 5

+net.ipv4.tcp_synack_retries = 5

+net.ipv4.tcp_retries2 = 12

+vm.overcommit_memory = 0

+net.ipv4.tcp_rmem = 8192 250000 16777216

+net.ipv4.tcp_wmem = 8192 250000 16777216

+net.core.wmem_max = 21299200

+net.core.rmem_max = 21299200

+net.core.wmem_default = 21299200

+net.core.rmem_default = 21299200

+net.ipv4.ip_local_port_range = 26000 65535

+kernel.sem = 250 6400000 1000 25600

+vm.min_free_kbytes = 102400 ##suggest to set as physical memory * 5%

+net.core.somaxconn = 65535

+net.ipv4.tcp_syncookies = 1

+net.core.netdev_max_backlog = 65535

+net.ipv4.tcp_max_syn_backlog = 65535

+net.ipv4.tcp_fin_timeout = 60

+kernel.shmall = 1152921504606846720

+kernel.shmmax = 18446744073709551615

+net.ipv4.tcp_sack = 1

+net.ipv4.tcp_timestamps = 1

+vm.extfrag_threshold = 500

+vm.overcommit_ratio = 90

+EOF

+sysctl -p

+

+###3.安装OpenGauss

+####1)创建用于安装openGauss的文件夹

+>mkdir -p /opt/software/openGauss

+

+将本机上下载的xxx.tar.bz2拖动到图形化界面中的任意文件夹

+右键打开properties找到压缩包所在位置

+

+

+)

+

+解压到创建的文件夹

+>cd /home/louie

+tar -jxf openGauss-2.0.1-CentOS-64bit.tar.bz2 -C /opt/software/openGauss/

+

+####2)安装OpenGauss

+进入解压好的文件夹中

+>cd /opt/software/openGauss/simpleInstall/

+

+根据文件夹中readme文件中的指导开始安装

+>sh install.sh -w gauss@123

+

+极简版采用安装脚本

+

+

+####3)安装成功

+

+

+###4.OpenGauss使用测试

+####1)加入PATH

+

+

+####2)连接默认数据库测试

+

+

+####3)创建新数据库test(指令后要加分号)

+

+####4)测试直接建表

+

+####5)测试使用JDBC连接数据库

+Ifconfig命令查找安装opengauss的虚拟机所在IP地址(inet后面的地址)

+

+根据找到的ip地址修改pg_hba.conf文件

+

+

+在原电脑编写测试连接的java文件,例如openGaussDemo.java

+

+配置好jdk,解压下载好的jdbc,获得postgresql.jar文件。

+将postgresql.jar openGaussDemo.java放在同一文件夹中,在cmd中进入该目录,执行:

+>javac -encoding utf-8 -cp d:\Download\postgresql.jar openGaussDemo.java

+

+编译java文件。

+再执行:

+>java -cp .;D:/Download/postgresql.jar openGaussDemo

+

+运行测试代码。

+

+连接成功。

+

+###5.过程中遇到的问题

+####1)安装step1报错

+

+解决:不能在root下进行安装。

+

+####2)安装step2报错

+

+解决:在/etc/sysctl.conf中加入语句kernel.sem = 250 32000 100 999,然后执行sysctl -p。

+实际上这个报错是在没有进行系统内核参数修改时出现的,执行完上面centos的环境配置后可以一步到位。

+

+####3)step3报错

+解决:需要用chown -R 用户名:dbgrp /opt授权。

+

+####4)创建用户组dbgrp时报错

+

+解决:在root下操作

+

+####5)测试新建数据库,发现没完成指令。

+解决:sql指令后加分号。

+

+####6)虚拟机卡死

+原因:原先设置的分配虚拟机内存为2G,估计是安装了centos的图形化界面,导致卡死。

+解决:虚拟机分配4G内存。

+

+####7)jdbc连接虚拟机上的数据库报错:FATAL: Forbid remote connection with trust method!

+

+解决:参考https://bbs.huaweicloud.com/forum/thread-102401-1-1.html

+进入安装目录中/opt/software/openGauss/data/single_node中修改pg_hba.conf 将其中trust改为sha56

+

diff --git a/content/zh/post/luoyuchen/figures/1.png b/content/zh/post/luoyuchen/figures/1.png

new file mode 100644

index 0000000000000000000000000000000000000000..c0766c878d2df76297a0e599c3ab07e75a417d07

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/1.png differ

diff --git a/content/zh/post/luoyuchen/figures/10.png b/content/zh/post/luoyuchen/figures/10.png

new file mode 100644

index 0000000000000000000000000000000000000000..69e422b7b8214227b629a82e035162bc14e64a8b

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/10.png differ

diff --git a/content/zh/post/luoyuchen/figures/11.png b/content/zh/post/luoyuchen/figures/11.png

new file mode 100644

index 0000000000000000000000000000000000000000..5945694fed68c166e904226a943b9fd35edd29cd

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/11.png differ

diff --git a/content/zh/post/luoyuchen/figures/12.png b/content/zh/post/luoyuchen/figures/12.png

new file mode 100644

index 0000000000000000000000000000000000000000..eb8899c31a96abba83da4970853e9545a3fb6b55

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/12.png differ

diff --git a/content/zh/post/luoyuchen/figures/13.png b/content/zh/post/luoyuchen/figures/13.png

new file mode 100644

index 0000000000000000000000000000000000000000..805876c5700b4be674aa04e21d3576b4c795ee06

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/13.png differ

diff --git a/content/zh/post/luoyuchen/figures/14.png b/content/zh/post/luoyuchen/figures/14.png

new file mode 100644

index 0000000000000000000000000000000000000000..5eb07059426f68c0a9d4f3d1145fb8f6cd6dbbdb

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/14.png differ

diff --git a/content/zh/post/luoyuchen/figures/15.png b/content/zh/post/luoyuchen/figures/15.png

new file mode 100644

index 0000000000000000000000000000000000000000..17c54ce53e7b79b4123f6419f0224b37055f82f6

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/15.png differ

diff --git a/content/zh/post/luoyuchen/figures/16.png b/content/zh/post/luoyuchen/figures/16.png

new file mode 100644

index 0000000000000000000000000000000000000000..66d6879f5ce8d2c83e25ac7151fdaed56a38de9f

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/16.png differ

diff --git a/content/zh/post/luoyuchen/figures/17.png b/content/zh/post/luoyuchen/figures/17.png

new file mode 100644

index 0000000000000000000000000000000000000000..4a1b24758f9544c97781b3c3503ed0c16e45f914

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/17.png differ

diff --git a/content/zh/post/luoyuchen/figures/18.png b/content/zh/post/luoyuchen/figures/18.png

new file mode 100644

index 0000000000000000000000000000000000000000..b27712a4a64a44c8379feaff8a52cc69bb7c998f

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/18.png differ

diff --git a/content/zh/post/luoyuchen/figures/19.png b/content/zh/post/luoyuchen/figures/19.png

new file mode 100644

index 0000000000000000000000000000000000000000..a078bbb82adcd494f07b7009f2f4a75fdf556163

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/19.png differ

diff --git a/content/zh/post/luoyuchen/figures/2.png b/content/zh/post/luoyuchen/figures/2.png

new file mode 100644

index 0000000000000000000000000000000000000000..10d6d32ae5b14ad677bdd217885016a5dc7c2916

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/2.png differ

diff --git a/content/zh/post/luoyuchen/figures/20.png b/content/zh/post/luoyuchen/figures/20.png

new file mode 100644

index 0000000000000000000000000000000000000000..e002e0d1f13249320275e92412a3af39b0924629

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/20.png differ

diff --git a/content/zh/post/luoyuchen/figures/21.png b/content/zh/post/luoyuchen/figures/21.png

new file mode 100644

index 0000000000000000000000000000000000000000..b3d07f93b0d98b1b6cb243c58edb291271ff1bdd

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/21.png differ

diff --git a/content/zh/post/luoyuchen/figures/22.png b/content/zh/post/luoyuchen/figures/22.png

new file mode 100644

index 0000000000000000000000000000000000000000..96dd498496327339586b2e4594895a1edfefb85e

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/22.png differ

diff --git a/content/zh/post/luoyuchen/figures/23.png b/content/zh/post/luoyuchen/figures/23.png

new file mode 100644

index 0000000000000000000000000000000000000000..682fdee0c0b6cc2c89657cf3a1f21545cc56c9de

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/23.png differ

diff --git a/content/zh/post/luoyuchen/figures/24.png b/content/zh/post/luoyuchen/figures/24.png

new file mode 100644

index 0000000000000000000000000000000000000000..42f2e9faebb879437ebf58590f28b5edb198cad7

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/24.png differ

diff --git a/content/zh/post/luoyuchen/figures/25.png b/content/zh/post/luoyuchen/figures/25.png

new file mode 100644

index 0000000000000000000000000000000000000000..11deb6e9af9c641d7cc70347ddb34a09ea78eafe

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/25.png differ

diff --git a/content/zh/post/luoyuchen/figures/26.png b/content/zh/post/luoyuchen/figures/26.png

new file mode 100644

index 0000000000000000000000000000000000000000..14aba54c7481132a8cda88ba7b3394ca3fc94a11

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/26.png differ

diff --git a/content/zh/post/luoyuchen/figures/3.png b/content/zh/post/luoyuchen/figures/3.png

new file mode 100644

index 0000000000000000000000000000000000000000..af1466ae5403bbc6518a7cb055c264a520480e5c

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/3.png differ

diff --git a/content/zh/post/luoyuchen/figures/4.png b/content/zh/post/luoyuchen/figures/4.png

new file mode 100644

index 0000000000000000000000000000000000000000..f4484aba9a466b5e791e3321e6ac1c8c1a824822

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/4.png differ

diff --git a/content/zh/post/luoyuchen/figures/5.png b/content/zh/post/luoyuchen/figures/5.png

new file mode 100644

index 0000000000000000000000000000000000000000..f3081daf3d83a2651860ed40ccd30273d15a357d

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/5.png differ

diff --git a/content/zh/post/luoyuchen/figures/6.png b/content/zh/post/luoyuchen/figures/6.png

new file mode 100644

index 0000000000000000000000000000000000000000..f8da3a74ec63049cc77041c8a6e98897f6c2b930

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/6.png differ

diff --git a/content/zh/post/luoyuchen/figures/7.png b/content/zh/post/luoyuchen/figures/7.png

new file mode 100644

index 0000000000000000000000000000000000000000..b83661e7e305e5c5d46d34442a0ab16e6459a411

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/7.png differ

diff --git a/content/zh/post/luoyuchen/figures/8.png b/content/zh/post/luoyuchen/figures/8.png

new file mode 100644

index 0000000000000000000000000000000000000000..d8c8b63c703e5594927717fe996ef7b6cb13ea10

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/8.png differ

diff --git a/content/zh/post/luoyuchen/figures/9.png b/content/zh/post/luoyuchen/figures/9.png

new file mode 100644

index 0000000000000000000000000000000000000000..247beb379fe0380a01392b7620dc52f5aaa88714

Binary files /dev/null and b/content/zh/post/luoyuchen/figures/9.png differ

diff --git a/content/zh/post/luoyuchen/title/1.png b/content/zh/post/luoyuchen/title/1.png

new file mode 100644

index 0000000000000000000000000000000000000000..c0766c878d2df76297a0e599c3ab07e75a417d07

Binary files /dev/null and b/content/zh/post/luoyuchen/title/1.png differ

diff --git a/content/zh/post/mingruifu/image/1.jpg b/content/zh/post/mingruifu/image/1.jpg

new file mode 100644

index 0000000000000000000000000000000000000000..0b7fac59c9955d78d6b0d8b9a8dc99e37adafbed

Binary files /dev/null and b/content/zh/post/mingruifu/image/1.jpg differ

diff --git a/content/zh/post/mingruifu/image/2.jpg b/content/zh/post/mingruifu/image/2.jpg

new file mode 100644

index 0000000000000000000000000000000000000000..7870fdeea0c60f5f7b6f996cecaec49017d101cf

Binary files /dev/null and b/content/zh/post/mingruifu/image/2.jpg differ

diff --git "a/content/zh/post/mingruifu/openGauss\345\256\211\350\243\205\345\271\266\344\275\277\347\224\250DataStudio\345\267\245\345\205\267\350\277\236\346\216\245\344\275\277\347\224\250.md" "b/content/zh/post/mingruifu/openGauss\345\256\211\350\243\205\345\271\266\344\275\277\347\224\250DataStudio\345\267\245\345\205\267\350\277\236\346\216\245\344\275\277\347\224\250.md"

new file mode 100644

index 0000000000000000000000000000000000000000..ebace71b4dc5843b45bd8d33a7740dd983e6ae3e

--- /dev/null

+++ "b/content/zh/post/mingruifu/openGauss\345\256\211\350\243\205\345\271\266\344\275\277\347\224\250DataStudio\345\267\245\345\205\267\350\277\236\346\216\245\344\275\277\347\224\250.md"

@@ -0,0 +1,177 @@

++++

+title = "本地安装单机版openGauss并使用DataStudio工具连接使用"

+date = "2021-12-20"

+tags = ["openGauss安装及DataStudio工具简单使用"]

+archives = "2021-12"

+author = "mingruifu"

+summary = "openGauss安装及DataStudio工具简单使用"

+img="/zh/post/mingruifu/title/title1.png"

+times = "11:30"

++++

+

+### 1.虚拟机的安装

+

+#### 1.1安装virtualbox

+

+1. 访问[https://www.virtualbox.org/wiki/Downloads](https://www.virtualbox.org/wiki/Downloads) 安装对应平台的版本

+2. 按照提示步骤安装好virtualbox环境

+

+#### 1.2安装vagrant

+

+1. 访问[https://www.vagrantup.com/downloads](https://www.vagrantup.com/downloads) 安装对应平台的vagrant

+

+2. 按照提示步骤安装好vagrant环境

+

+3. 执行`vagrant -v`,显示如下信息,则安装成功

+

+ ```shell

+ Vagrant 2.2.19

+ ```

+

+#### 1.3安装centos7

+

+1. 建立一个文件夹创建虚拟机环境

+

+2. 使用国内镜像源初始化Vagrantfile文件

+

+ ```shell

+ vagrant init centos7 https://mirrors.ustc.edu.cn/centos-cloud/centos/7/vagrant/x86_64/images/CentOS-7.box

+ ```

+

+3. 修改Vagrantfile文件,配置虚拟机

+

+```ruby

+Vagrant.configure("2") do |config|

+ # 镜像名称

+ config.vm.box = "centos7"

+ # 国内镜像源

+ config.vm.box_url = "https://mirrors.ustc.edu.cn/centos-cloud/centos/7/vagrant/x86_64/images/CentOS-7.box"

+ # 使用公共网络

+ config.vm.network "public_network"

+ config.vm.provider "virtualbox" do |vb|

+ # 配置虚拟机名称

+ vb.name = "openGauss"

+ # 配置虚拟机cpu个数

+ vb.cpus = 2

+ # 配置虚拟机内存

+ vb.memory = 1024

+ end

+end

+```

+

+ 4.启动并进入虚拟机

+

+```shell

+# 启动虚拟机

+vagrant up

+# 进入虚拟机

+vagrant ssh

+# 关闭防火墙

+systemctl disable firewalld.service

+systemctl stop firewalld.service

+# 关闭SELinux

+sed -i s/SELINUX=.*/SELINUX=disabled/ /etc/selinux/config

+# 将各数据库节点的字符集设置为相同的字符集,可以在/etc/profile文件中添加“export LANG=XXX”(XXX为Unicode编码)

+vim /etc/profile

+# 关闭交换内存

+swapoff -a

+# 更新yum

+yum -y update

+# 清除缓存

+yum clean all

+# 安装openjdk

+yum install -y java-1.8.0-openjdk-1.8.0.212.b04-0.el7_6.x86_64

+yum install -y java-1.8.0-openjdk-devel-1.8.0.212.b04-0.el7_6.x86_64

+# 配置jdk环境变量

+vi /etc/profile

+export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.212.b04-0.el7_6.x86_64

+export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

+export PATH=$PATH:$JAVA_HOME/bin

+# 生效环境变量

+source /etc/profile

+# 重启虚拟机

+vagrant reload

+```

+

+### 2.安装单机版openGauss

+

+1. 访问`https://opengauss.org/zh/download.html`下载`openGauss_2.1.0 极简版`

+2. 使用vagrant用户安装openGauss

+

+```shell

+# 将安装包放在Vagrantfile同级目录,并重启虚拟机

+vagrant reload

+#进入安装包所在目录

+cd /vagrant

+# 解压openGauss压缩包到安装目录

+tar -jxf openGauss-2.1.0-CentOS-64bit.tar.bz2 -C /opt/openGauss

+# 进入解压后目录下的simpleInstall

+cd /opt/openGauss/simpleInstall

+# 执行install.sh脚本安装openGauss

+sh install.sh -w test@123 -p 40200

+-w 初始化密码

+-p 指定端口 默认5432

+# 使用如下命令连接数据库

+gs_ctl start|stop|restart -D $GAUSSHOME/data/single_node -Z single_node

+```

+

+> 执行时,如果出现报错“the maximum number of SEMMNI is not correct, the current SEMMNI is xxx. Please check it.”,请使用有root权限的用户执行如下命令 。

+

+```shell

+sysctl -w kernel.sem="250 85000 250 330"

+```

+

+3. 修改`/opt/openGauss/data/single_node/pg_hba.conf`文件

+

+```shell

+# 在文件末尾追加客户端host认证方式

+host all all 0.0.0.0/0 sha256

+```

+

+4. 修改`/opt/openGauss/data/single_node/postgresql.conf`文件

+

+```shell

+# 将监听地址设置为*或者指定的客户端ip地址

+listen_addresses = '*'

+```

+

+5. 重启数据库

+

+```shell

+cd /opt/openGauss/bin

+# 重启数据库

+./gs_ctl restart -D /opt/openGauss/data/single_node/ -Z single_node

+```

+

+6. 连接数据库,创建用户

+

+```shell

+# 连接数据库

+/opt/openGauss/bin/gsql -d postgres -p 40200 -W 'test@123' -r

+# 创建一个用户

+create role test with createddb password "test@1234";

+# 创建数据库

+create database testdb owner test;

+# 授予用户对数据库的全部权限

+grant all privileges on database testdb to test;

+# 授予该用户管理员权限

+grant all privileges to test;

+```

+

+7. 使用新用户连接数据库

+

+```shell

+/opt/openGauss/bin/gsql -d postgres -p 40200 -U test -W 'test@123' -r

+```

+

+### 3.下载安装DataStudio

+

+1. 访问[https://opengauss.org/zh/download.html](https://opengauss.org/zh/download.html) 下载DataStudio_2.1.0

+2. 打开DataStudio连接数据库

+

+3. 连接上之后可以看见DataStudio的功能操作界面

+

+- 1:工具栏菜单

+- 2:数据库对象浏览器

+- 3:数据库操作终端,书写业务sql

+- 4: sql助手

diff --git a/content/zh/post/mingruifu/title/title1.png b/content/zh/post/mingruifu/title/title1.png

new file mode 100644

index 0000000000000000000000000000000000000000..70953c80a88ba62ea617a60b8527e6e739a8f9ea

Binary files /dev/null and b/content/zh/post/mingruifu/title/title1.png differ

diff --git "a/content/zh/post/mqq/OpenGauss SQL\350\247\243\346\236\220\346\272\220\347\240\201\345\210\206\346\236\220.md" "b/content/zh/post/mqq/OpenGauss SQL\350\247\243\346\236\220\346\272\220\347\240\201\345\210\206\346\236\220.md"

new file mode 100644

index 0000000000000000000000000000000000000000..1d1b4fb6d393f5e15e72dead837b0ba6fbaae43b

--- /dev/null

+++ "b/content/zh/post/mqq/OpenGauss SQL\350\247\243\346\236\220\346\272\220\347\240\201\345\210\206\346\236\220.md"

@@ -0,0 +1,186 @@

++++

+title = "OpenGauss SQL解析源码分析"

+date = "2021-11-27"

+tags = ["OpenGauss SQL解析源码分析"]

+archives = "2021-11"

+author = "mqq"

+summary = "OpenGauss SQL解析源码分析"

+img = "/zh/post/mqq/title/title.png"

++++

+

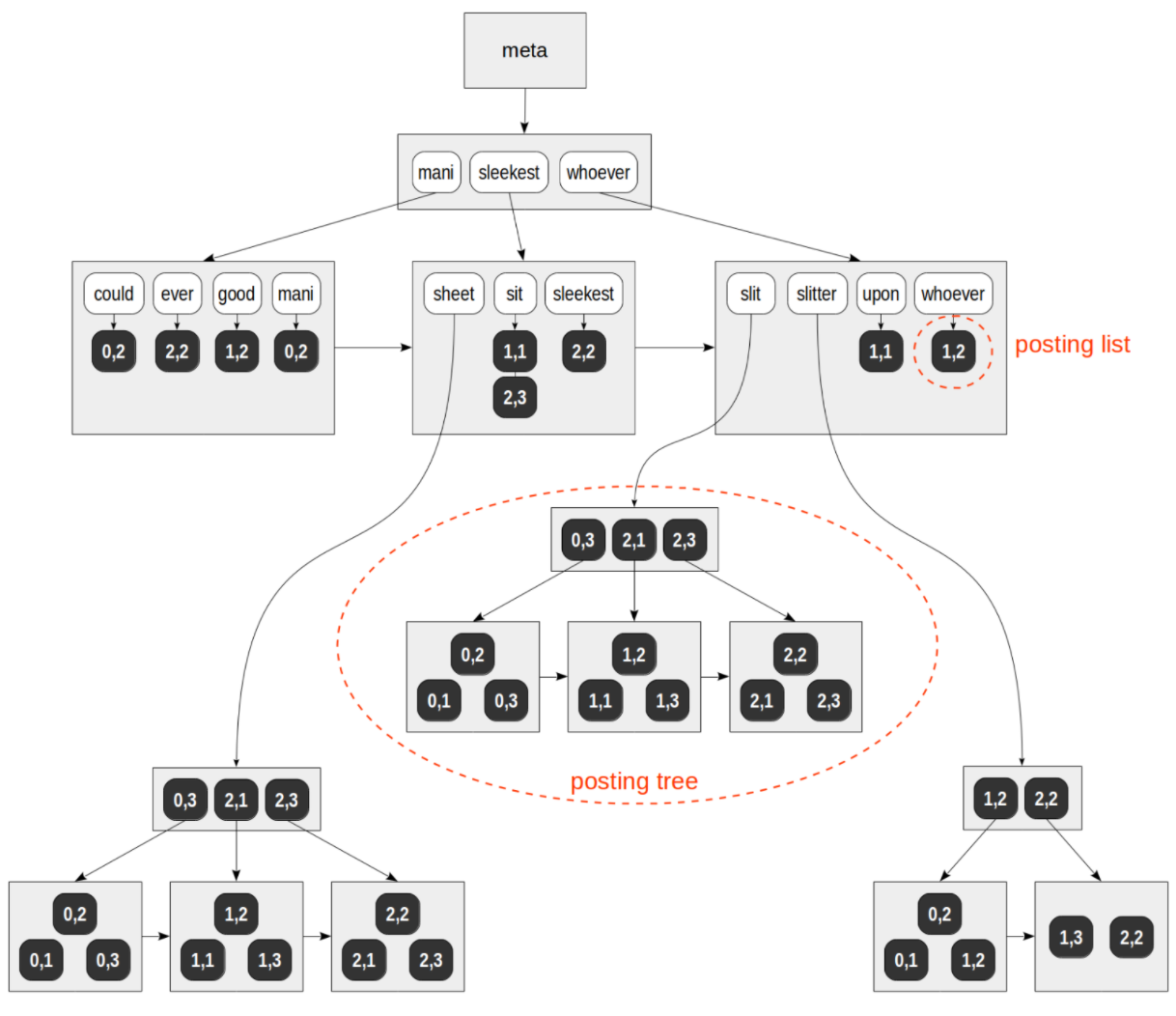

+# OpenGauss SQL解析源码分析

+

+

+## SQL 引擎简介:

+

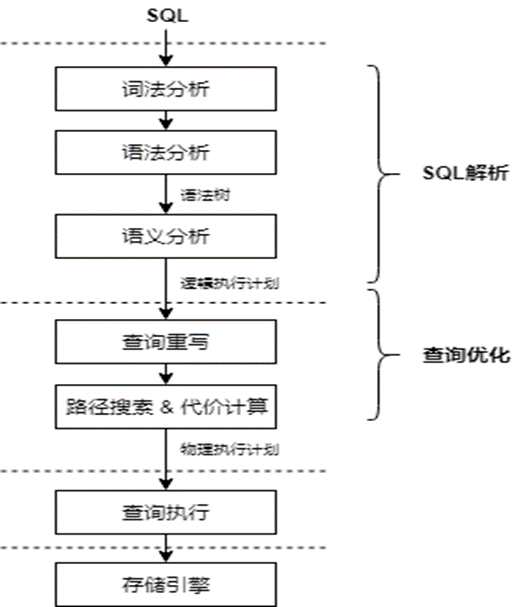

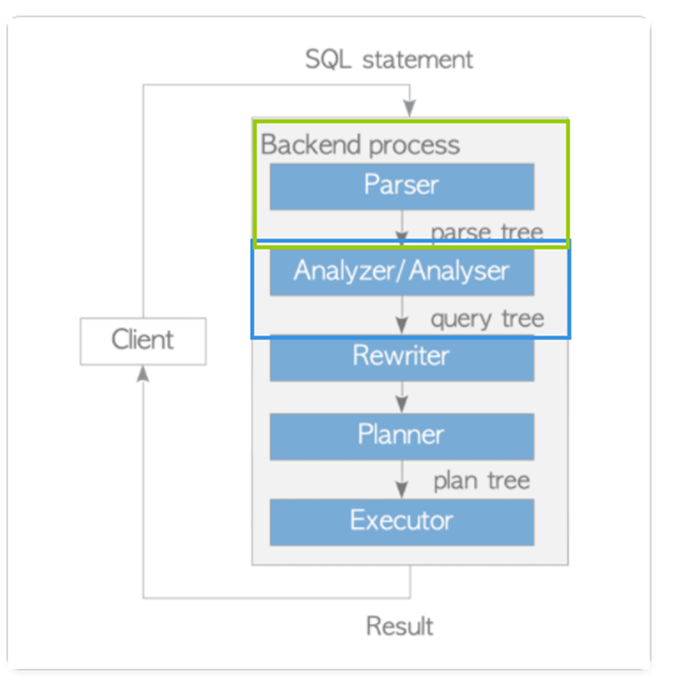

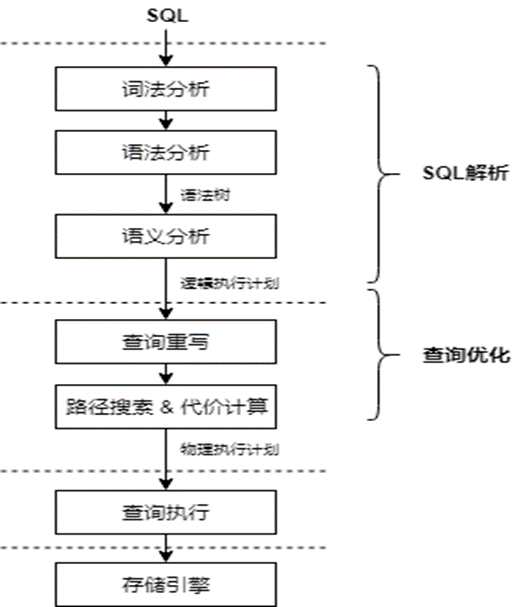

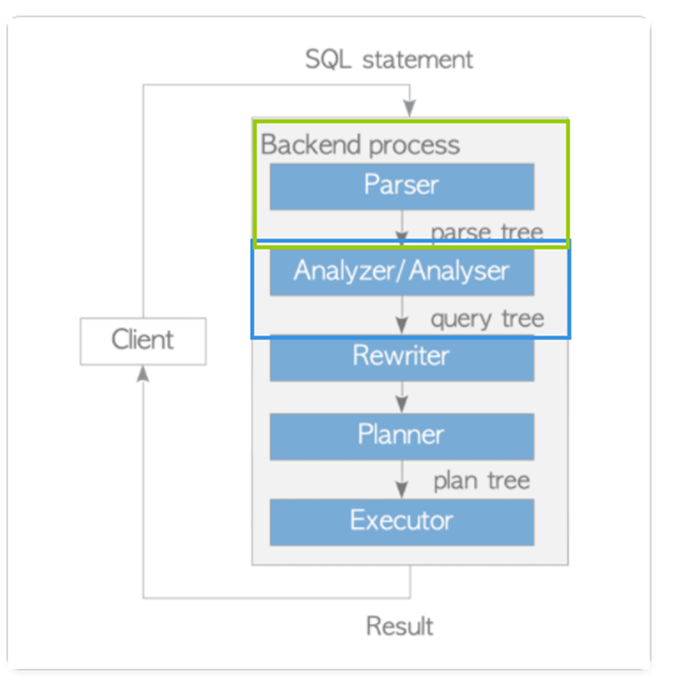

+SQL引擎整个编译的过程如下图所示,在编译的过程中需要对输入的SQL语言进行词法分析、语法分析、语义分析,从而生成逻辑执行计划,逻辑执行计划经过代数优化和代价优化之后,产生物理执行计划。

+

+SQL解析通常包含词法分析、语法分析、语义分析几个子模块。SQL是介于关系演算和关系代数之间的一种描述性语言,它吸取了关系代数中一部分逻辑算子的描述,而放弃了关系代数中"过程化"的部分,SQL解析主要的作用就是将一个SQL语句编译成为一个由关系算子组成的逻辑执行计划。

+

+数据库的SQL引擎是数据库重要的子系统之一,它对上负责承接应用程序发送过来的SQL语句,对下则负责指挥执行器运行执行计划。其中优化器作为SQL引擎中最重要、最复杂的模块,被称为数据库的"大脑",优化器产生的执行计划的优劣直接决定数据库的性能。右图为SQL引擎的各个模块的响应过程。下图的绿色部分代表解析树的生成,;蓝色部分代表查询树的生成部分。

+

+

+

+

+## 理论分析

+**SQL解析各模块功能介绍:**

+

+ 假设要在student表里找到查找序号为1的学生姓名,其SQL语句如下:

+

+> Select name

+>

+>from student

+>where no=1

+

+1. **词法分析:**

+

+> 从查询语句中识别出系统支持的关键字、标识符、运算符、终结符等,确定每个词固有的词性。分析结果如下图所示,可以看到一个SQL语句按一个一个的字词或符号分开,形成可以被解读语义的字符。

+

+ | **词性** | **内容** |

+ | ------------ | --------- |

+ | **关键字** | **Select、from、where** |

+ | **标识符** | **name、student、no** |

+ | **操作符** | **=** |

+ | **常量** | **1** |

+

+###### **(2)语法分析:**

+

+根据SQL的标准定义语法规则,使用词法分析中产生的词去匹配语法规则,如果一个SQL语句能够匹配一个语法规则,则生成对应的抽象语法树(AST)。

+

+下图中的\

+

+因为是在CentOS 7.6上装的openGauss,所以选择JDBC。

+

+JDBC Connectors可以不用从源码构建,直接从官网下载页下载即可。

+

+在Win上VSCode中配置好JAVA环境,需要Java11和Java8,配置该项目的JDK Runtime和Referenced Libraries(把下载解压得到的postgresql.jar加进去)

+

+代码:

+

+```java

+import java.sql.Connection;

+import java.sql.DriverManager;

+import java.sql.ResultSet;

+import java.sql.SQLException;

+import java.sql.Statement;

+import java.sql.Timestamp;

+import java.util.Properties;

+

+class openGaussTest {

+ public static void main(String[] args) {

+ System.out.println("=====START TEST=====");

+

+ Connection conn = getConnect("luooofan", "Luooofan1");

+

+ Statement stmt = null;

+ try {

+ stmt = conn.createStatement();

+ ResultSet rs = null;

+ try {

+ rs = stmt.executeQuery(

+ "select pro_c_id, pro_id, pro_status, pro_quantity, pro_income, pro_purchase_time from property;");

+ while (rs.next()) {

+ int pro_c_id = rs.getInt(1);

+ int pro_id = rs.getInt(2);

+ String pro_status = rs.getString(3);

+ int pro_quantity = rs.getInt(4);

+ int pro_income = rs.getInt(5);

+ Timestamp pro_pruchase_time = rs.getTimestamp("pro_purchase_time");

+ System.out.printf("%4d %4d %4s %4d %4d ", pro_c_id, pro_id, pro_status, pro_quantity, pro_income);

+ System.out.println(pro_pruchase_time);

+ }

+ } catch (SQLException e) {

+ if (rs != null) {

+ try {

+ rs.close();

+ } catch (SQLException e1) {

+ e1.printStackTrace();

+ }

+ }

+ e.printStackTrace();

+ }

+

+ stmt.close();

+ } catch (SQLException e) {

+ if (stmt != null) {

+ try {

+ stmt.close();

+ } catch (SQLException e1) {

+ e1.printStackTrace();

+ }

+ }

+ e.printStackTrace();

+ }

+

+ try {

+ conn.close();

+ } catch (SQLException e) {

+ e.printStackTrace();

+ }

+ }

+

+ public static Connection getConnect(String username, String passwd) {

+ // 驱动类

+ String driver = "org.postgresql.Driver";

+ // 数据库连接描述符

+ String sourceURL = "jdbc:postgresql://192.168.193.129:5432/finance";

+ Connection conn = null;

+

+ try {

+ // 加载驱动

+ Class.forName(driver);

+ } catch (Exception e) {

+ e.printStackTrace();

+ return null;

+ }

+

+ try {

+ // 创建连接

+ conn = DriverManager.getConnection(sourceURL, username, passwd);

+ System.out.println("Connection succeed!");

+ } catch (Exception e) {

+ e.printStackTrace();

+ return null;

+ }

+

+ return conn;

+ }

+}

+```

+

+NOTE:

+

+- 要执行什么操作就要赋予用户什么权限,代码中要对property表查询,故:`grant select on table property to luooofan;`

+

+- 因为CentOS没配置中文编码,所以直接在CentOS上查找的话应该无法显示中文,不过这并不影响在win 上远程连接然后查询并显示

+

+

+

+

+

+

+

+## References

+

+[openGauss Server&Connectors Official Download](https://opengauss.org/zh/download.html)

+

+[官方文档-快速入门](https://opengauss.org/zh/docs/2.0.1/docs/Quickstart/Quickstart.html)

+

+[官方文档-开发者指南](https://opengauss.org/zh/docs/2.0.1/docs/Developerguide/Developerguide.html)

+

+[openGauss数据库部署Linux遇到的问题](https://blog.csdn.net/RANGO_CSDN/article/details/118761322)

+

+[【数据库原理实验(openGauss)】 使用JDBC连接数据库](https://blog.csdn.net/BlacKingZ/article/details/117915010)

+

diff --git "a/content/zh/post/luooofan/openGauss\344\272\213\345\212\241\346\234\272\345\210\266-MVCC\346\212\200\346\234\257\347\232\204\345\256\236\347\216\260.md" "b/content/zh/post/luooofan/openGauss\344\272\213\345\212\241\346\234\272\345\210\266-MVCC\346\212\200\346\234\257\347\232\204\345\256\236\347\216\260.md"

new file mode 100644

index 0000000000000000000000000000000000000000..4ae8ddce50b0761fa50943aa845ea4e7329e7fcc

--- /dev/null

+++ "b/content/zh/post/luooofan/openGauss\344\272\213\345\212\241\346\234\272\345\210\266-MVCC\346\212\200\346\234\257\347\232\204\345\256\236\347\216\260.md"

@@ -0,0 +1,519 @@

++++

+title = "openGauss事务机制中MVCC技术的实现分析"

+date = "2021-11-27"

+tags = ["openGauss事务机制", "openGaussMVCC技术", "openGauss源码解析"]

+archives = "2021-11"

+author = "luooofan"

+summary = "分析openGauss2.0.1中MVCC技术的实现部分"

+img = "/zh/post/luooofan/title/openGauss.png"

++++

+

+# openGauss事务机制中MVCC技术的实现分析

+

+## 概述

+

+### 事务

+

+**事务**是为用户提供的最核心、最具吸引力的数据库功能之一。简单地说,事务是用户定义的一系列**数据库操作**(如查询、插入、修改或删除等)的**集合**,从数据库内部保证了该操作集合作为一个整体的原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)和持久性(Durability),这些特性统称事务的**ACID特性**。

+

+

+

+### DBMS中的并发控制

+

+并发控制旨在针对数据库中对**事务并行**的场景,保证 ACID 中的**一致性**(Consistency)与**隔离性**(Isolation)。数据库技术中主流的三种并发控制技术分别是: Multi-version Concurrency Control (MVCC), Strict Two-Phase Locking (S2PL), 以及 Optimistic Concurrency Control (OCC),每种技术也都有很多的变种。

+

+

+

+### MVCC

+

+MVCC的基本机制是:写事务不会原地修改元组内容,每次写操作都会在旧的版本之上创建新的版本,并且会保留旧的版本。当某个事务需要读取数据时,数据库系统会从所有的版本中选取出符合该事务隔离级别要求的版本。

+

+MVCC 的主要优点是读数据的锁请求与写数据的锁请求不冲突,以此来实现**读不阻塞写,写也不阻塞读**。

+

+

+

+### openGauss事务整体架构

+

+

+

+

+

+在openGauss中,事务的实现与存储引擎的实现有很强关联,代码主要集中在src/gausskernel/storage/access/transam及src/gausskernel/storage/lmgr下,关键文件如图所示。

+

+(1) 事务管理器:事务系统的中枢,它的实现是一个有限循环状态机,通过接受外部系统的命令并根据当前事务所处的状态决定事务的下一步执行过程。

+

+(2) 日志管理器:用来记录事务执行的状态以及数据变化的过程,包括事务提交日志(CLOG)、事务提交序列日志(CSNLOG)以及事务日志(XLOG)。其中CLOG日志只用来记录事务执行的结果状态,CSNLOG记录日志提交的顺序,用于可见性判断;XLOG是数据的redo日志,用于恢复及持久化。

+

+(3) 线程管理机制:通过一片内存区域记录所有线程的事务信息,任何一个线程可以通过访问该区域获取其他事务的状态信息。

+

+(4) MVCC机制:openGauss系统中,事务执行读流程结合各事务提交的CSN序列号,采用了多版本并发控制机制,实现了元组的读和写互不阻塞。

+

+(5) 锁管理器:实现系统的写并发控制,通过锁机制来保证事务写流程的隔离性。

+

+

+

+

+

+## MVCC的实现

+

+我们需要关注:

+

+- 元组版本号的实现

+- 快照的实现

+- 判断数据有效性、可见性、可更新性的算法的实现

+- 不同的隔离级别的实现

+

+### 多版本元组存储结构

+

+*src/include/access/htup.h*

+

+为了定义MVCC 中不同版本的数据,Opengauss在每个元组的头部信息HeapTupleHeaderData中引入了一些字段如下:

+

+```c++

+typedef struct HeapTupleHeaderData {

+ union {

+ HeapTupleFields t_heap; /* 存储该元组的一些描述信息 */

+ DatumTupleFields t_datum;

+ } t_choice;

+

+ ItemPointerData t_ctid; /* (块号,块内偏移) 存储用来记录当前元组或新元组的物理位置 */

+

+ /* Fields below here must match MinimalTupleData! */

+

+ uint16 t_infomask2;

+

+ uint16 t_infomask; /* various flag bits, see below */

+

+ uint8 t_hoff;

+

+ /* ^ - 23 bytes - ^ */

+

+ bits8 t_bits[FLEXIBLE_ARRAY_MEMBER];

+

+ /* MORE DATA FOLLOWS AT END OF STRUCT */

+} HeapTupleHeaderData;

+typedef HeapTupleHeaderData* HeapTupleHeader

+```

+

+HeapTupleFields

+

+```c++

+typedef struct HeapTupleFields {

+ ShortTransactionId t_xmin; /* 存放插入该 Tuple 时的 txid */

+ ShortTransactionId t_xmax; /* 存放删除或者更新该 Tuple 时的 txid,如果还没更新或者删除,那么置 0,表示无效 */

+

+ union {

+ CommandId t_cid; /* 创建或更新/删除该 Tuple 的命令在该事务内执行的所有 SQL 命令中的编号 */

+ ShortTransactionId t_xvac; /* old-style VACUUM FULL xact ID */

+ } t_field3;

+} HeapTupleFields;

+```

+

+t_infomask

+

+```c++

+#define HEAP_HASNULL 0x0001 /* has null attribute(s) */

+#define HEAP_HASVARWIDTH 0x0002 /* has variable-width attribute(s) */

+#define HEAP_HASEXTERNAL 0x0004 /* has external stored attribute(s) */

+#define HEAP_HASOID 0x0008 /* has an object-id field */

+#define HEAP_COMPRESSED 0x0010 /* has compressed data */

+#define HEAP_COMBOCID 0x0020 /* t_cid is a combo cid */

+#define HEAP_XMAX_EXCL_LOCK 0x0040 /* xmax is exclusive locker */

+#define HEAP_XMAX_SHARED_LOCK 0x0080 /* xmax is shared locker */

+/* if either LOCK bit is set, xmax hasn't deleted the tuple, only locked it */

+#define HEAP_IS_LOCKED (HEAP_XMAX_EXCL_LOCK | HEAP_XMAX_SHARED_LOCK)

+#define HEAP_XMIN_COMMITTED 0x0100 /* t_xmin committed */

+#define HEAP_XMIN_INVALID 0x0200 /* t_xmin invalid/aborted */

+#define HEAP_XMIN_FROZEN (HEAP_XMIN_INVALID | HEAP_XMIN_COMMITTED)

+#define HEAP_XMAX_COMMITTED 0x0400 /* t_xmax committed */

+#define HEAP_XMAX_INVALID 0x0800 /* t_xmax invalid/aborted */

+...

+```

+

+

+

+### 插入、删除、更新元组

+

+#### 元组在页中是如何存放的

+

+

+

+

+

+#### 插入

+

+假设一个txid为99的事务插入一个元组

+

+

+

+#### 删除

+

+假设一个txid为111的事务删除一个元组

+

+

+

+#### 更新

+

+假设99号事务插入的元组被100号事务更新了两次

+

+

+

+openGauss通过HeapTupleHeaderData 的几个特殊的字段,给元组设置了不同的版本号,元组的每次更新操作都会产生一条新版本的元组,版本之间从旧到新形成了一条版本链(旧的ctid指向新的元组)。

+

+

+

+### 事务快照的实现

+

+为了实现元组对事务的可见性判断,openGauss引入了事务快照SnapshotData

+

+在openGauss中,有两种方式来实现快照。

+

+#### (1)活跃事务数组方法

+

+在数据库进程中,维护一个**全局的数组**,其中的成员为**正在执行的事务信息**,包括事务的事务号,该数组即活跃事务数组。

+

+在每个事务开始的时候,复制一份该数组内容。

+

+当事务执行过程中扫描到某个元组时,需要通过判断元组xmin和xmax这两个事务对于查询事务的可见性,来决定该元组是否对查询事务可见。

+

+

+

+

+

+

+

+#### (2)时间戳方法

+

+

+

+在openGauss内部,使用一个全局自增的长整数作为逻辑的时间戳,模拟数据库内部的时序,该逻辑时间戳被称为提交顺序号(Commit Sequence Number,简称CSN)。

+

+每当一个事务提交的时候,在CSN日志中会记录该事务号 XID对应的逻辑时间戳 CSN 值。

+

+

+

+```c++

+#define COMMITSEQNO_INPROGRESS UINT64CONST(0x0) // 表示该事务还未提交或回滚

+#define COMMITSEQNO_ABORTED UINT64CONST(0x1) // 表示该事务已经回滚

+#define COMMITSEQNO_FROZEN UINT64CONST(0x2) // 表示该事务已提交,且对任何快照可见

+#define COMMITSEQNO_FIRST_NORMAL UINT64CONST(0x3) // 事务正常的CSN号起始值

+#define COMMITSEQNO_COMMIT_INPROGRESS (UINT64CONST(1) << 62) // 事务正在提交中

+```

+

+

+

+#### 事务快照数据结构SnapshotData

+

+*src/include/utils/snapshot.h*

+

+获取快照时会记录当前活跃的最小的xid,记为snapshot.xmin。当前最新提交的“事务id(latestCompleteXid) + 1”,记为snapshot.xmax。当前最新提交的“CSN号 + 1”(NextCommitSeqNo),记为snapshot.csn。

+

+```c++

+typedef struct SnapshotData {

+ SnapshotSatisfiesFunc satisfies; /* 判断可见性的函数;通常使用MVCC,即HeapTupleSatisfiesMVCC */

+ TransactionId xmin; /*当前活跃事务最小值,小于该值的事务说明已结束 */

+ TransactionId xmax; /*最新提交事务id(latestCompeleteXid)+1,大于等于改值说明事务还未开始,该事务id不可见 */

+ TransactionId* xip; /*记录当前活跃事务链表,在CSN版本中该值无用 */

+ TransactionId* subxip; /* 记录缓存子事务活跃链表,在CSN版本中该值无用 */

+ uint32 xcnt; /* 记录活跃事务的个数(xip中元组数)在CSN版本中该值无用 */

+ ...

+

+ CommitSeqNo snapshotcsn; /* 快照的CSN号,一般为最新提交事务的CSN号+1(NextCommitSeqNo),CSN号严格小于该值的事务可见。 */

+ ...

+

+ CommandId curcid; /*事务块中的命令序列号,即同一事务中,前面插入的数据,后面可见。 */

+ uint32 active_count; /* ActiveSnapshot stack的refcount */

+ uint32 regd_count; /* RegisteredSnapshotList 的refcount*/

+ void* user_data; /* 本地多版本快照使用,标记该快照还有线程使用,不能直接释放 */

+ SnapshotType snapshot_type; /* openGauss单机无用 */

+} SnapshotData;

+```

+

+satisfies是openGauss提供的对于事务可见性判断的统一操作接口。

+

+*src/gausskernel/storage/access/heap/heapam_visibility.c*

+

+- HeapTupleSatisfiesMVCC:判断元组对某一快照版本是否有效

+- HeapTupleSatisfiesUpdate:判断元组是否可更新

+- HeapTupleSatisfiesDirty:判断当前元组是否已脏

+- HeapTupleSatisfiesSelf:判断tuple对自身信息是否有效

+- HeapTupleSatisfiesToast:用于TOAST表(参考[文档](httpss://www.postgresql.org/docs/10/static/storage-toast.html))的判断

+- HeapTupleSatisfiesVacuum:用在VACUUM,判断某个元组是否对任何正在运行的事务可见,如果是,则该元组不能被VACUUM删除

+- HeapTupleSatisfiesAny:所有元组都可见

+- HeapTupleSatisfiesHistoricMVCC:用于CATALOG 表

+- ……

+

+

+

+#### MVCC可见性判断机制

+

+| 状态 | xmax对于查询可见 | xmax对于查询不可见 |

+| :----------------: | :--------------------------: | :--------------------------: |

+| xmin对于查询可见 | 记录不可见(先插入,后删除) | 记录可见(先插入,未删除) |

+| xmin对于查询不可见 | 不可能发生 | 记录不可见(未插入,未删除) |

+

+##### XidVisibleInSnapshot

+

+*src/gausskernel/storage/access/heap/heapam_visibility.c*

+

+```c++

+bool XidVisibleInSnapshot(TransactionId xid, Snapshot snapshot, TransactionIdStatus* hintstatus, Buffer buffer, bool* sync)

+{

+ bool looped = false;

+ *hintstatus = XID_INPROGRESS;

+ if (GTM_MODE && TransactionIdFollowsOrEquals(xid, snapshot->xmax)) {

+ return false;

+ }

+loop:

+ csn = TransactionIdGetCommitSeqNo(xid, false, true, false);

+ if (COMMITSEQNO_IS_COMMITTED(csn)) {

+ *hintstatus = XID_COMMITTED;

+ if (csn < snapshot->snapshotcsn)

+ return true;

+ else

+ return false;

+ } else if (COMMITSEQNO_IS_COMMITTING(csn)) {

+ ...

+ } else {

+ if (csn == COMMITSEQNO_ABORTED)

+ *hintstatus = XID_ABORTED;

+ return false;

+ }

+}

+```

+

+如果xid事务正在执行:

+

+```c++

+if (looped) {

+ ereport(DEBUG1, (errmsg("transaction id %lu's csn %ld is changed to ABORT after lockwait.", xid, csn)));

+ RecheckXidFinish(xid, csn);

+ CSNLogSetCommitSeqNo(xid, 0, NULL, COMMITSEQNO_ABORTED);

+ SetLatestFetchState(xid, COMMITSEQNO_ABORTED);

+ *hintstatus = XID_ABORTED;

+ return false;

+} else {

+ if (!COMMITSEQNO_IS_SUBTRANS(csn)) {

+ ...

+ CommitSeqNo latestCSN = GET_COMMITSEQNO(csn);

+ if (latestCSN >= snapshot->snapshotcsn) {

+ ...

+ return false;

+ }

+ } else {

+ parentXid = (TransactionId)GET_PARENTXID(csn);

+ }

+ ...

+ if (TransactionIdIsValid(parentXid))

+ SyncWaitXidEnd(parentXid, buffer);

+ else

+ SyncWaitXidEnd(xid, buffer);

+ looped = true;

+ parentXid = InvalidTransactionId;

+ goto loop;

+}

+```

+

+##### HeapTupleSatisfiesMVCC

+

+

+```c++

+static bool HeapTupleSatisfiesMVCC(HeapTuple htup, Snapshot snapshot, Buffer buffer)

+{

+ // 取元组头

+ HeapTupleHeader tuple = htup->t_data;

+ ...

+ // 根据hint bit,若xmin没有被标记为已提交:可能被标记为回滚,或者还未标记

+ if (!HeapTupleHeaderXminCommitted(tuple)) {

+ // 如果xmin已经被标记为invalid,说明插入该元组的事务已经回滚,直接返回不可见

+ if (HeapTupleHeaderXminInvalid(tuple))

+ return false;

+ // xmin还未标记,并且xmin为当前事务,说明是在同一个事务内的插入命令和扫描命令,则需要去判断CID

+ // 同一个事务内,后面的查询可以查到当前事务之前命令插入的并且未删除的结果

+ if (TransactionIdIsCurrentTransactionId(HeapTupleHeaderGetXmin(page, tuple))) {

+ if ((tuple->t_infomask & HEAP_COMBOCID) && CheckStreamCombocid(tuple, snapshot->curcid, page))

+ return true; /* delete after stream producer thread scan started */

+

+ // 当前扫描命令之后的某条命令才插入

+ if (HeapTupleHeaderGetCmin(tuple, page) >= snapshot->curcid)

+ return false; /* inserted after scan started */

+ // 到这里说明当前扫描命令之前已经插入

+ // 根据hint bit,xmax被标记为invalid

+ if (tuple->t_infomask & HEAP_XMAX_INVALID)

+ return true;

+

+ ...

+

+ // 当前扫描命令之后的某条命令删除了该元组

+ if (HeapTupleHeaderGetCmax(tuple, page) >= snapshot->curcid)

+ return true; /* deleted after scan started */

+ else

+ return false; /* deleted before scan started */

+ }

+ // xmin还没打标记,并且不是当前事务

+ else {

+ // 通过csnlog判断事务是否可见,并且返回该事务的最终提交状态

+ visible = XidVisibleInSnapshot(HeapTupleHeaderGetXmin(page, tuple), snapshot, &hintstatus, buffer, NULL);

+ // 如果该事务提交,则打上提交的hint bit用于加速判断

+ if (hintstatus == XID_COMMITTED)

+ SetHintBits(tuple, buffer, HEAP_XMIN_COMMITTED, HeapTupleHeaderGetXmin(page, tuple));

+ // 如果事务回滚,则打上回滚标记

+ if (hintstatus == XID_ABORTED) {

+ ...

+ SetHintBits(tuple, buffer, HEAP_XMIN_INVALID, InvalidTransactionId);

+ }

+ // 如果xmin不可见,则该元组不可见

+ if (!visible) {

+ ...

+ return false;

+ }

+ }

+ }

+ // 根据hint bit,若xmin已经被标记为已提交,则通过函数接口CommittedXidVisibleInSnapshot判断是否对本次快照可见

+ else {

+ /* xmin is committed, but maybe not according to our snapshot */

+ if (!HeapTupleHeaderXminFrozen(tuple) &&

+ !CommittedXidVisibleInSnapshot(HeapTupleHeaderGetXmin(page, tuple), snapshot, buffer)) {

+ if (...) {

+ return false; /* treat as still in progress */

+ }

+ }

+ }

+ // 到此为止认为xmin visible,继续判断xmax的可见性

+

+recheck_xmax:

+ // 根据hint bit,xmax已经被标记为invalid,即已经回滚

+ if (tuple->t_infomask & HEAP_XMAX_INVALID) /* xid invalid or aborted */

+ return true;

+

+ ... // 还有一些其他状态判断

+

+ // 根据hint bit,xmax没有被标记为commited

+ if (!(tuple->t_infomask & HEAP_XMAX_COMMITTED)) {

+ bool sync = false;

+ TransactionId xmax = HeapTupleHeaderGetXmax(page, tuple);

+

+ // 如果xmax为当前事务

+ if (TransactionIdIsCurrentTransactionId(HeapTupleHeaderGetXmax(page, tuple))) {

+ // 如果删除该元组的命令后发生于快照扫描时刻

+ if (HeapTupleHeaderGetCmax(tuple, page) >= snapshot->curcid)

+ return true; /* deleted after scan started */

+ else

+ return false; /* deleted before scan started */

+ }

+

+ visible = XidVisibleInSnapshot(HeapTupleHeaderGetXmax(page, tuple), snapshot, &hintstatus, buffer, &sync);

+ /*

+ * If sync wait, xmax may be modified by others. So we need to check xmax again after acquiring the page lock.

+ */

+ if (sync && (xmax != HeapTupleHeaderGetXmax(page, tuple))) {

+ goto recheck_xmax;

+ }

+ // 根据hintstatus在元组头部打标记 hint bit

+ if (hintstatus == XID_COMMITTED) {

+ SetHintBits(tuple, buffer, HEAP_XMAX_COMMITTED, HeapTupleHeaderGetXmax(page, tuple));

+ }

+ if (hintstatus == XID_ABORTED) {

+ ...

+ SetHintBits(tuple, buffer, HEAP_XMAX_INVALID, InvalidTransactionId);

+ }

+ if (!visible) {

+ if (...) {

+ if (sync && (xmax != HeapTupleHeaderGetXmax(page, tuple))) {

+ goto recheck_xmax;

+ }

+ return true; /* treat as still in progress */

+ }

+ }

+ }

+ // 根据hint bit,xmax被标记为commited

+ else {

+ /* xmax is committed, but maybe not according to our snapshot */

+ if (!CommittedXidVisibleInSnapshot(HeapTupleHeaderGetXmax(page, tuple), snapshot, buffer)) {

+ if (...) {

+ return true; /* treat as still in progress */

+ }

+ }

+ }

+ return false;

+}

+```

+

+

+

+

+

+

+

+### 隔离级别的实现

+

+| 隔离级别 | P0:脏写 | P1:脏读 | P4:更新丢失 | P2:不可重复读 | P3:幻读 | A5A:读偏斜 | A5B:写偏斜 |

+| ------------ | -------- | -------- | ----------- | -------------- | ------- | ---------- | ---------- |

+| 读未提交 | 不可能 | 可能 | 可能 | 可能 | 可能 | 可能 | 可能 |

+| 读已提交 | 不可能 | 不可能 | 可能 | 可能 | 可能 | 可能 | 可能 |

+| 可重复读 | 不可能 | 不可能 | 不可能 | 不可能 | 可能 | 不可能 | 不可能 |

+| 快照一致性读 | 不可能 | 不可能 | 不可能 | 不可能 | 偶尔 | 不可能 | 可能 |

+| 可串行化 | 不可能 | 不可能 | 不可能 | 不可能 | 不可能 | 不可能 | 不可能 |

+

+(1)**脏写(dirty write)**:两个事务分别写入,两个事务分别提交或回滚,则事务的结果无法确定,即一个事务可以回滚另一个事务的提交。

+

+(2)**脏读(dirty read)**:一个事务可以读取另一个事务未提交的修改数据。

+

+(3)**不可重复读(fuzzy read)**:一个事务重复读取前面读取过的数据,数据的结果被另外的事务修改。

+

+(4)**幻读(phantom)**:一个事务重复执行范围查询,返回一组符合条件的数据,每次查询的结果集因为其他事务的修改发生改变(条数)。

+

+(5)**更新丢失(lost update)**:一个事务在读取元组并更新该元组的过程中,有另一个事务修改了该元组的值,导致最终这次修改丢失。

+

+(6)**读偏斜(read skew)**:假设数据x,y有隐式的约束x+y=100;事务一读取x=50;事务二写x=25并更新y=75保证约束成立,事务二提交,事务一再读取y=75,导致事务一中读取x+y=125,不满足约束。

+

+(7)**写偏斜(write skew)**:假设数据x,y有隐式的约束x+y<=100;事务一读取x=50,并写入y=50;事务二读取y=30并写入x=70,并提交;事务一再提交;最终导致x=70,y=50不满足x+y<=100的约束。

+

+

+

+隔离级别越高,在一个事务执行过程中,它能“感知”到的并发事务的影响越小。在最高的可串行化隔离级别下,任意一个事务的执行,均“感知”不到有任何其他并发事务执行的影响,并且所有事务执行的效果就和一个个顺序执行的效果完全相同。

+

+在openGauss中,隔离级别的实现基于MVCC和快照机制,因此这种隔离方式被称为快照隔离(`Snapshot Isolation`,SI)。目前,openGauss支持读已提交和可重复读这两种隔离级别。两者实现上的差别在于在一个事务中获取快照的次数。(在实现上可重复读隔离级别无幻读问题,有A5B写偏斜问题)

+

+

+如果采用读已提交的隔离级别,那么在一个事务块中每条语句的执行开始阶段,都会去获取一次最新的快照,从而可以看到那些在本事务块开始以后、在前面语句执行过程中提交的并发事务的效果。

+

+如果采用可重复读的隔离级别,那么在一个事务块中,只会在第一条语句的执行开始阶段,获取一次快照,后面执行的所有语句都会采用这个快照,整个事务块中的所有语句均不会看到该快照之后提交的并发事务的效果。

+

+

+

+

+

+

+

+## 总结

+- **元组版本号的实现**:使用元组头部信息的字段来标示元组的版本号

+- **快照的实现**:活跃事务数组方法和时间戳方法

+- **判断数据有效性、可见性、可更新性的算法的实现**: `XidVisibleInSnapshot`和`HeapTupleSatisfiesMVCC`

+- **不同隔离级别的实现**:在一个事务中获取快照的次数

+

+

+

+## 参考资料

+

+[知乎:openGauss数据库源码解析系列文章](https://www.zhihu.com/column/c_1358363246349635584)

+

+[CSDN:openGauss事务机制](https://blog.csdn.net/GaussDB/article/details/116058155)

+

+[The Internals of PostgreSQL](https://www.interdb.jp/pg/pgsql05.html)

+

+[PgSQL · 特性分析 · MVCC机制浅析](http://mysql.taobao.org/monthly/2017/10/01)

+

+[PosrgreSQL 学习计划——Vacuum 清理机制](https://blog.yasking.org/a/postgresql-vacuum.html)

+

+[PostgreSql pageinspect 更深的理解PG](https://www.modb.pro/db/24577)

+

+[openGauss的MVCC以及vacuum机制源码解析—CSN LOG](https://blog.opengauss.org/zh/post/minshengyunwei/opengauss%E7%9A%84mvcc%E4%BB%A5%E5%8F%8Avacuum%E6%9C%BA%E5%88%B6%E6%BA%90%E7%A0%81%E8%A7%A3%E6%9E%90csn-log/)

+

+[浅谈数据库并发控制 - 锁和 MVCC](https://draveness.me/database-concurrency-control/)

+

+[PostgreSQL MVCC可见性判断](https://cloud.tencent.com/developer/article/1598195)

+

+

+

+

diff --git a/content/zh/post/luooofan/title/openGauss.png b/content/zh/post/luooofan/title/openGauss.png

new file mode 100644

index 0000000000000000000000000000000000000000..86a420b92fb8289658d807d49f137b6d13862f6d

Binary files /dev/null and b/content/zh/post/luooofan/title/openGauss.png differ

diff --git a/content/zh/post/luooofan/title/title1.png b/content/zh/post/luooofan/title/title1.png

new file mode 100644

index 0000000000000000000000000000000000000000..830c8bc490a1b830e759df1f04b453909a097406

Binary files /dev/null and b/content/zh/post/luooofan/title/title1.png differ

diff --git "a/content/zh/post/luoyuchen/OpenGauss\346\225\260\346\215\256\345\272\223\345\256\211\350\243\205\344\270\216\344\275\277\347\224\250.md" "b/content/zh/post/luoyuchen/OpenGauss\346\225\260\346\215\256\345\272\223\345\256\211\350\243\205\344\270\216\344\275\277\347\224\250.md"

new file mode 100644

index 0000000000000000000000000000000000000000..6d3397d9c001bfe0427f35d6dd84d63e78b1b14c

--- /dev/null

+++ "b/content/zh/post/luoyuchen/OpenGauss\346\225\260\346\215\256\345\272\223\345\256\211\350\243\205\344\270\216\344\275\277\347\224\250.md"

@@ -0,0 +1,224 @@

++++

+

+title = "OpenGauss数据库安装与使用"

+

+date = "2021-11-27"

+

+tags = ["OpenGauss数据库安装与使用"]

+

+archives = "2021-11"

+

+author = "罗宇辰"

+

+summary = "OpenGauss数据库安装与使用"

+

+img = "/zh/post/luoyuchen/title/1.png"

+

+times = "13:50"

+

++++

+

+# OpenGauss数据库安装与使用报告

+

+### 1.获取openGauss安装包

+

+在 https://opengauss.org/zh/download.html 官网上下载安装包

+

+

+

+这里我安装的是极简版。

+

+

+

+### 2.CentOS设置

+

+####1)CentOS版本

+CentOS7

+

+

+####2)centos网络连接设置

+>cd /etc/sysconfig/network-scripts #进入网络配置文件目录

+ls #找到目录下第一个文件

+vi 文件名 #用vi修改配置

+

+

+最后一行改为yes。

+>service network restart #重启网卡,使配置生效

+

+####3)yum安装图形化界面(非必须)

+>yum groupinstall -y "GNOME Desktop"

+

+安装完重启。在命令行界面输入

+>startx

+

+进入图形化界面。

+

+